Von Oktober bis Dezember 2013 war der Medienkünstler und Musiker Ignacio Cuevas Puyol, aka White Sample, für eine Residency im Ars Electronica Futurelab. Während seiner Residency hat Ignacio ein Synthesizer Modul entwickelt, den Digital Logic Noise Generator (DLN). Dabei handelt es sich um ein Arduino-basiertes Synthmodul, das per USB programmiert wird und 4 Audio-Outs + Summe verfügt. Der Audioloop kann mittels Drehpoti bearbeitet werden. Die Idee von Ignacio war es, den Prozess von „C one liners“ in der Produktion von digitaler Musik in ein analoges Medium zu übersetzen. Am Ende dieser Residency hat Ignacio gemeinsam mit einigen Mitgliedern des Ars Electronica Futurelabs den Sound dieses Digital Logic Noise Generators in einer live Performance im Deep Space demonstriert.

Um an diesen Erfolg der ersten live Performance anzuschließen, hat sich Ignacio wieder mit raum.null, bestehend aus Chris Bruckmayr (Ars Electronica Futurelab) und dem serbischen Soundkünstler und Wissenschaftler Dobrivoje Milijanovic, für eine weitere Performance während des Ars Electronica Festivals 2014 zusammengetan. Gemeinsam mit dem Digital Logic Noise Generator verwendeten sie weitere elektronische Soundelemente, wie Synthmodule und analoge Noise Elementen. Für die live Visualisierung wurden die Soundkünstler durch die Ars Electronica Futurelab Mitglieder Veronika Pauser (VeroVisual) und Peter Holzkorn (voidsignal) unterstützt. Darüber hinaus hat Michael Platz (auch aus dem Ars Electronica Futurelab) einen Body-Controller entwickelt, der von Veronika genutzt wurde, um die live Visualisierung in Echtzeit zu beeinflussen.

Die außergewöhnliche und herausfordernde Performance, in der auch mit neuen Anwendungen und Technologien experimentiert wurde, fand am Freitagabend im Rahmen des Ars Electronica Festival statt und wurde zu einem besonderen Erfolg. Mehr als doppelt so viele BesucherInnen als erwartet haben sich die Performance angesehen und das Team mit positivem Feedback angesprochen. In diesem Interview gibt das Quadrature-Team Einblicke in die Ideen und technischen Hintergründe ihres Auftritts.

Ignacio, es war großartig, dich wieder in Linz zu haben. Wie war es für dich wieder nach Linz zurückzukommen und mit einigen Mitgliedern des Ars Electronica Futurelabs an einer neuen live Performance zu arbeiten?

Ignacio Cuevas Puyol: Es ist alles sehr gut gelaufen und natürlich war es großartig am Festival teilzunehmen. Ich bin mit dem Ergebnis der Zusammenarbeit mit Chris, Veronika, Peter und Michael vom Futurelab und Dobrivoje, der sich um die Soundtechnik gekümmert hat, sehr zufrieden. Der Gesamteindruck war sehr positiv und wir bekamen auch sehr gutes Feedback vom Publikum.

Könntest du uns den Hintergrund zur Performance erklären und erzählen, wie sich das Konzept entwickelt hat?

Ignacio Cuevas Puyol: Wir nannten die Performance QUADRATURE, weil das Ursprungskonzept aus dem Zusammenbringen von vier Elementen bestand: zwei Audioquellen (raum.null und White Sample) und zwei Videoquellen (VeroVisual und voidsignal).

Impression Quadrature (Still aus den Aufnahmen von Michael Mayr)

Die Atmosphäre der Performance hatte etwas sehr rituelles an sich: das Spielen am Boden, herumkriechen zwischen Kabeln und Audiogeräten und die große Projektion hinter uns, die von Veronika und Peter mit Bildern aus der Natur in schwarz-weiß überlagert und mit generativen Geometrien und parametrischen Effekten bespielt wurde. Da ist diese dunkle und okkulte Grundstimmung und das Licht, das sich aus den Audiofrequenzen auf das Video überträgt und dort einige Parameter kontrolliert; alles war dadurch eine große Welle aus Dunkelheit und Licht, umspielt von der Wolke aus Noise die sich über die Zeit bewegt und verwandelt.

Die Idee entstand über Emails, in denen wir das Konzept und die verwendeten Technologien besprochen haben. Ich muss sagen, dass Veronika und Peter eine großartige Leistung erbracht haben. Das Ergebnis war besser als das, was ich im Kopf hatte. Mit Chris habe ich eine starke Verbindung über unsere Liebe zum analogen Noise. Daher war ich sehr zuversichtlich im Hinblick auf seinen Teil.

Strukturell gesehen hatten wir bei der Performance keine genauen Vorgaben im Hinblick auf Intro/Hauptteil/Outro, das hat sich alles ganz natürlich entwickelt. Ich mag den Gedanken, den Ablauf im Sinne der Intensität als etwas wie das Wetter zu betrachten, das sich auf natürlichem Wege verändert, von sonnig zu regnerisch und alles dazwischen.

Impression Quadrature (Still aus den Aufnahmen von Michael Mayr)

Gibst du uns einen kurzen Überblick über das technische Setup, das ihr zur Umsetzung dieser Idee genutzt habt?

Ignacio Cuevas Puyol: Ich habe meinen modularen Synthesizer bedient, der über rund 30 unterschiedliche Module verfügt. Eines davon war der „Digital Logic Noise Generator“, den ich letztes Jahr während meines Residency-Aufenthalts im Ars Electronica Futurelab entwickelt habe. Dieses kleine Modul war der Ausgangspunkt für die erste Performance und nun auch für die jetzige während dem Festival.

[youtube=http://www.youtube.com/watch?v=bGfqWjRNL38&w=610]

Zuerst habe ich eine Frage zum Sound: Ignacio, Chris und Dobri, der Sound war euer Teil. Wie habt ihr den Digital Logic Noise Generator verwendet und wie haben sich eure Ideen seit Dezember 2013 weiterentwickelt?

Ignacio Cuevas Puyol: Der DLN erzeugt Sound und ist durch andere Module wie z.B. Sequenzer, Auftastgeneratoren, LFOs gesteuert. Der DLN hat vier separate Kanäle und somit kann jeder einzelne dieser Kanäle mit anderen Modulen verbunden werden um eine komplexe Synthese zu erzeugen. Zusätzlich hatte ich andere Module dabei, die Sound erzeugen (Oszillatoren) und durch dieselben Sequencer, Teiler etc. wie der DLN gesteuert wurden.

Nachdem ich mit Chris mit diesen technischen Setup vergangenes Jahr herumexperimentiert habe, war ich von den sich daraus ergebenden Möglichkeiten besonders angetan. Während meiner Residency habe ich auch das Soundlab im Ars Electronica genutzt und habe mit Chris gejammed, was sehr nett war und wir beide waren überaus glücklich mit den Ergebnissen.

Während der Performance hatten wir Dobri zwischen uns, der mein Setup und jenes von Chris zusammengeführt hat und die Höhen überwacht und ausgeglichen hat. Dabei hat er auch das Sampling einiger Teile von uns beiden übernommen und eine dritte Ebene von Noise Loops geschaffen. Das war eine blendende Idee, meiner Meinung nach.

raum.null: Das generelle musikalische Konzept fußt auf dem Zusammenspiel (der dynamischen Verschmelzung) der eher technischen Sounds von Ignacio’s modularem Synthesizer System und meinem Netzwerk aus analogen experimentellen Soundgeneratoren. Beide Soundquellen laufen bei Dobri in einem Looping System zusammen und ergeben diesen dynamischen Raum aus Frequenzschichtungen. Diese akustische Umgebung findet sich in den Visualisierung wieder. Organische, biologische Strukturen und geometrische Elemente im Zusammenspiel. Quasi: das pralle Leben auf diesem Planeten und die dahinterstehenden unsichtbaren mathematischen Bildekräfte.

Impression Soundkünstler und Setup (Still aus den Aufnahmen von Michael Mayr)

Veronika und Peter, ihr wart für die Visuals verantwortlich. Ihr habt euch dabei einiger Besonderheiten für die live Performance bedient, wie z.B. einem Body-Controller um die Visuals in Echtzeit zu beeinflussen. Auch die Programmierung der live Renderings war eine besondere Herausforderung. Gebt ihr uns ein paar Einblicke in das Making-of?

Veronika Pauser: Ausgangspunkt bildeten einige Ideen, die Ignacio für die Visuals zu seinen Sounds hatte. Die Stimmung, die er ausdrücken wollte, vermittelte er uns durch beispielhafte Bilder. Chris und ich entwickelten daraufhin das künstlerische Thema einer „brutalen Natur“, die urbane Strukturen zurückerobert. Für die Visuals wollten wir daher Elemente wie Wolken, Wald oder Meer nutzen. Zusätzlich wurde das Videomaterial mit Peters generativen Echtzeitgrafiken überlagert, wodurch sich eine surreale Atmosphäre ergab.

Mit der scheinbaren Antithese zwischen Technologie und Natur, zwischen Zukunft und Tradition, spielten wir auch noch auf einer anderen Ebene, und zwar indem wir elektrisch leitende Farbe verwendeten, um mein Gesicht im Stil des Tā moko, der traditionellen Gesichtstätowierung der Maori, zu bemalen. Die leitende Farbe war Teil einer Körpersteuerung, die Michael heuer bereits für eine raum.null-Performance entwickelt hat. Ich stehe solchen Dingen sehr offen gegenüber und versuche öfters, neue Interaktionsformen in meine Performances einzubauen. In der Vergangenheit habe ich zum Beispiel mit der Nintendo Wii oder der Microsoft Xbox Kinect experimentiert, um Körperbewegungen für die Steuerung visueller Inhalte zu nutzen. Bei Quadrature ging das noch einen Schritt weiter, da diesmal ja meine Haut als Interface fungierte.

Wie habt Ihr die stromleitende Farbe denn in Dein Gesicht bekommen?

Veronika Pauser: Michael Mayr, ein weiterer Futurelab-Kollege, hat eine Tattoo-Vorlage entworfen, die ich mit einem Schneidplotter auf Klebefolie übertragen konnte. Wir nutzten diese Vorlagen als Negative für die Gesichtsbemalung. Das Ausmalen dauerte fast eine Stunde.

Bemalung mit stromleitender Farbe (Foto: Peter Freudling)

Die leitende Farbe wurde dann mit Elektroden verbunden, genauso wie mein rechter Zeigefinger. Wenn ich während der Performance einen bestimmten Bereich in meinem Gesicht berührte, wurde der Stromkreis geschlossen und dadurch eine Midi-Note ausgelöst, die ich dann wiederum mit einem bestimmten Effekt in der Software verknüpft habe. So konnte ich die Visualisierungen nur durch die Berührung meiner Haut kontrollieren. An einem bestimmten Punkt in der Performance wurde mein Gesicht, überlagert von Peters Partikeln, in der Projektion gezeigt, was den surrealen Gesamteindruck noch verstärkte.

(GIF: Veronika Pauser)

Ich habe mich sehr schnell an diesen futuristischen Cyborg-Look gewöhnt. Vor der eigentlichen Performance machten wir einen Versuch und malten ein kleines pflanzenartiges Muster in mein Gesicht. Draußen auf der Straße hatte ich den Eindruck, dass die Menschen plötzlich viel offener auf mich zugingen. Überraschenderweise reagierten sie sehr positiv und lächelten mich an. Vielleicht haben sie nur geglaubt, dass ich verrückt sei, aber ich hab ihr Verhalten mir gegenüber durchaus sehr genossen.

Peter, was möchtest du noch zur Visualisierung sagen?

Peter Holzkorn: Konzeptuell gesehen haben wir beide unsere ästhetischen Interessen, die einflossen; zudem gab uns Ignacio diesmal eine visuelle Richtung vor, in die er die Perfomance gehen lassen wollte. Veronika und ich überarbeiteten gemeinsam unsere jeweiligen Beiträge, vereinbarten einen losen dramaturgischen Bogen und ließen uns ansonsten einfach vom Sound leiten.

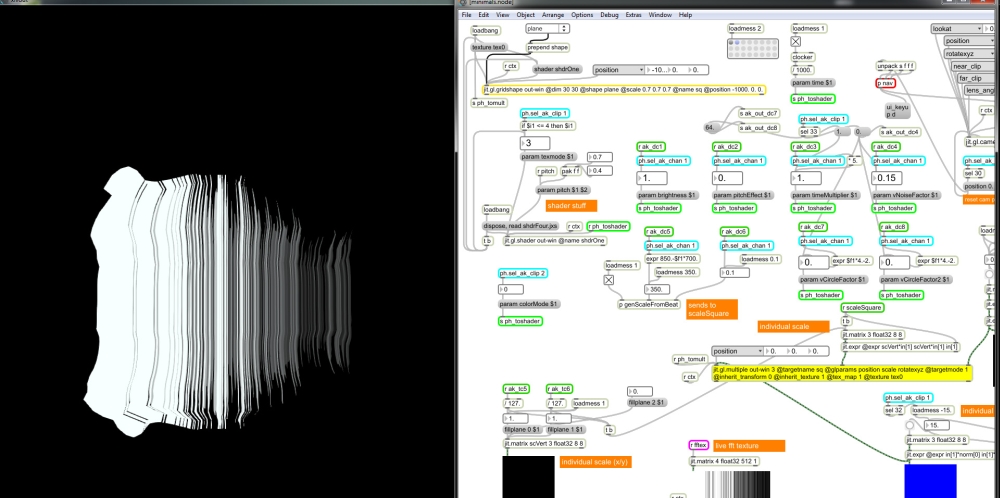

(Screenshot: Peter Holzkorn)

Wie schon bei der Performance im letzten Jahr hatten wir ein zweistufiges Setup: Ich hatte ein paar Programme entwickelt, die generative Echtzeitgrafik produzierten. Deren Output wurde in ein VJ-Toolkit gefüttert, wo sie von Veronika mit Videomaterial und Effekten kombiniert wurden. Sowohl die generativen Programme als auch die VJ-Software reagierten auf Echtzeit-Soundanalyse und haptische Interfaces in Form von MIDI-Controllern und dem Body-Controller. Durch dieses Setup hatten wir beide die Freiheit, unsere jeweiligen Komponenten unabhängig voneinander zu steuern, während der Output, die Summe der einzelnen Teile, dynamische und interessanter war als es eine individuelle Performance hätte sein können.

Technisch gesehen möchte ich zwei Dinge erwähnen: Erstens möchte ich mich bei Florian Berger (Ars Electronica Futurelab) für seinen Support bei einem der generativen Algorithmen bedanken – es ist fantastisch, von solch talentierten und hilfsbereiten Kollegen umgeben zu sein. Zweitens war das derzeitige Setup nur durch Spout möglich, eine großartige neue Library, die GPU-basiertes Inter-Process Texture-Sharing unter Windows ermöglicht, ähnlich wie Syphon unter OS X. Das erlaubte uns, die besten Tools (Max/MSP, Cinder, Resolume) für jede Komponente zu wählen.

(Screenshot: Peter Holzkorn)

Michi, du hast den Body-Controller entwickelt. Möchtest du uns ein paar technische Einblicke gewähren, über den Entwicklungsprozess erzählen und wie du den Body-Controller weiterentwickeln möchtest?

Michael Platz: Im Frühjahr 2014 erzählte mir Chris von seiner Idee BareConductive’s Electric Paint (http://www.bareconductive.com/) in seiner nächsten Performance (Fuckhead/Raum.Null: “Who am I”) einzusetzen um Audio Samples und Loops durch Berühren gewisser Stellen auf seinem Körper, welche vorher mit der elektrisch leitfähigen Farbe bemalt wurden, auszulösen und zu steuern. Daraus entwickelte sich die Idee für den Body-Controller.

Für den ersten Prototypen entwickelte ich ein MIDI Input Device mit dem Atmel ATMEGA32U4 Microcontroller und dem LUFA open-source USB stack. Der Body-Controller kann direkt am Körper während der gesamten Performance getragen werden ohne den Künstler zu behindern.

Als mich Veronika fragte ob sie den Body-Controller für die Quadrature Performance zur direkten Steuerung ihrer Visual einsetzten kann, nahmen wir die noch bestehenden Probleme in Angriff, machten das bestehende System stabiler und erweiterten das MIDI Device auf insgesamt 8 MIDI Kanäle.

Der Body-Controller ist ein USB MIDI Gerät das den MIDI Standard unterstützt und wird von allen gängigen Betriebssystemen erkannt und unterstützt(Windows, Linux, AppleOS,…). Jedes Softwarepacket welches MIDI Devices als Eingang unterstützt um verschiedene Parameter zu beeinflussen oder Events auszulösen kann mit Hilfe des BodyControllers gesteuert werden. Das eröffnet eine Vielzahl von möglichen Anwendungsszenarien wo man Electric Paint am Körper eines Künstler aufbringen kann um Echtzeit-Interaktionen während Live-Performances auf der Bühne umzusetzen.

Wollt ihr noch etwas hinzufügen?

Ignacio Cuevas Puyol: Ich muss sagen, es ist immer toll mit dem Team des Ars Electronica Futurelabs zu arbeiten. Hier gibt es die besondere Mischung aus technischem Wissen und künstlerischem Wissen, was fantastisch ist. Ich denke, alle in dieser Performance involvierten Personen sind sehr glücklich mit dem Ergebnis. Nachdem ich mit den anderen gesprochen habe, weiß ich, dass sie damit genauso zufrieden sind, wie ich.

Was sind die nächsten Schritte? Gibt es Pläne für weitere Kooperationen?

Ignacio Cuevas Puyol: Ich möchte liebend gerne weiter mit dem Ars Electronica Futurelab zusammenarbeiten, meine Verbindung mit raum.null ist nun auch stärker und wir haben ein paar Ideen für die Zukunft.

Wir, das gesamte Team, haben ein bisschen über nächste Schritte gesprochen, aber das sind momentan noch Ideen, die wir im Moment noch nicht verraten wollen.

Ich muss nur noch „Vielen Dank, Ars Electronica“ hinzufügen!

Credits Quadrature

Sound: Ignacio Cuevas Puyol (White Sample), Chris Bruckmayr & Dobrivoje Milijanovic (raum.null)

Visuals: Veronika Pauser (VeroVisual) & Peter Holzkorn (voidsignal)

Body-Controller: Michael Platz

Special thanks to Michael Mayr (documentation), Florian Berger (code base) and Claudia Schnugg (moderation, organizational support)