Wie eng sind kommerzielle KI-Systeme mit militärischer Technologie verbunden? Dieses Projekt, das mit dem STARTS Prize 2025 Grand Prize – Artistic Exploration ausgezeichnet wurde, zeigt verborgene Zusammenhänge auf.

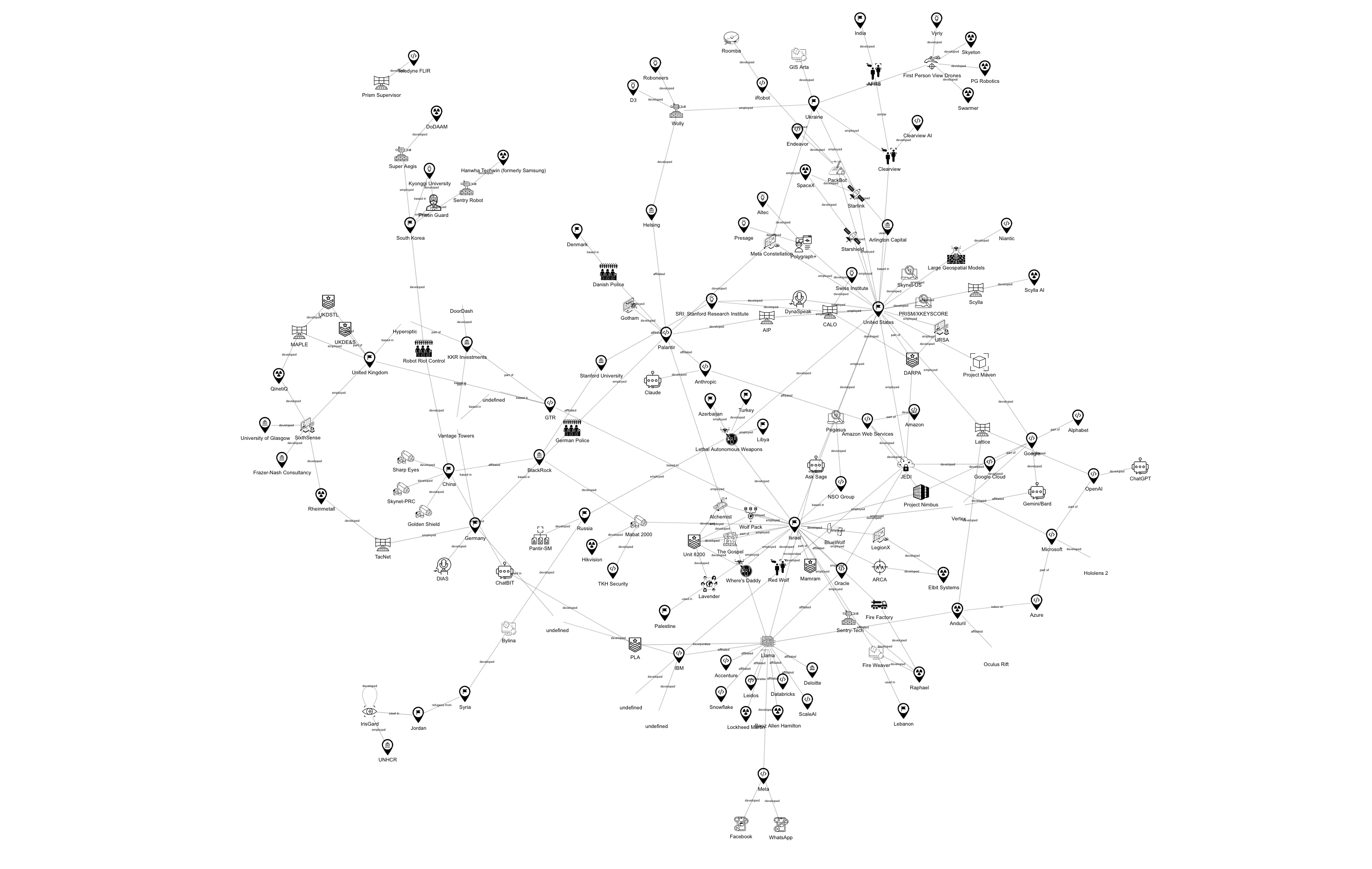

Welche Verbindung besteht zwischen den alltäglichen Technologien, die wir in unser Leben integrieren – Smartphones, Staubsaugerroboter, Sprachassistenten – und militärischen Entscheidungssystemen, die tödliche Gewalt ausüben können? Mit dieser brisanten Frage setzt sich die AI War Cloud Database von Sarah Ciston auseinander. Bei diesem interaktiven Forschungs- und Visualisierungsprojekt werden die gemeinsamen Infrastrukturen, Denkweisen und Akteur*innen hinter KI-Produkten für Verbraucher*innen und KI-gestützter Kriegsführung aufgezeigt.

Für diese Arbeit wurde Ciston mit dem STARTS Prize 2025 in der Kategorie „Grand Prize – Artistic Exploration“ ausgezeichnet. Mit diesem Preis werden künstlerische Projekte gewürdigt, die sich kritisch mit Wissenschaft und Technologie auseinandersetzen und zu sozialem oder ökologischem Wandel beitragen. Der STARTS Prize wird von der Europäischen Kommission verliehen und zeichnet innovative Arbeiten an der Schnittstelle von Wissenschaft, Technologie und Kunst aus.

In diesem Interview sprechen wir mit der*dem Initiator*in des Projekts über die tiefgreifende Verflechtung von Macht, Technologie und Verantwortung. Aufbauend auf der Arbeit von Advocacy-Gruppen wie Tech Inquiry und No Tech for Apartheid deckt die AI War Cloud Database auf, wie Tools, die an schutzbedürftigen Bevölkerungsgruppen – von Flüchtlingen bis hin zu Zivilist*innen in Konfliktgebieten – getestet werden, später neu verpackt und auf kommerziellen Märkten eingesetzt werden. Sie lädt die Betrachter*innen dazu ein, den Zusammenhängen nachzugehen: Der an einer Grenzkontrollstelle verwendete Iris-Scanner wird zur biometrischen Anmeldung für eine Banking-App, die Navigationssoftware eines Reinigungsroboters wird für die Bombenentschärfung umgerüstet, und generative KI, die auf prekäre globale Arbeitsverhältnisse trainiert wurde, unterstützt sowohl einfache Suchanfragen als auch Entscheidungen auf dem Schlachtfeld.

Was dabei entsteht, ist ein beunruhigendes Bild von dem, was Sarah Ciston als „techno-imperialen Bumerang“ bezeichnet – ein Kreislauf, in dem Experimente am Rande der Gesellschaft auf uns alle zurückfallen. Im folgenden Gespräch untersuchen wir nicht nur, wie diese Zusammenhänge funktionieren, sondern auch, was nötig sein könnte, um ihnen zu widerstehen oder sie neu zu denken: von individuellen Entscheidungen über den Umgang mit Technologie bis hin zu kollektiven Anstrengungen in Politik, Softwareentwicklung und Kunst.

Ihr Projekt betont die Themen Vernetzung und Macht. Können Sie näher erläutern, wie diese beiden Aspekte mit KI und Krieg zusammenhängen?

Sarah Ciston: Macht auszuüben und zu festigen ist oft mit der Fähigkeit verbunden, Verbindungen zu nutzen, und zwar häufig in einem Ausmaß, das weit über unser tägliches Leben hinausgeht – von der Makroebene von Nationen, Unternehmen, Grenzen und Handelswegen bis hin zur Mikroebene der Datenverarbeitung. KI-Systeme nutzen die Geschwindigkeit und den Umfang von Berechnungen, um in großen Datenmengen schneller Muster zu finden, als wir dies jemals könnten. Das bedeutet jedoch, dass wir, um uns auf KI-Systeme verlassen zu können, ihre Logik der Klassifizierung und Komprimierung von Informationen akzeptieren müssen.

„Da sie in einer Größenordnung operieren, die wir nicht sehen oder kontrollieren können, müssen wir ihnen vertrauen. Projekte wie die AI War Cloud Database versuchen, KI-Systeme ein wenig sichtbarer und verständlicher zu machen, um zu verstehen, wie sie im Interesse der Mächtigen eingesetzt werden.“

Welche Rolle spielen alltägliche KI-Systeme – wie die in unseren Smartphones und Smart Homes – im größeren Kontext der Militarisierung und Kontrolle von KI?

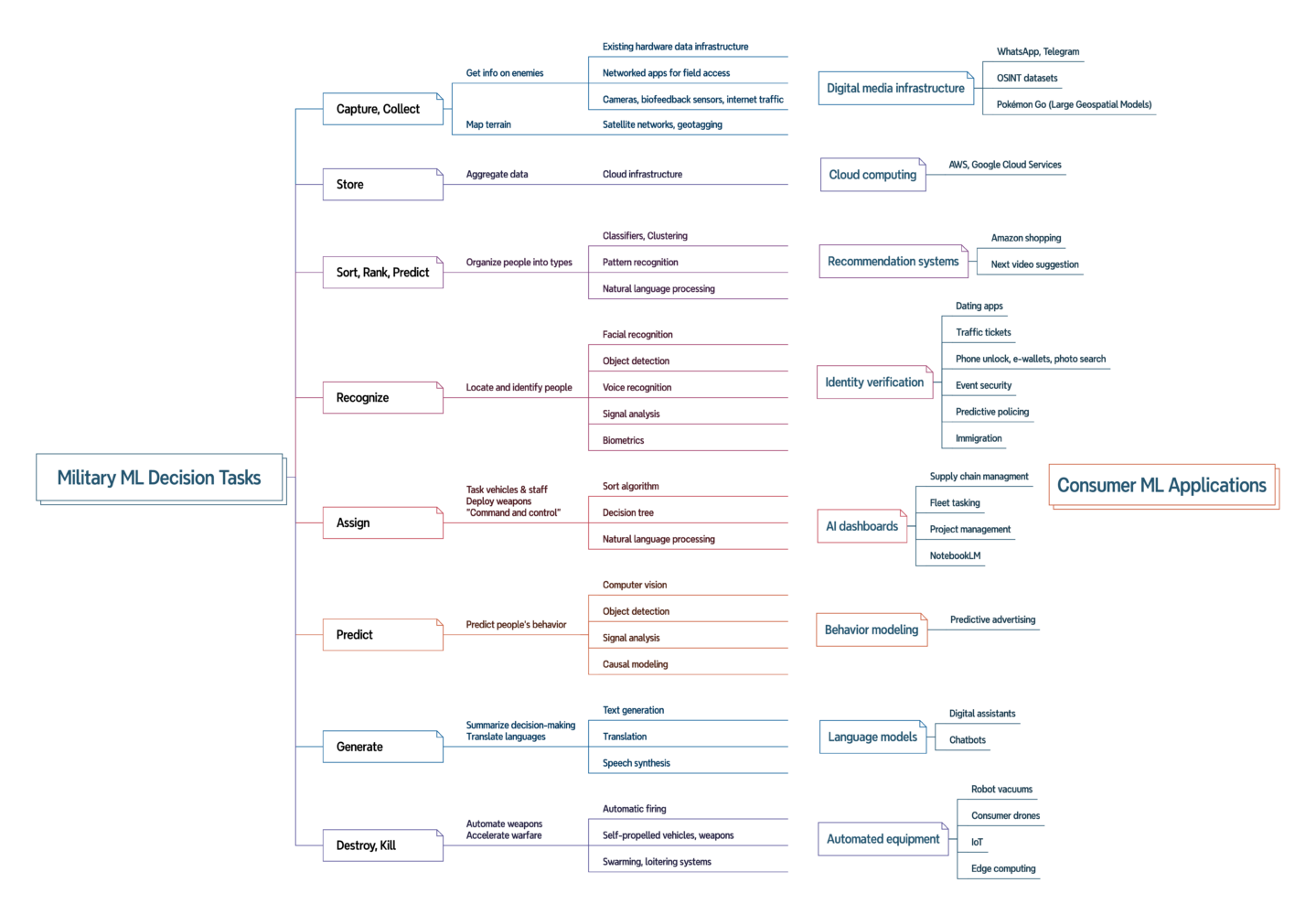

Sarah Ciston: Nicht nur sind einige der gleichen Unternehmen beteiligt, wovon wir immer mehr erfahren, sondern es werden auch in beiden Bereichen die gleichen Arten von KI-Aufgaben eingesetzt. Die Empfehlungssysteme, die wir zur Auswahl von Streaming-Filmen verwenden, nutzen die gleiche Art von KI, die in Übersee zur Auswahl von Zielpersonen für Tötungseinsätze eingesetzt wird.

„Die generative KI, die wir zum Schreiben, für Recherchen, zur Bildbearbeitung und für immer mehr Aufgaben (oft mit unzuverlässigen Ergebnissen!) nutzen, wird in „Befehls- und Kontrollsysteme“ integriert, die in Echtzeit Entscheidungen mit hohen Risiken auf dem Schlachtfeld treffen. Fast jede kommerzielle KI-Aufgabe hat eine militärische Entsprechung, die derzeit erforscht oder bereits eingesetzt wird.“

Diese Systeme werden trotz der unterschiedlichen Kontexte in beide Richtungen angepasst. Manchmal wechseln dieselben Unternehmen von einer Branche in die andere. So entwickeln beispielsweise die Hersteller der Roomba-Haushaltsroboter, die die Wohnungen ihrer Nutzer kartografieren, nun Bombenräumer, und die Macher von Pokémon Go haben darüber spekuliert, wie die Daten aus ihrem Spiel zur Erstellung von KI-Karten für das Militär genutzt werden könnten. Neben den großen Unternehmen, bei denen man es erwarten würde (Microsoft, Amazon, Google, Palantir), drängen eine Vielzahl kleiner Tech-Startups mit Unterstützung von Risikokapital in die Verteidigungsindustrie und experimentieren mit leistungsstarken Technologien in unregulierten Kontexten, über Grenzen hinweg und an gefährdeten Bevölkerungsgruppen.

Ist es Ihrer Meinung nach ethisch oder strategisch vertretbar, KI im Krieg einzusetzen? Was müsste dabei beachtet werden?

Sarah Ciston: Nein.

„KI“ ist ein vager Begriff, der dazu dient, ihre Funktionsweise zu verschleiern und von der Verantwortung für ihre Auswirkungen abzulenken. Es wird keine verbesserte Version eines KI-Systems geben, die „vertrauenswürdig genug“ wäre, um sie für Entscheidungen über Leben und Tod in Anspruch zu nehmen. Selbst wenn wir nur bestimmte maschinelle Lernaufgaben für Aktivitäten mit geringem Risiko berücksichtigen würden, gäbe es ökologische und andere soziale Schäden zu bedenken.

Wenn – und das ist ein „wenn“ mit vielen Vorbehalten (ich bin Realist und gehe davon aus, dass die Menschen KI weiterhin nutzen werden) – KI-Systeme in risikoreichen Kontexten wie der Kriegsführung eingesetzt werden, ist ein Paradigmenwechsel erforderlich. Wir könnten beispielsweise einen Wechsel von „Human-in-the-Loop“ zu „AI-in-the-Loop“ in Betracht ziehen, wobei KI-Systeme als Verifizierung und Backup zur Unterstützung menschlicher Bemühungen eingesetzt werden, anstatt diese zu ersetzen. KI sollte keine weitreichenden Entscheidungen treffen oder Auswahlmöglichkeiten für solche Entscheidungen kuratieren.

Sehen Sie auch konstruktive oder humanitäre Anwendungsmöglichkeiten für KI in Konfliktgebieten oder militärischen Kontexten?

Sarah Ciston: Man könnte hoffen, dass KI Kriege sicherer und präziser macht und so dazu beiträgt, Opfer zu vermeiden – aber bisher hat KI gezeigt, dass sie den Schaden um ein Vielfaches vergrößert. Behauptungen, dass KI Schaden verhindert oder verringert, wurden widerlegt.

„So wie sie derzeit eingesetzt wird, sehe ich nur sehr wenige konstruktive oder humanitäre Anwendungsmöglichkeiten für KI in Konfliktgebieten.“

Wenn jedoch Systeme aus einer anderen Perspektive überdacht und mit und für die am stärksten betroffenen Gemeinschaften entwickelt würden – in jedem Kontext, nicht nur in Konfliktgebieten – könnte ich mir konstruktive Anwendungen in kleinem Maßstab vorstellen. Wenn man sich in einem aktiven Kriegsgebiet befindet, hat natürlich nicht die ethische Gestaltung der KI Priorität, sondern das Überleben. In jedem Kontext ist es nicht einfach oder geht es schnell zu verstehen, was tatsächlich benötigt wird, und wahrscheinlich passt es nicht in bestehende Vorlagen oder Profitmodelle. Es ist besser, mit der Frage zu starten: „Was wird benötigt?“, statt „Was kann KI leisten?“.

Verantwortlichkeit ist ein zentrales Thema Ihrer Arbeit. Welche Wege gibt es, um KI-Systeme – oder diejenigen, die sie einsetzen – zur Verantwortung zu ziehen?

Sarah Ciston: Als Einzelpersonen können wir meiner Meinung nach zunächst einmal ganz einfach damit anfangen, den Hype um KI bei den Produkten, die wir selbst nutzen, nicht zu glauben. Ich versuche, Tools zu entwickeln, die jedem helfen, ein grundlegendes technisches Verständnis von KI zu erlangen. Man sollte zumindest wissen, dass KI enorme Datenmengen und viel Arbeit erfordert und dass sie weder „intelligent“ noch unfehlbar ist. Ich versuche, KI zu vermeiden, wann immer es möglich ist und wenn mir ihre Verwendung nicht gefällt. Und ich bemühe mich, stattdessen Tools von Unternehmen zu wählen, deren Werte ich unterstütze.

Darüber hinaus können wir als Künstler*innen, Programmierer*innen und Entwickler*innen unsere eigenen Tools erstellen oder mit anderen zusammenarbeiten, um dies zu tun. Ich denke, dass Kunst und Programmieren ein großes Potenzial und eine große Verantwortung haben, um verschiedene Zukunftsvisionen zu entwerfen und konkret mit praktischen Lösungen zu experimentieren. Wir können auch politische Entscheidungsträger*innen dazu auffordern, mehr Initiativen zu unterstützen, die Communities für eine Neugestaltung der KI insgesamt aufbauen.

Glauben Sie, dass KI die Natur von Konflikten grundlegend verändert? Wenn ja, inwiefern?

Sarah Ciston: Ja. Wie in vielen Bereichen des Lebens breiten sich KI-Systeme auch im Bereich von Krieg und Konflikten aus, beschleunigen diese und machen sie komplexer. Wichtig ist, dass KI die Verflechtung von militärischer Macht und innerstaatlicher Polizeiarbeit fördert, da die allgegenwärtige Erfassung von Daten aus unseren Telefonen und Geräten in die innerstaatliche und internationale Überwachung einfließt. Viele der Beispiele in AI War Cloud stammen von Unternehmen, die ihre Produkte sowohl als private Sicherheitswerkzeuge als auch als Militärprodukte vermarkten und manchmal auch andere kommerzielle Anwendungen anbieten. Als jemand, der das Glück hat, derzeit nicht in einem aktiven Kriegsgebiet zu leben, mache ich mir nicht nur Sorgen um die Welt, sondern habe auch persönlich Angst davor, wie anpassungsfähig und alltäglich diese Werkzeuge schon jetzt sind.

Sarah Ciston’s AI War Cloud Database will be presented at the Ars Electronica Festival in Linz, September 3–7, 2025. As a Grand Prize winner of the STARTS Prize 2025, the work will be featured in the dedicated STARTS exhibition at POSTCITY—highlighting visionary projects at the intersection of science, technology, and the arts. For the latest updates on this and other program highlights, visit our festival website.

Sarah Ciston

Sarah Ciston entwickelt kritische und kreative Tools, um intersektionale Ansätze in das maschinelle Lernen zu integrieren. Sie ist Autor*in von „A Critical Field Guide for Working with Machine Learning Datasets“ und Mitautor*in von „Inventing ELIZA: How the First Chatbot Shaped the Future of AI“ (MIT Press 2026). Derzeit ist sie Forschungsstipendiat*in am Center for Advanced Internet Studies, hat einen Doktortitel in Medienkunst und -praxis von der University of Southern California und ist Gründer*in von Code Collective, einer zugänglichen, interdisziplinären Community für gemeinsames Lernen im Bereich Programmierung.