MusicLM ist ein weit entwickeltes Modell für maschinelles Lernen, das basierend auf Textbeschreibungen hochwertige Musik und Klänge generieren kann.

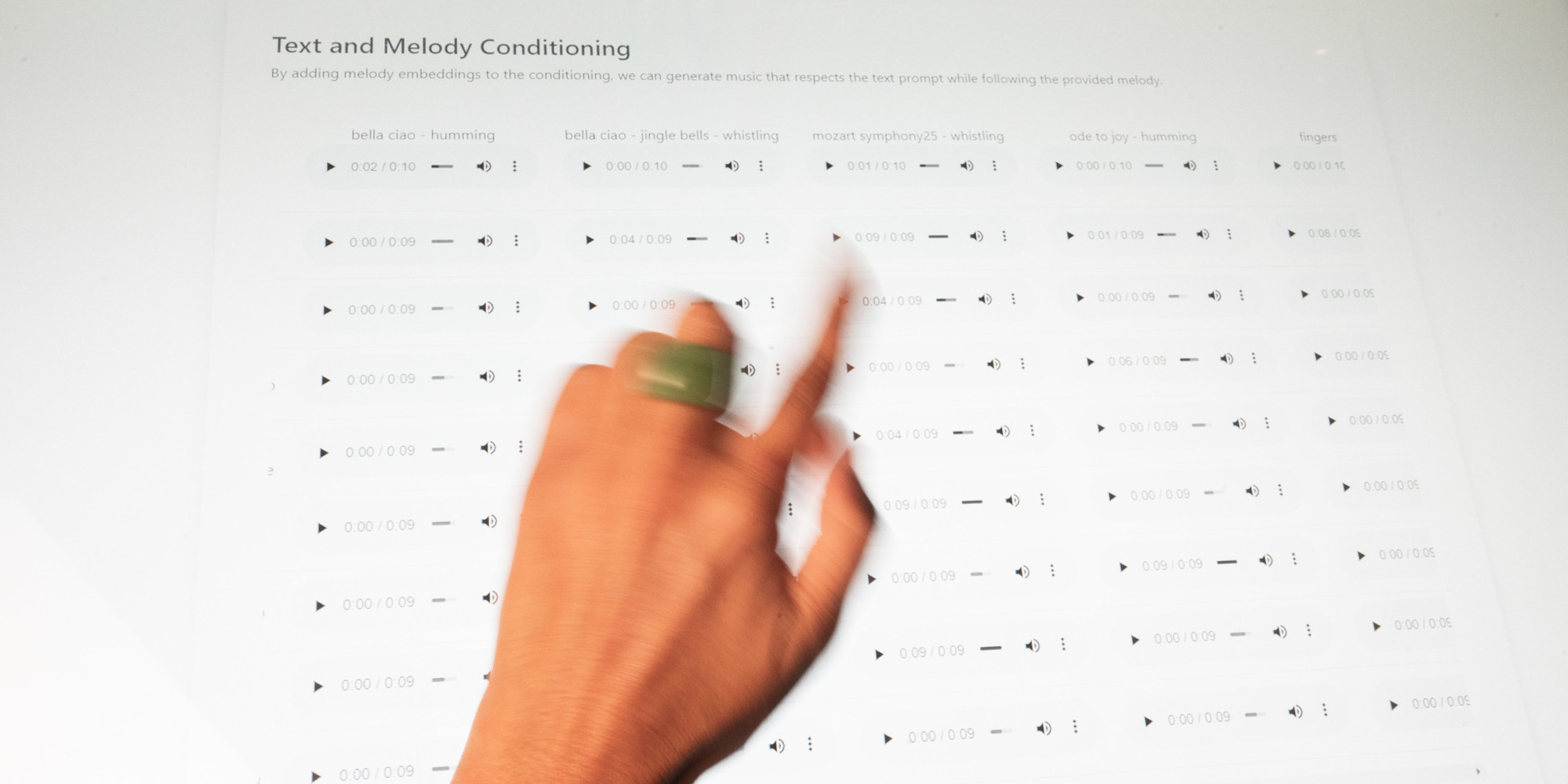

Es übertrifft frühere Systeme in Bezug auf die Audioqualität und die genaue Umsetzung der gegebenen Textbeschreibungen. Das Modell kann auch eine Melodie einbeziehen und sie entsprechend dem im Text beschriebenen gewünschten Stil transformieren. Zur Förderung weiterer Forschung haben die Autoren den Datensatz MusicCaps veröffentlicht, der aus Musik-Text-Paaren mit detaillierten Beschreibungen besteht. Das Projekt befasst sich mit den Herausforderungen der Klangsynthese und dem Mangel an gepaarten Audio-Text-Daten. MusicLM nutzt einen mehrstufigen Modellierungsansatz und wurde auch auf einem umfangreichen Datensatz von nicht gekennzeichneter Musik trainiert, um lange und kohärente Musikstücke zu generieren. Die Leistung des Modells wird mithilfe quantitativer und qualitativer Metriken bewertet, die seine Überlegenheit gegenüber bestehenden Systemen zeigen.