Wer in diesen Tagen am Chemnitzer Hauptbahnhof aus dem Zug steigt, dem winken bereits auf der leuchtenden LED-Fassade des Gebäudes Schattenfiguren und Gesten entgegen. Sie verweisen auf das etwa drei Kilometer entfernte Industriemuseum Chemnitz, in dem diese digitalen Schatten von den BesucherInnen selbst geformt werden können. Noch bis 4. März 2018 bietet die Schau „Gesten – gestern, heute, übermorgen“ die Möglichkeit, sich mit dem Thema Gesten näher zu beschäftigen und dabei mehr über die Gestenforschung und den Einsatz bei zukünftigen Anwendungsgebieten zu erfahren. Von der Bedienung alter Webstühle bis hin zu „Industrie 4.0“ und der Kommunikation mit selbstfahrenden Autos – Gesten werden auch zukünftig eine große Rolle spielen. Sie sind komplex, sie verändern ihre Bedeutung oder werden aber auch über Generationen hinweg unverändert überliefert. Marianne Eisl ist Projektleiterin beim Ars Electronica Futurelab. Sie ist gemeinsam mit Christopher Lindinger, Director Research & Innovation, für die inhaltliche Konzeption dieser Ausstellung verantwortlich. Im Interview erzählt sie uns mehr über die „Sprache der Hände“ und stellt einige der 16 Exponate näher vor.

Warum hat das Ars Electronica Futurelab begonnen sich mit Gesten zu beschäftigen?

Marianne Eisl: Hier im Ars Electronica Futurelab in Linz beschäftigen wir uns laufend mit Zukunftsthemen. So richten wir schon seit 2013 gemeinsam mit verschiedenen Großkonzernen einen Fokus auf Gestensteuerungen für autonome Fahrzeuge. Wer das Thema so wie wir von einer wissenschaftlichen Perspektive aufrollt, erkennt sehr schnell, dass Gesten nicht nur einfache Handbewegungen sind, sondern weit differenzierter betrachtet werden müssen. Nicht umsonst gibt es eigene Wissenschaftsdisziplinen, die sich ausschließlich mit Gestenforschung auseinandersetzen und dabei versuchen, Gesten zu entschlüsseln, zu kategorisieren, die dazugehörigen Kontextfaktoren miteinzubeziehen und all das aus einer sprachwissenschaftlichen Perspektive näher zu betrachten.

So sind wir bei einem unserer Projekte mit der Gestenforscherin Prof. Dr. Ellen Fricke zusammengekommen. Sie leitet das deutsche Forschungsprojekt „MANUACT“ an der Technischen Universität Chemnitz, das sich dem Zusammenhang von Händen, Dingen und Gesten am Arbeitsplatz und im Alltag widmet. Und wenn wir uns die zukünftige Entwicklung ansehen, wie sehr wir Menschen immer mehr mit Robotern zusammenarbeiten werden, dann ist sicher die Geste auch in naher Zukunft ein ganz wesentliches Element der Kommunikation zwischen Mensch und Maschine.

Und so ist das Ars Electronica Futurelab dann auch Forschungspartner der TU Chemnitz geworden?

Marianne Eisl: Genau. Prof. Dr. Fricke war es wichtig, unsere Zusammenarbeit in der Gestenforschung mit der TU Chemnitz zu verstärken. Ein wesentlicher Punkt dieses Forschungsprojekts war es auch, das Thema nicht nur auf einem wissenschaftlichen Niveau zu diskutieren, sondern auch eine öffentliche Ausstellung zu konzipieren, an der Dramaturgie mitzuwirken und interaktive Installationen beizusteuern. Gerade hier ist es natürlich wichtig, nicht nur die wissenschaftlich-technische Perspektive einzubringen, sondern auch die künstlerische. Deshalb haben wir auch KünstlerInnen eingeladen, ihre Beiträge zum Thema Gestenforschung und –steuerung beizusteuern.

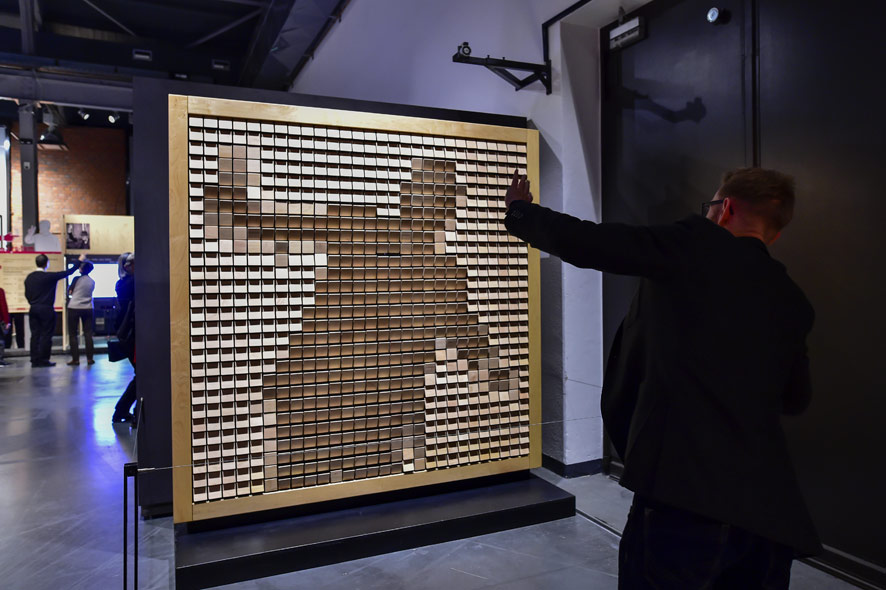

Wooden Mirror von Daniel Rozin. Credit: Industriemuseum Chemnitz / Sven Gleisberg

Welche KünstlerInnen sind bei der Ausstellung „Gesten“ im Industriemuseum Chemnitz beteiligt?

Marianne Eisl: Gleich im Eingangsbereich der Ausstellung ist die beeindruckende Arbeit von Daniel Rozin zu sehen. Sein „Wooden Mirror“, der die Bewegungen der BesucherInnen auf über 800 beweglichen Holzplättchen als „Pixelgrafik“ überträgt, hat bei der Eröffnung gleich zu Beginn viele Leute fasziniert. Golan Levin ist mit seiner Arbeit „Augmented Hand Series“ vertreten: Auf einem Bildschirm verformen sich die Hände der BesucherInnen in sonderbare Konstrukte, die zum Nachdenken anregen. Jennifer Crupi gibt mit ihren aus Metall erzeugten Formen bestimmte Gesten vor – wer diese trägt, findet sich in gewissen Posen, die wir im alltäglichen Leben ganz selbstverständlich einnehmen, wieder. Anette Rose lässt die BesucherInnen bei „Captured Motion“ in einen Kubus treten, in dem zuvor aufgezeichnete Motion-Capture-Daten von Menschen gezeigt werden, die mit ihren Händen etwas erklären – man sieht sehr anschaulich die Bewegungsspuren ihrer Hände und wie Wörter und Gesten zusammenspielen.

Das Ars Electronica Futurelab hat aber auch eigene Installationen für die Ausstellung entwickelt…

Marianne Eisl: Die Grundidee dieser Ausstellung war, das Thema Gestenforschung auf einem spielerischen Weg der Öffentlichkeit näher zu bringen. Die Parametrisierung der Gestenforschung, die unterschiedlichen Gestenklassen, der Gestenraum – all das ist unheimlich spannend, aber vielleicht nicht gerade leicht weiterzuvermitteln. Mit einem spielerischen Zugang, interessanten Technologien, die uns auch im Ars Electronica Futurelab interessieren, und über das Ausprobieren unterschiedlicher Aufzeichnungstechniken sind wir an die Aufgabe, eine Ausstellung zu konzipieren, herangegangen.

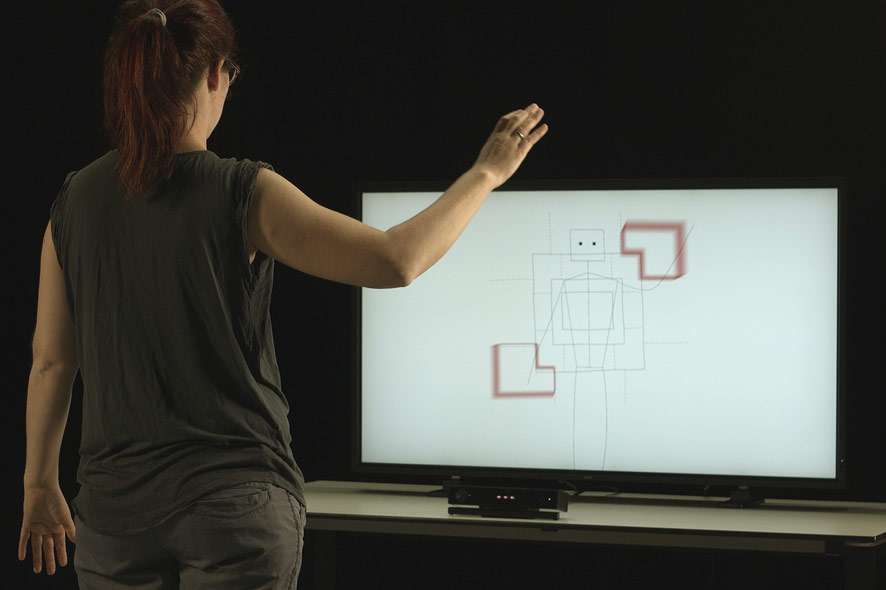

Gesture Space Visualizer, Credit: Ars Electronica Futurelab / Michael Mayr

Der Ausgangspunkt jedes von uns entwickelten interaktiven Exponats war immer eine Geste, die viele Menschen bereits kennen, um dann mit einem überraschenden Moment zu einem Perspektivenwechsel zu bewegen. So kommt zum Beispiel die Victory-Geste zum Einsatz, bei der Zeigefinger und Mittelfinger zu dem Buchstaben „V“ geformt werden. Diese Geste half uns, den Begriff des „Gestenraums“ näher zu erklären, der in der Gestenforschung sehr wichtig ist. Man kann sich das so vorstellen, dass der menschliche Körper in verschiedene Sektoren aufgeteilt ist. Wenn man die Hand mit der Victory-Geste neben dem eigenen Körper positioniert, dann wird dieser Geste eine andere Bedeutung zugeschrieben als wenn man die Hand mit dem „V“ hinter dem eigenen Kopf positioniert – und somit in einem anderen Sektor des Gestenraum. Die Geste erhält plötzlich eine ganz andere Bedeutung. Viele Menschen deuten sie dann nicht mehr als Siegesgeste sondern sehen eher Hasenohren. Und das kann man bei einer interaktiven Installation selbst ausprobieren – hier wird gezeigt, in welchem Bereich des Gestenraums jede Geste, die man selber macht, verortet ist.

Virtuelle Töpferscheibe, entwicklelt vom Ars Electronica Futurelab. Credit: Industriemuseum Chemnitz / Sven Gleisberg

Werden wir in Zukunft andere Gesten verwenden als wir das heute tun?

Marianne Eisl: Bei jeder Geste schwingt immer die Frage ihres Bedeutungsspektrums mit. Gesten haben sich über die Jahrhunderte immer wieder geändert, auch deshalb, weil sich Technologien geändert haben – und das tun sie auch weiterhin. In der Ausstellung haben wir unterschiedliche historische Exponate inkludiert, die genau diesen Wandel zeigen. So hat sich die Geste für das Telefonieren durch den Wegfall des Telefonhörers und den zunehmenden Gebrauch von Mobiltelefonen verändert. Zahlreiche alte Handhabungsgesten wie das Töpfern sind immer noch in unseren Köpfen intuitiv verankert und können damit auch bei zukünftigen Interfaces weiterverwendet werden. So gibt es mit der „virtuellen Töpferscheibe“ eine Installation, bei der BesucherInnen durch den Gebrauch ihrer Hände virtuelle Vasen und andere Objekte töpfern können. Schon bei der Eröffnung der Ausstellung im Industriemuseum Chemnitz hat das viele Leute begeistert – sie haben diese Geste scheinbar nicht vergessen.

Ein Kugellabyrinth mit Gesten steuern. Credit: Industriemuseum Chemnitz / Sven Gleisberg

Wie vertraut ist den BesucherInnen die Steuerung über Gesten?

Marianne Eisl: Die Steuerung von Objekten über Gesten ist für die meisten Menschen einfach und intuitiv – das war auch eines der Forschungsthemen der TU Chemnitz, das wir mit einer eigenen Installation in die Ausstellung übertragen haben. Hier können die BesucherInnen virtuell über einen Globus fliegen – wie das mit der passenden Flugzeuggeste funktionieren kann, das haben die BesucherInnen schnell entdeckt. Bestehende Handhabungsgesten sind aber auch schnell durch andere intuitive Gesten ersetzt, wie uns das Kugellabyrinth zeigt. Das Geschicklichkeitsspiel lässt sich ja über zwei Achsen bewegen. Wir haben es nun mit einer Gestensteuerung versehen – wer es steuern möchte, braucht nur die Handfläche zu kippen und das Spiel dreht sich. Die BesucherInnen hatten schnell den „Dreh“ heraus und jede Menge Spaß dabei.

Marianne Eisl ist seit 2015 Senior Researcher am Ars Electronica Futurelab in Linz. Während ihrer Zeit als Entwicklerin für AnwenderInnensoftware im Anwalt- und Notarbereich in Wien studierte sie an der Technischen Universität Wien Medieninformatik und sammelte dabei auch Erfahrungen als Tutorin für die Lehrveranstaltungen „Algorithmen und Datenstrukturen, „Video Analysis“ und „Video Analysis of Human Motion“. Im Rahmen ihrer Diplomarbeit beschäftigte sie sich mit Microcontroller-Programmierung, Sensorik und intuitivem Interface-Design und arbeitete in diesem Bereich auch nach Abschluss des Studiums an einem weiterführenden Projekt der TU Wien mit.