Du warst von Anfang an an der Entwicklung der Ausstellung „Understanding AI“ beteiligt. Was waren die Zielsetzungen?

Ali Nikrang: Das Thema Künstliche Intelligenz war von Anfang an gesetzt – das ist ein großer Bereich, den man weiter unterteilen kann, aber zunächst wollten wir zeigen, wie künstliche neuronale Netzwerke funktionieren und was sie tun können, da sie die grundlegende Technologie im Bereich Deep Learning sind. Den BesucherInnen sollte so eine Orientierungshilfe gegeben werden, sodass jede und jeder etwas damit anfangen kann.

Das Team um die Ausstellung hat sich seit Mai 2018 fast wöchentlich getroffen, um die Möglichkeiten detailliert zu besprechen, umzusetzen und manches auch wieder zu verwerfen. Denn was 2018 grade brandneu ist, kann 2019 schon wieder Schnee von gestern sein.

Zunächst haben wir unser Vorhaben in zwei große Bereiche unterteilt: Da ist einmal der didaktische Aufgabenkreis, in dem die Grundfunktionen erklärt werden. Wie funktioniert ein Neuron? Was ist ein Netzwerk? Was ist ein Convolutional Neural Network? Der zweite große Bereich waren die Anwendungen. Wie kann Künstliche Intelligenz vermittelt werden? Wie kann etwas so Komplexes optimal gezeigt werden? Ich denke, wir haben einen guten Weg gefunden, die faszinierende Technologie darzustellen.

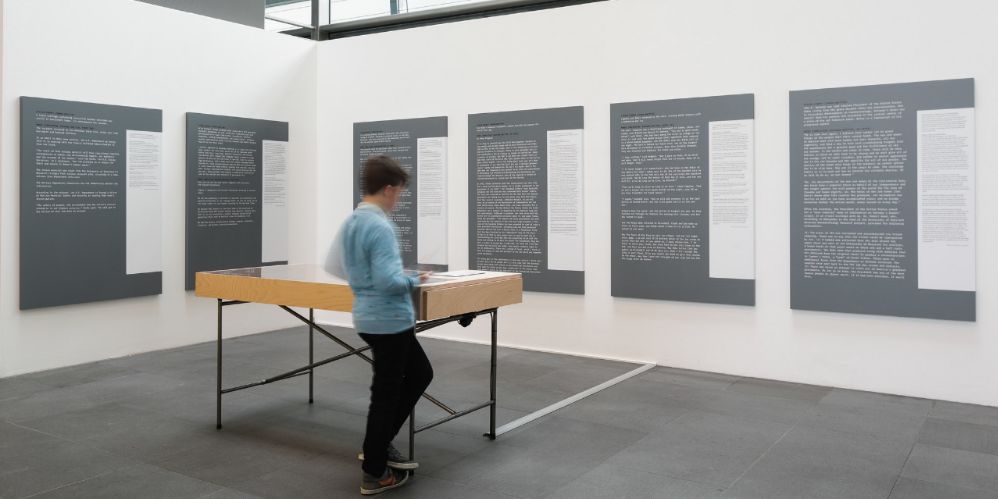

Credit: Ars Electronica / Robert Bauernhansl

Was war die größte Herausforderung?

Ali Nikrang: Die Aktualität ist eine große Herausforderung. Gerade im Bereich Deep Learning passiert sehr viel, die Ausstellung kann aber nicht tagesaktuell bleiben. Trotzdem muss sie den Menschen etwas Neues erzählen, Einsicht in die komplexe Thematik bieten, eine mögliche Angst vor dem Ungewissen lindern und in die Position versetzen, mitzureden.

Im didaktischen Bereich ist die Aktualität kein allzu großes Problem, weil die Grundfunktionen ja dieselben bleiben. Aber bei den Anwendungen kann schnell mal etwas veraltet wirken, weil sich so viel tut. Manche langgeplanten Installationen wurden erst vor Wochen wieder verworfen, die letzte Anwendung kam grade mal drei Tage vor Eröffnung neu hinzu.

Credit: vog.photo

Die Ausstellung Understanding AI soll BesucherInnen vor Augen führen, wo Ähnlichkeiten und wo Unterschiede in der Betrachtungsweise von Mensch und Maschine liegen. Wie „lernen“ denn Maschinen?

Ali Nikrang: Lernen funktioniert bei einem neuronalen Netzwerk über die Statistik von Daten. Im Bereich der Objekterkennung etwa wird ein Convolutional Neural Network mit sehr vielen Bildern gefüttert und muss etwa bestimmte Objekte in diesen Bildern erkennen. Auch wenn das Netzwerk zu Beginn fast immer falsch liegt, kann es mittels einer Technik namens Backpropagation aus den Beispielen lernen. Durch Bestätigung oder Fehler lernt die Maschine also, ihre Parameter so zu verändern, dass die Trefferquote steigt. So ein Modell kann zum Beispiel 138 Millionen trainierbare Parameter haben, die es justieren kann – wir sprechen in der Informatik von Gewichten (wenn man will, kann man hier eine Analogie zu den Synapsen im Gehirn sehen).

Der Lernprozess ist also ein quantitatives Training, bis die Gewichte so angepasst sind, dass die richtige Antwort kommt. D.h. die Maschine lernt selbstständig, welche visuellen Merkmale für die Erkennung der Objekte notwendig sind. Ist eine Trainingsphase abgeschlossen, ist das Lernen zu Ende. Beim menschlichen Gehirn ist das nicht so.

Neuronale Plastizität (im Sinne von kontinuierlichem Lernen) steht in großem Gegensatz zu Maschinen. Es gibt aber auch Ähnlichkeiten. Die Convolutional Neural Networks sind inspiriert vom visuellen Cortex im Gehirn und die Art und Weise, wie wir die sichtbare Umgebung wahrnehmen.

Im textlichen Bereich werden Wörter in einem multidimensionalen Raum als Vektoren repräsentiert, womit auch die Semantik der Wörter gelernt wird. Wörter die ähnlich sind, bekommen ähnliche Vektoren bzw. Positionen in diesem Raum. Dieser multidimensionale Raum kann z.B. 300 Dimensionen haben, die man sich aber nicht visuell vorstellen darf, sondern wie eine Reihe von Nummern. Bestimmte Nummern zusammen beschreiben ein Wort. Der Rechner lernt, dass es etwa zwischen den Wörtern Pullover und T-Shirt mehr Ähnlichkeit gibt als zwischen Pullover und Eiffelturm, da sie öfter im selben Kontext vorkommen. Aus diesen Wortvektoren entstehen dann ganze Sätze.

Rechner lernen also die Statistik von Daten. Auch Menschen lernen gewisserweise statistisch.

Credit: vog.photo

Heißt das, Menschen und Maschinen lernen gleich? Statistisch?

Ali Nikrang: Informationsverarbeitung ist aus einer evolutionären Sicht eine Frage des Überlebens. Ein Spezies, die schneller und effizienter mit der Information aus der Umwelt umgehen kann, hat einen Vorteil gegenüber anderen. Sie kann die Gefahr schneller erkennen und bei der Futtersuche effizienter vorgehen.

Die Natur hat hier einen Weg gefunden, mit wenig Ressourcen viel Information zu holen. Und die Statistik hilft, weil nicht jeder kleinsten Einzelinformation große Bedeutung gegeben werden muss. Man lernt, welche Kombinationen in der realen Welt öfter als eine Einheit vorkommen und zusammen einen Sinn ergeben. Unsere Wahrnehmung ist sozusagen auf Basis von Konzepten trainiert, die für unser Leben relevant sind.

Credit: Ars Electronica / Robert Bauernhansl

Wo liegt dein persönliches Interesse an Künstlicher Intelligenz? Erzähl uns etwas über deinen Background!

Ali Nikrang: Ich habe klassische Musik am Mozarteum in Salzburg und Computer Science an der Johannes Kepler Universität in Linz studiert. Beide Bereiche faszinieren mich gleichermaßen – es ist unglaublich, welche Fortschritte es im Bereich der klassischen Musik in den letzten Jahrhunderten und in der Computer Science in den letzten Jahrzehnten gegeben hat – natürlich bauen diese auf den Fortschritten der Mathematik der letzten Jahrhunderte auf. Bei der Verbindung dieser beiden Gebiete ist noch viel zu tun. Musikalische Daten sind komplett anders als Image- oder Textdaten, die Herausforderungen sind ganz andere. Es gibt keine Beschreibung dafür, was Musik ist und wie genau sie von Menschen wahrgenommen wird, deshalb ist es auch ungleich schwieriger, das einer KI zu „erklären“.

Mag das auch schwierig klingen, es ist ungemein spannend. In einem nächsten Schritt eröffnen wir eine weitere Teilausstellung, die sich genau mit diesem Spannungsfeld auseinandersetzt: AI x Music.

Credit: vog.photo

Wie wichtig ist es, im Themenkomplex Künstliche Intelligenz unterschiedliche Fachrichtungen zu berücksichtigen?

Ali Nikrang: Die Errungenschaften im Bereich KI kommen hauptsächlich aus der Informatik und Mathematik, aber auch kognitive Psychologie und Neurologie haben ihren Anteil, weil es sehr viel um Wahrnehmung geht – wodurch wir auch einen Schnittpunkt zur Kunst haben. Man versucht ja nachzuahmen, wie Menschen die Welt wahrnehmen und dafür ist es unabdinglich, dass man auch etwas über die Funktionsweise des Gehirns weiß. So lernt man über die Maschine und über sich selbst. In der (menschlichen) Gehirnforschung versucht man, von der Forschung an neuronalen Netzwerken zu profitieren und so das Gehirn besser zu verstehen.

Es kommen also viele Teilbereiche zusammen, um die Welt zu erklären. Damit wird die Statistik der Daten wohl zur Natur der Daten.

Ali Nikrang ist Senior Researcher & Artist im Ars Electronica Futurelab wo er Mitglied der Forschungsgruppe Virtual Environments ist. Er studierte Computer Science an der Johannes Kepler Universität Linz und Komposition mit Schwerpunkt neue Medien an der Universität Mozarteum Salzburg. Zudem erhielt er ein Diplom in Konzertfach Klavier gleichermaßen von der Universität Mozarteum.

Bevor er 2011 an das Ars Electronica wechselte, arbeitete er als Researcher beim Austrian Research Institut for Artificial Intelligence in Wien, wo er Erfahrungen im Bereich Serious Games und simulierte Welten sammelte. Zu seinen weiteren Erfahrungen gehören Projekte auf dem Gebiet Musik und neue Medien, einschließlich der Entwicklung von computergestützten Methoden der Musikvisualisierung, Analyse und Komposition sowie Methoden der Klanganalyse und Klangverarbeitung.

Zu seinen weiteren Forschungsinteressen gehört die Entwicklung von computergestützten Modellen zur Simulation der menschlichen Empfindungen, die bei der akustischen und visuellen Wahrnehmung eines Kunstwerkes entstehen. Gemeinsam mit dem Institut für Computional Perception an der Johannes Kepler Universität veröffentlichte er eine neue Methode, die die menschliche Wahrnehmung bezüglich harmonischer Spannungen in der Musik simulieren kann. Zudem entwickelte er ein Computermodel für automatische Komposition von mehrstimmiger Musik. Einige Kreationen von diesem Modell wurden bereits in kommerziellen Projekten als Soundtrack eingesetzt (z.B. in Global Brand Conference von Silhouette (2017), aufgeführt im Deep Space 8K des Ars Electronica Center).