Eigentlich ist es faszinierend genug, dass wir heute mittels Computertomografie in das Innere unseres Körpers blicken können, ohne zu einem Skalpell greifen zu müssen. Schon bisher lieferten die aus den Rohdaten von CT-Scannern berechneten Schnittbilder wichtige und schnelle Informationen für Ärztinnen und Ärzte. Siemens Healthcare hat nun auf Methoden der Filmindustrie zurückgegriffen und zeigt mit „Cinematic Rendering“ realitätsnahe 3-D-Darstellungen des menschlichen Körpers. Im neuen Deep Space 8K des Ars Electronica Center Linz können Sie diese neuen bildgebenden Verfahren kennenlernen. Dr. Klaus Engel, Principal Key Expert bei Siemens AG, und Prim. Univ.-Prof. Dr. Franz Fellner vom AKh Linz präsentieren bei einem Deep Space LIVE am DO 15.10.2015, 20:00, und im Rahmen des Deep-Space-Wochenendes „Universum Mensch“ am SA 17.10.2015, 15:00, das „Cinematic Rendering“.

Was ist neu an diesen Bildern? Wie beleuchtet und färbt man eigentlich Organe, Knochen und Muskeln im Inneren des Körpers? Und was musste letztendlich das Team des Ars Electronica Futurelab berücksichtigen, um die 3-D-Visualisierungen in den eigens entwickelten Deep Space 8K zu bekommen? Dr. Klaus Engel von Siemens Healthcare und Roland Haring, technischer Direktor des Ars Electronica Futurelab, haben uns dazu einige Fragen beantwortet.

Credit: Dorin Comaniciu (Siemens Healthcare), Franz Fellner (Radiology Institute AKH Linz, Medical Society Upper Austria), Walter Märzendorfer (Siemens Healthcare)

Mit „Cinematic Rendering“ betritt Siemens Healthcare eine neue Ebene der Visualisierung des menschlichen Körpers. Wozu braucht es fotorealistische Bilder in der Medizin – das hat doch bisher ganz gut geklappt?

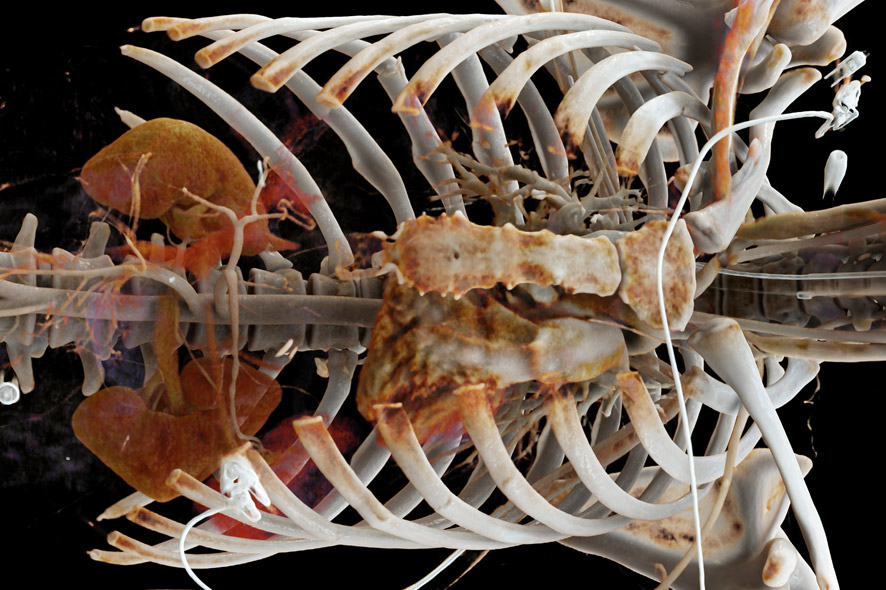

Klaus Engel: Das stimmt! Schon bisher konnten wir sehr detaillierte Bilder des menschlichen Körpers berechnen. Bestimmte visuelle Effekte, wie sie in der Natur auftauchen, konnten wir allerdings nicht abbilden. Die Wahrnehmung des Menschen ist darauf trainiert, kleinste Schattierungsnuancen zu interpretieren, um daraus Formen und Distanzen abzuschätzen. Diese unterschiedlichen Schattierungen kommen durch die komplexe Interaktion des Lichts mit Objekten zustande. Licht wird an Oberflächen reflektiert, gebrochen und gestreut. Es dringt aber auch in das Material ein, ändert dabei das Spektrum und immer wieder seine Richtung, um an einer anderen Stelle wieder aus dem Material auszutreten. Diese komplexen Pfade zu berechnen, die das Licht nimmt bis es auf der Netzhaut unserer Augen auftrifft, war bisher zu rechenaufwändig und die Algorithmen zu langsam.

Credit: Hospital do Coração, São Paulo, Brasilien / www.siemens.de/presse

Bei der realitätsnahen 3-D-Darstellung des menschlichen Körpers greifen Sie auf künstlerische Möglichkeiten des Animationsfilms zurück – was ist dabei so „cinematic“ an dieser Bildgebung?

Klaus Engel: Wie in der Filmindustrie benutzen wir zur Beleuchtung der Szene fotografisch aufgenommene Kugelpanoramen. Die Filmindustrie benutzt solche Kugelpanoramen, um digitale Charaktere, wie z.B. Gollum aus „Herr der Ringe“, in Szenen mit echten Schauspielern glaubhaft zu integrieren. Damit die Beleuchtung des digitalen Charakters, der häufig erst lange nach der Aufnahme in die Szene eingefügt wird, glaubhaft ist, wird zur Aufnahmezeit ein Kugelpanorama aufgenommen. Dieses wird später dann zur Beleuchtungsberechnung des digitalen Charakters eingesetzt. Licht und Schatten sowie die komplette Färbung der Szene ist dadurch bei den echten Schauspielern und den digital eingefügten Charakteren identisch.

Wir benutzen solche fotografischen Kugelpanoramen, um die medizinischen Daten in einer natürlichen Beleuchtung zu zeigen. Damit können wir sehr komplexe Beleuchtungsumgebungen schaffen, die die anatomischen Strukturen besonders gut zur Geltung bringen. Durch den hohen Dynamikumfang der entstehenden Bilder werden sehr dramatische Effekte erzielt, die wichtige Details für das Auge herausstechen lassen. Zudem können auch komplexe Kameraeffekte, wie variable Blenden, Belichtungszeiten und Optiken modelliert werden. Wir haben also sozusagen eine komplette virtuelle Kamera zur Erstellung der Bilder zur Verfügung und können damit auch künstlerische Effekte modellieren, um die Aussagekraft der Darstellung zu maximieren.

Welche Schritte sind notwendig, um aus den Daten eines Computertomographie-Scanners fotorealistische 3-D-Darstellungen aufbereiten zu können?

Klaus Engel: Zunächst werden aus den vom Scanner aufgenommenen Daten Schnittbilder durch den Körper rekonstruiert. Durch das Übereinanderlegen vieler solcher Schnittbilder entsteht ein 3-D-Volumen. In diesem 3-D-Volumen können wir nun alle möglichen Pfade, entlang derer sich Licht ausbreiten kann simulieren. Durch immer leistungsfähigere Grafikkarten und einen Algorithmus, der nur diejenigen Lichtpfade findet, die das Auge erreichen, können wir nun die komplexe Interaktion des Lichtes mit den medizinischen Daten simulieren. Die entstehenden Bilder sind sehr viel leichter zu verstehen – auch von untrainierten Betrachterinnen und Betrachtern. Das eröffnet neue Möglichkeiten der Anwendung solcher Bilder für die Kommunikation zwischen ÄrztInnen und PatientInnen und für die Ausbildung von MedizinstudentInnen am lebenden Patienten. Auch zur die Diagnose von Krankheiten hat das neue Verfahren enormes Potential – hier laufen die Studien aber noch.

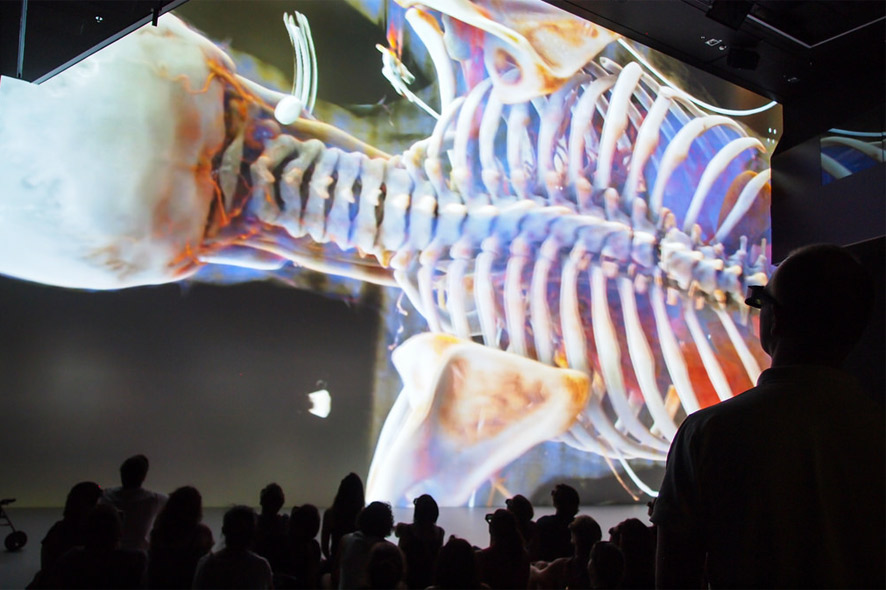

Mit „Universum Mensch“ hat sich der Deep Space 8K in einen virtuellen Anatomiesaal der Zukunft verwandelt. Welche Möglichkeiten bietet die vom Ars Electronica Futurelab entwickelte Umgebung, wenn es darum geht, medizinische Daten darzustellen?

Roland Haring: Der Deep Space 8K ist ein einzigartiges Multi-User Environment, das zur Interaktion und Kollaboration einlädt. Während klassische Virtual-Reality-Installationen auf wenige BenutzerInnen beschränkt sind, können im Deep Space 8K über 120 Personen gleichzeitig in dreidimensionale Welten eintauchen. Dies wird erst mit der Größe des Raumes und der Auflösung der Projektion möglich. Genau darin liegt die Stärke für die Visualisierung medizinischer Daten, die aufgrund ihres Detailreichtums von einer präzisen Darstellung profitieren. Über verschiedene – teilweise auch sehr experimentelle – Interfaces ermöglichen wir es den BesucherInnen und Besuchern, diese Bildwelten explorativ zu erfahren.

Wie detailliert sind die Darstellungen? Und wie kommen Sie eigentlich zu den Farben von Knochen, Muskeln und Organen?

Klaus Engel: Die Auflösung moderner CT-Scanner liegt bei ungefähr einem halben Millimeter. Das heißt, wir können sehr detaillierte Informationen über die Anatomie gewinnen und damit sehr detaillierte Bilder generieren. Durch einen CT-Scanner werden natürlich keine Farbinformationen aus dem Körper gewonnen, sondern der CT-Scanner liefert Informationen über die Abschwächung der Röntgenstrahlung im Körper. Knochen schwächen die Strahlung mehr ab als beispielsweise Muskelgewebe und können deshalb mittels einer Transferfunktion anders eingefärbt werden. Die Transferfunktion ordnet jedem Material unterschiedliche Farben und Transparenzen zu. So können wir Muskelgewebe und Knochen unterschiedlich einfärben oder auch Weichgewebe durchsichtig machen, um tiefer in den Körper schauen zu können. Organe lassen sich rein auf Basis der Röntgenabsorption nicht unterscheiden. Dafür gibt es heutzutage fortgeschrittene Bilderkennungsverfahren, die automatisch die Organe und Strukturen erkennen und aus dem Scan extrahieren können.

Credit: Martin Hieslmair

Müssen die Daten aus dem Computertomografie-Scanner für den Deep Space 8K noch nachbearbeitet werden?

Roland Haring: Im Prinzip arbeiten wir bei diesem Projekt mit medizinischen Daten wie sie in jedem modernen Krankenhaus produziert werden können. Diese Daten sind aber monochrom, da es sich um Dichtemessungen handelt. Wie bereits gesagt, die Farben werden mittels spezieller Computeralgorithmen erst nachträglich errechnet. Für unterschiedliche anatomische Datensätze gibt es vordefinierte Farbtabellen, die dann zugewiesen werden. Der visuelle Eindruck, der so erweckt werden kann, ist dann sehr plausibel.

Wäre die Echtzeit-Darstellung dieser Visualisierungen des Menschen im „alten“ Deep Space möglich gewesen?

Roland Haring: Nein, aus mehreren Punkten nicht. Erstens haben wir jetzt mit den neuen Projektoren im Deep Space 8K vier Mal so viele Bildpunkte und daher eine doppelt so hohe Auflösung wie vorher. Zweitens waren die Geräte insgesamt am Ende ihrer Lebenszeit schon sehr lichtschwach. Und drittens hätten wir mit den alten Rechnern keine Chance gehabt, solche Visualisierungen mit einer ausreichend flüssigen Bildrate pro Sekunde darzustellen. Bei uns kommt ja erschwerend dazu, dass wir bei stereoskopischen Projekten sämtliche Bildinhalte jeweils für das linke und das rechte Auge – und somit mit der doppelten Bildrate – rendern müssen. Das sind dann 120 Hz.

Credit: Dorin Comaniciu (Siemens Healthcare), Franz Fellner (Radiology Institute AKH Linz, Medical Society Upper Austria), Walter Märzendorfer (Siemens Healthcare)

Wie sehen die bildgebenden Verfahren im Jahr 2025 aus? Welche Aufgaben haben Sie noch auf Ihrer Liste?

Klaus Engel: Aus meiner Sicht wird die Nutzung solcher fotorealistischen Bilder in zehn Jahren Routine sein. Jede und jeder Interessierte, ob Ärztin oder Arzt, Patientin oder Patient, wird in der Lage sein, die medizinischen Bilder aus der digitalen Patientenakte auf einem Tablet betrachten und analysieren zu können. Das Bewusstsein über den eigenen Körper und die eigene Gesundheit wird dadurch enorm gestärkt werden. Die Benutzung muss dazu aber für den Laien noch einfacher werden. Organe und andere anatomische Strukturen müssen automatisch erkannt und für den Nutzer sofort aussagekräftig dargestellt werden. Der Computer kann dabei sicher Hinweise auf Veränderungen geben, die endgültige Diagnose wird in den meisten Fällen aber weiter beim Arzt liegen.