Das Steigen und Fallen des Meeresspiegels, die Wassertemperatur, die Feuchtigkeit, die Anziehungskraft des Mondes und die Position der beobachtenden Menschen – mit all diesen Echtzeitdaten hat maotik eine Visualisierung im Deep Space 8K des Ars Electronica Center realisiert, die er beim Ars Electronica Festival im September 2016 erstmals präsentierte. Wie er auf diese Idee kam und wie er diese schließlich umgesetzt hat, erzählt er uns in diesem Interview.

In Ihrer Arbeit geht es vor allem um die Visualisierung von Phänomenen der Natur – und um Tagträume. Können Sie uns etwas mehr darüber erzählen, wie es zu diesem Projekt kam?

Maotik: Im Allgemeinen interessiere ich mich sehr dafür, intuitive Werkzeuge und Interfaces zu entwickeln, bei denen ich die volle Kontrolle über mehrere ganz unterschiedliche Medien habe. Das gibt mir die Möglichkeit, neue Erfahrungen und neue Formen der Kommunikation zu erforschen. Ich habe mich immer schon für Visualisierungen interessiert, die auf ein spezielles Ereignis reagieren – im Gegensatz zu bereits zuvor gerenderten Videos, die schließlich nur abgespielt werden. Selbst wenn man mit interaktiven Visualisierungen nicht dieselbe grafische Qualität wie bei zuvor exportieren Videos erreicht, machen es die vielen Möglichkeiten und das Potential an Improvisation wieder wett.

Hinter meinen Visualisierungen steckt die Idee, ausreichend „Intelligenz“ und Zufälligkeit in das System einzubauen, damit die Visualisierungen organisch wirken und unvorhersehbar bleiben. In den vergangenen Jahren konzentrierte ich mich vor allem auf Experimente mit Sounds und Visuals. Dieses Projekt war schließlich die Gelegenheit, mein Forschungsgebiet zu erweitern und Echtzeitdaten einzusetzen. Daten aus der Natur verwandle ich dabei in poetische Interpretationen. Meiner Meinung nach wird hier die Beziehung zwischen der Natur und der Kunst umgedreht. Und es ist möglich, über die Auswirkungen des Menschen auf dieser Erde zu nachzudenken.

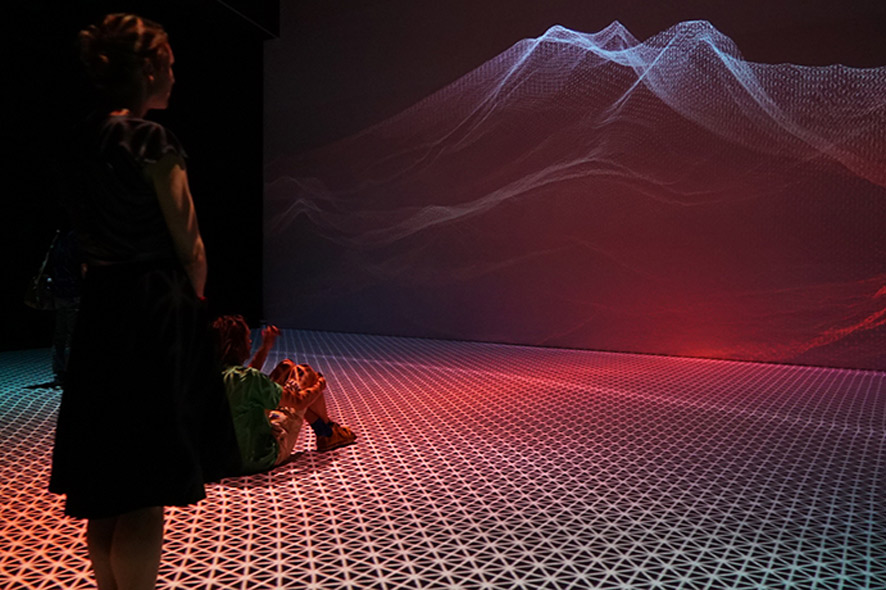

Die Idee zu diesem Projekt kam mir als ich den Deep Space 8K im Ars Electronica Center zum ersten Mal besuchte – dieser begehbare Raum und diese riesengroße Projektionsfläche inspirierten mich so sehr, dass ich mich auf das Element des Horizonts konzentrierte. Ars Electronica gab mir schließlich die Möglichkeit, drei Tage lang meinen Inhalt zu testen. Dann entwickelte ich mein Projekt, das ich schließlich im vergangenen September beim Ars Electronica Festival erstmals präsentierte.

Credit: maotik

Welche Art von Daten verwenden Sie in Ihrer Installation, wie interagieren die Werte und warum haben Sie sich für diese Einheiten entschieden?

Maotik: Ich bin in der Nähe des Atlantischen Ozeans aufgewachsen und mich haben die Landschaften und Horizonte immer schon fasziniert. Und gerade die Tatsache, dass sich der Horizont immer wieder bildlich ändert, je nach Meeresspiegel, Wind oder Regen. Man kann jeden Tag an die Küste spazieren und sieht die Dinge immer wieder etwas anders. Deshalb dachte ich, dass genau das es wert ist, dies mit einem generativen System zu erforschen. Ich wollte diese sich verändernden Landschaften in einem riesigen Multimedia-Erlebnis darstellen.

Der Ozean kann ein entspannender und spielerischer Ort sein, aber gleichzeitig ist er für Menschen auch gefährlich und imposant. Wir werden daran erinnert, wie klein wir eigentlich sind im Vergleich zur Natur und warum wir das respektieren sollten. Im Mai 2016 begann ich gemeinsam mit dem Programmierer Mickael Skirpan, den ich in Boulder, Colorado, getroffen habe und der als PhD-Student bereits mit Daten bei ähnlichen Projekten gearbeitet hat, meine Ideen zu entwickeln. Er half mir die Parameter zu bekommen, die ich besonders interessant fand. Im Gegensatz zu Klang- und Sounddaten ist es bei Echtzeitdaten nicht gerade leicht diese aus einer Datenbank heraus zu visualisieren. Als ich einmal mit einem Klangkünstler zusammengearbeitet hatte, konnte ich die Daten mit meinem Gehörsinn wahrnehmen. Wenn man mit Zahlen aus einer Datenbank arbeitet, dann ist die Herausforderung viel größer, da man sie mit keinem Sinn begreifen kann.

Ich habe elf verschiedene Parameter verwendet, um die Form des Ozeans generieren zu können. Dabei verbinden wir uns mit einer Datenbank aus der wir eine Reihe an Daten wie beispielsweise die Höhe des Meeresspiegels, der Gezeiten, der Feuchtigkeit, der Niederschlagsmenge, der Windstärke, Windrichtung, des Mondzyklus, des Standorts und der Tageszeit auslesen. Während die Werte der Windstärke oder des Meeresspiegels die Bewegung des Meeres beeinflussen, ändern andere Daten wie die des Niederschlags oder der Feuchtigkeit die Farben. Das Schwierige dabei war, Algorithmen zu schaffen, die stets eine interessante Ästhetik in Bezug auf Bild und Ton hervorbringen.

Credit: maotik

Welche Programmiersprache haben Sie eingesetzt und was waren für Sie die Herausforderungen, um so ein Projekt für den Deep Space 8K zu entwickeln?

Maotik: Dieses Projekt habe ich mit der Software TouchDesigner entwickelt – eine visuelle Entwicklungsumgebung, die ich bereits seit vier Jahren nutze, um verschiedene Projekte zu produzieren – angefangen von großen audiovisuellen Performances bis hin zu interaktiven Installationen liefert mir dieses Programm die notwendigen Tools, um fortschrittliche Echtzeitvisualisierungen kreieren zu können. Es ist eine grafische Programmiersprache, die es aber auch ermöglicht, Scripts in Python und GLSL zu schreiben.

Die Herausforderung, Inhalte für solch eine riesige Umgebung zu schaffen, ist es ist, eine Visualisierung zu gestalten, die die Perspektive des Raumes verändern kann. Im Deep Space ist wie bei einem Video-Mapping der Standpunkt der BetrachterInnen entscheidend, um einen Trompe-l’œil-Effekt zu bekommen. Der Deep Space hat zwei Ebenen – eine begehbare Fläche der Bodenprojektion und eine Aussichtsplattform, von der aus die BesucherInnen von oben zusehen können. Ich musste also über eine visuelle Komposition nachdenken, die aus jedem Blickwinkel interessant sein könnte.

Credit: maotik

Wie haben Sie sich gefühlt als Sie zum ersten Mal hier im Ars Electronica Center durch Ihre eigene Visualisierung spaziert sind?

Maotik: Mit dieser Installation wollte ich vor allem diesen Reiz des lebendigen Etwas weitererzählen, das hier und jetzt geschieht. Ich glaube, ganz allgemein gesprochen, eine einfache Interaktion funktioniert am besten wenn die BesucherInnen über den Boden spazieren und sich daraus Wellen formen – Wasserbewegungen zu beobachten ist immer mit einem angenehmen Gefühl verbunden. Diese riesige Projektion und das Surround-Sound-System unterstützt das Gehen durch diesen Ozean, durch diese massive Form, die sich laufend ändert.

Ich bin immer daran interessiert, Menschen dabei zu beobachten, wie sie selbst eine Multimedia-Umgebung wahrnehmen und sich ihr annähern. „Flow“ betraten einige BesucherInnen zunächst ganz langsam, andere forderten die Interaktivität der Bodenprojektion heraus und begannen zu laufen und zu springen, um Wellen erzeugen zu können. Andere setzten sich hin und meditierten zu dieser sich laufend verändernden Landschaft.