Im April 2023 sorgte ein Song namens „Heart on My Sleeve“ für weltweites Aufsehen. Die Stimmen? Unverkennbar Drake und The Weeknd. Doch das vermeintliche Dream-Duett war kein offizieller Release. Kein Marketing-Stunt. Kein Leak. Sondern: Fiktion. Ein anonymer User, der sich „ghostwriter977“ nennt, hatte die Stimmen der beiden Stars mithilfe Künstlicher Intelligenz synthetisiert und den Track auf TikTok veröffentlicht. Ein viraler Schockmoment, der viele Fragen auf über Urheberschaft, Authentizität und Kontrolle aufwarf.

Doch während die einen den Verlust künstlerischer Integrität fürchten, nutzen die anderen die neuen Möglichkeiten ganz bewusst. Die Musikerin Holly Herndon etwa entwickelte mit Holly+ ein Tool, das ihre Stimme synthetisch nachbildet und Dritten zur kreativen Weiterverwendung zur Verfügung stellt. In der visuellen Kunst sorgt Künstliche Intelligenz ebenfalls für neue Ausdrucksformen, wie das von Paul Trillo mit Hilfe von Sora produzierte Musikvideo zu The Hardest Part von Washed Out demonstriert.

Hand in Hand mit diesen Fortschritten branden Debatten auf: Ist KI ein Werkzeug, das Künstler*innen neue kreative Möglichkeiten eröffnet – oder eine Technologie, die unsere Kreativität standardisiert und entmenschlicht? Während die einen sie als Inspirationsquelle und kreativen Sparringpartner feiern, warnen die anderen vor der künstlerischen Gleichförmigkeit. Die „No to AI Art“-Bewegung, Protestaktionen auf Plattformen wie ArtStation genau wie laufende Klagen gegen Anbieter wie Stability AI zeigen den wachsenden Widerstand. Über 3.000 Musiker*innen – darunter ABBA und Radiohead – forderten 2024 in einem offenen Brief gesetzliche Schutzmaßnahmen.

Wie aber kann man sicherstellen, dass KI nicht einfach existierende Musik reproduziert? Welche Rolle spielen ethische Fragen, etwa bei Copyright oder Bias in den Trainingsdaten? Was bedeutet Originalität, wenn eine KI in Sekundenschnelle Bilder, Musik oder Texte erzeugt? Der australische Musiker Nick Cave reagierte entsetzt, als eine KI versuchte, seinen Stil nachzuahmen. Sein Urteil: „Dieser Song ist Bullshit!“ Cave argumentierte, dass Kunst für ihn aus menschlichen Emotionen entstehe – aus Schmerz, Leidenschaft und Erfahrung. Eine KI könne all dies nur simulieren, aber niemals wirklich fühlen.

2022 gewann das Bild “Théâtre d’Opéra Spatial”, erschaffen mit Midjourney, einen Kunstpreis – ohne dass die Jury wusste, dass es von einer Maschine stammte. Der Aufschrei folgte prompt. Ähnlich beim Kinderbuch “Alice and Sparkle”, dessen KI-generierte Illustrationen nicht nur Bewunderung, sondern auch scharfe Kritik hervorriefen. Viele fürchten, dass menschliche Kreativität durch KI verwässert wird – oder schlimmer noch: ersetzt.

Mikey Shulman, CEO des Musik-KI-Start-ups Suno, erklärte kürzlich provokant: „I think the majority of people don’t enjoy the majority of time they spend making music.“ Seine Lösung: „Just prompt for a song.“ Kreativität wird hier zum Klickprozess – effizient, aber entkoppelt von handwerklichem Können und emotionalem Ausdruck. Auch Anbieter wie Udio verfolgen diesen Ansatz. Plattformen wie Splice setzen auf eine unterstützende Rolle von KI: Nicht als Ersatz für kreative Prozesse, sondern als Werkzeug, das künstlerische Arbeit inspiriert, erweitert und begleitet.

Die zentrale Frage bleibt: Welche Vision verbinden wir mit KI in der Kunst? Soll sie ein günstiges und effizientes Produktionswerkzeug für Gebrauchsgrafiken, Stockmusik und automatisierte Inhalte sein? Oder kann sie ein Katalysator sein, der unsere Kreativität auf eine neue Stufe hebt und künstlerische Prozesse bereichert?

Ali Nikrang ist Forscher am Ars Electronica Futurelab und Professor für KI und musikalische Kreation an der Hochschule für Musik und Theater in München und überzeugt davon, dass Künstliche Intelligenz den kreativen Prozess nicht übernehmen und automatisieren darf. Die Technologie soll den Menschen herausfordern, dazu motivieren neue kreative Horizonte zu entdecken: “Kreativität entsteht nicht durch bloßes Kopieren, sondern durch das Weiterentwickeln von Gedanken und das Überwinden von gewohnten Mustern.”

Inspiration oder Imitation?

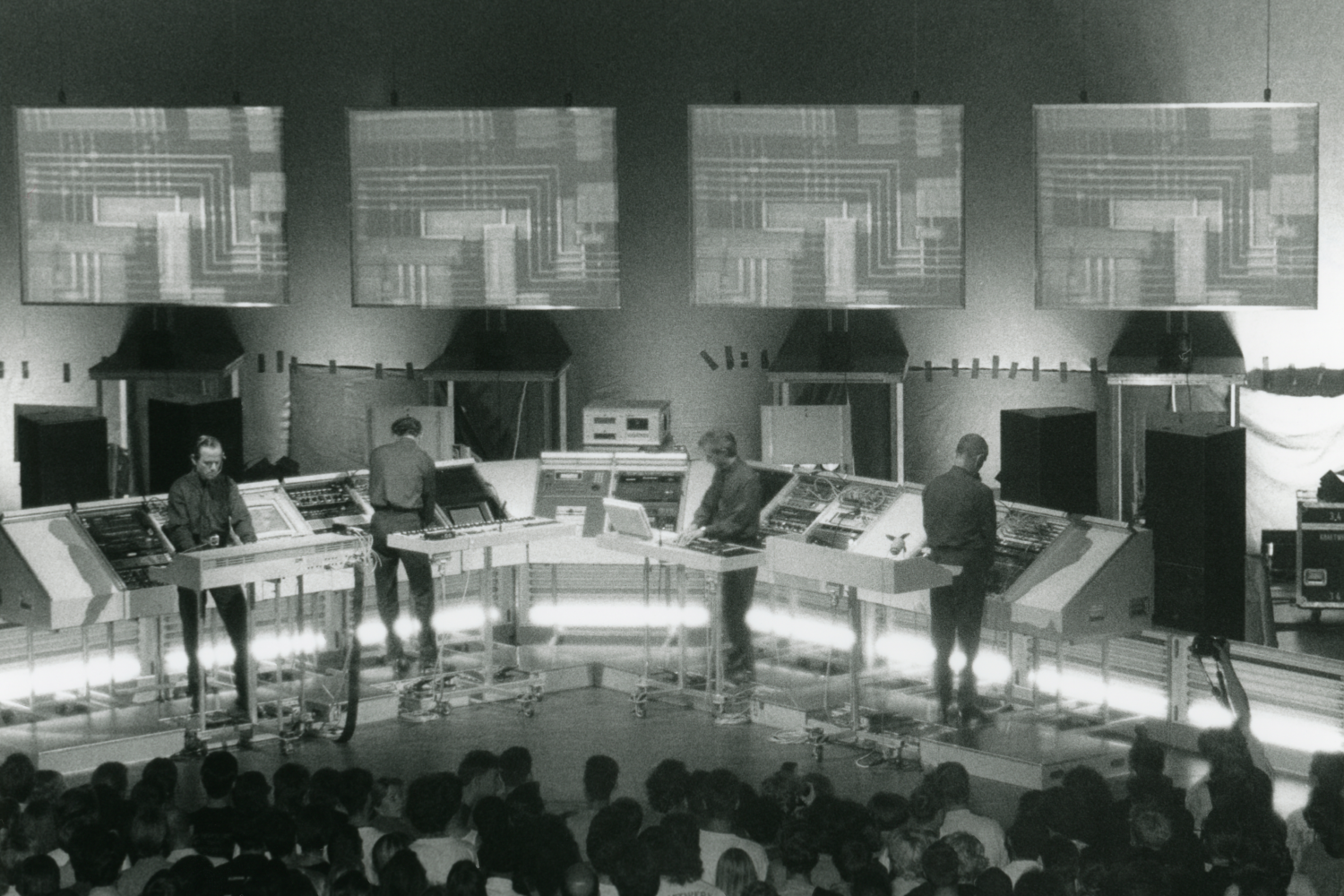

Die Geschichte der Musik ist eng mit technologischen Entwicklungen verbunden. Neue Technologien haben oft neue musikalische Möglichkeiten eröffnet und künstlerische Schaffensprozesse grundlegend verändert. In den 1960er- und 1970er-Jahren erlebte die Musik eine Revolution: Der Synthesizer trat auf den Plan. Damals galt er für viele als Fremdkörper, als kalte Maschine, die niemals die Wärme eines Orchesters ersetzen würde können. In den 1970ern ermöglichten Synthesizer und Sequencer dann völlig neue Kompositionsmethoden. Musiker*innen wie Kraftwerk, Isao Tomita oder Wendy Carlos zeigten, dass mit diesen Maschinen nicht nur Klänge nachgeahmt, sondern völlig neue Klangästhetiken geschaffen werden konnten. Etwas, das vielleicht auch für KI gilt?

1985 erhielt der US-amerikanische Komponist David Cope einen Auftrag zur Komposition einer Oper über das in Arizona und New Mexico lebende Volk der Navajos. Eine anhaltende Schreibblockade hinderte ihn jedoch daran, den Auftrag umzusetzen. Je näher der Abgabetermin rückte, desto schwerer fiel es ihm, sich auf das Komponieren zu konzentrieren. Kolleg*innen der University of California, Santa Cruz (UCSC) rieten im Scherz, sich von einem Computer bei der Komposition der Oper helfen zu lassen, um die Blockade zu überwinden. Er entwickelte das Programm „Experiments in Music Intelligence“ (EMI), das seine früheren Werke analysierte und ihm half, Kompositionsvorschläge zu generieren. Mit der Unterstützung von EMI konnte Cope die Oper „Cradle Falling“ fertigstellen, 1989 wurde sie uraufgeführt. Die Kritiker*innen waren begeistert und feierten die Oper als „ein modernes Meisterwerk“ – freilich ohne zu wissen, dass ein Computer an der Komposition beteiligt war.

Dieses frühe Analyseprogramm, ein Vorgänger heutiger KI-Programme, zeigt was Künstlicher Intelligenz zum kreativen Schaffensprozess beizutragen vermag. „KI muss kein Imitationswerkzeug sein, sondern kann durchaus eine explorative Dimension haben“, erklärt Nikrang. „Für Kunstschaffende ist es ja wenig reizvoll, wenn KI nur imitiert. Es geht darum, neue und individuelle Konzepte zu entwickeln, die über die bloße Reproduktion hinausgehen.“ Die Technologie wird mit großen Datensätzen trainiert und generiert Vorschläge, die der Mensch dann weiterverfolgt. Kreativität entsteht in einem Entdeckungsprozess, in dessen Verlauf die Künstler*innen die Möglichkeiten der KI erkunden und gezielt steuern, um ihr individuelles Konzept zu entwickeln.

„Neue Technologien haben schon immer neue künstlerische Ausdrucksformen ermöglicht. Von KI erwarte ich ähnliches“, so Ali Nikrang. Und genau hier wird es spannend: Welche Klangwelten werden wir uns mit KI in Zukunft erschließen? Welche kreativen Räume wird die Technologie für Musiker*innen, Komponist*innen, Sounddesigner*innen eröffnen?

Trotz vieler berechtigter Bedenken sieht Ali Nikrang KI nicht als Bedrohung: „KI ist weder ein einfacher Pinselstrich noch eine autarke künstlerische Entität. Sie ist ein Werkzeug mit Eigenheiten.“ Genauso wie Maler*innen, die mit einer neuen Farbe experimentieren, müssen Künstler*innen lernen, mit KI zu arbeiten und ihre Möglichkeiten auszuloten. “KI ist nicht das Ende der Kunst, sondern eine neue Leinwand. Sie liefert keine fertigen Antworten, sondern einen kreativen Spielraum, der abhängig von den jeweiligen Absichten und Visionen der Kunstschaffenden völlig unterschiedliche Ergebnisse hervorbringen kann.”

Wird sich unsere Wahrnehmung von Musik verändern, wenn Maschinen mit komponieren? Oder ist das nur der nächste Schritt in einer langen Geschichte technischer Innovationen, die den Klang und das Verständnis von Musik schon immer geprägt haben?

Künstliche Intelligenz trifft klassische Musik

im Rahmen des Projekts „Walzersymphonie“ – eine Kooperation zwischen Johann Strauß 2025 Wien, dem Ars Electronica Futurelab und mehreren Musikhochschulen – geht Ali Nikrang diesen Fragen auf den Grund. Ziel des Projekts ist es, herauszufinden, wie KI in der Musikkomposition eingesetzt werden kann, ohne dass sie bestehende Werke imitiert. Ali Nikrang arbeitet dabei mit Studierenden und einer von ihm selbst entwickelten KI-Technologien. „Es geht nicht darum, dass KI Johann Strauß einfach nachahmt. Es geht um neue, individuelle künstlerische Konzepte“, betont er.

Studierende der Universität für Musik und darstellende Kunst Wien, dem Mozarteum Salzburg, der Zürcher Hochschule der Künste und der Hochschule für Musik und Theater München – arbeiten mit “Ricercar”, einem von Ali Nikrang entwickelten KI-System, das nun eigens mit Musik von Johann Strauss trainiert wurde. “Es war spannend zu beobachten, wie sich die Ansätze der Teilnehmenden entwickelten”, sagt Ali Nikrang. “Viele von ihnen kamen erstmals mit KI in Berührung und schnell zeigte sich, dass KI nicht nur eine technische Herausforderung darstellt, sondern auch neue kreative Wege eröffnet.”

„Ricercar“ ist ein interaktives, KI-basiertes Musikkompositionssystem, das seit 2019 von Ali Nikrang am Ars Electronica Futurelab in Linz und seit 2023 parallel and der Hochschule für Musik und Theater in München entwickelt wird. Im Gegensatz zu generativen KI-Plattformen wie Suno oder Udio, bei denen auf Knopfdruck fertige Songs entstehen, ist Ricercar ein Unterstützungstool für Musiker*innen – insbesondere im Bereich der klassischen Musik. Die Software komponiert nicht vollkommen automatisiert, sondern reagiert dynamisch auf musikalische Vorgaben und Inspirationen der Nutzer*innen: etwa melodische, harmonische oder rhythmische Strukturen sowie Parameter wie Tempo, Tonart, Instrumentierung und Artikulation, die gezielt manipuliert werden können. Auf dieser Grundlage schlägt Ricercar kompositorische Weiterentwicklungen vor, die angenommen, verändert oder verworfen werden können. Es entsteht ein dialogischer Prozess, der musikalisches Know-how und ästhetisches Urteilsvermögen voraussetzt. Der Name Ricercar leitet sich vom italienischen „ricercare“ – „suchen“ – ab und verweist auf eine historische musikalische Form des Experimentierens und Erkundens. Genau dieses Prinzip liegt dem System zugrunde: Nicht das schnelle Generieren eines fertigen Ergebnisses steht im Mittelpunkt, sondern das gemeinsame Ausloten musikalischer Ideen.

Die Zukunft der kreativen Zusammenarbeit

Wird KI eines Tages eigenständig Kunst schaffen? Vielleicht. Die Antwort auf diese Frage hängt weniger von der Leistungsfähigkeit der Technologie ab, sondern davon wie wir Menschen “Kunst” definieren. Und davon, welche Rolle wir KI beimessen wollen.

KI kann Effizienz steigern, aber kreative Arbeit ist viel mehr als Produktivität. Eine komponierende Person, die mit KI arbeitet, sucht nicht nach der schnellsten Lösung, sondern nach einer, die ihre Vision am besten einfängt. “Ich denke, dass KI langfristig nur dann interessant bleibt, wenn der Mensch als Schöpfer weiterhin die Kontrolle behält und KI nicht zu einer rein automatisierten, selbstständigen Entität verkommt”, meint Ali Nikrang. “Sie soll Kunstschaffenden dabei helfen, persönliche und individuelle Werke zu kreieren, anstatt bloß funktionale Aufgaben zu übernehmen.”

Ali Nikrang

Ali Nikrang ist ein multidisziplinärer Künstler und Forscher an der Schnittstelle von Musik und Künstlicher Intelligenz. Er arbeitet am Ars Electronica Futurelab und ist Professor für KI und musikalische Kreation an der Hochschule für Musik und Theater München. Mit einem Hintergrund in Informatik und klassischer Musik entwickelt er KI-gestützte Kompositionssysteme wie Ricercar und erforscht kreative Potenziale von KI in der Musik. Seine Arbeiten wurden international ausgestellt, unter anderem bei der Biennale Musica in Venedig und im Misalignment Museum in San Francisco. Zudem ist er als Jurymitglied und in kulturpolitischen Gremien aktiv.