Inhalt:

- KI – Künstliche Intelligenz

- Maschinelles Lernen – Machine Learning

- Teilgebiete des maschinellen Lernens

- Deep Learning

- Künstliches neuronales Netzwerk – Artificial Neural Network

- Elemente eines künstlichen neuronalen Netzwerks

- Netzwerkformen

- Autoencoder

- Systeme mit Gedächtnis

- Der Vektorraum Word2Vec

KI – Künstliche Intelligenz

Ziel der künstlichen Intelligenz (KI) ist, menschliche Wahrnehmung und menschliche Entscheidungsprozesse durch Maschinen und Rechenprozesse nachzubilden. Heutige KI ist sehr gut darin, bestimmte, eingegrenzte Aufgaben zu lösen. KI wird auf vielen Gebieten eingesetzt: in der medizinischen Diagnostik, für Zeichen- und Texterkennung, Bilderkennung und -generierung, Spracherkennung und -generierung sowie für automatisierte Übersetzungen, Navigationssysteme oder Autovervollständigung und Korrekturvorschläge bei Suchvorgängen. Sie unterstützt uns bei vielen Vorgängen, bei denen sich die Verarbeitung enormer Datenmengen durch das menschliche Gehirn sehr komplex gestaltet.

Chinese AI News Anchor, Xinhua: Chinas staatliche Nachrichtenagentur Xinhua präsentierte im November 2018 ihren ersten KI-Nachrichtensprecher. Gemeinsam mit Sogou, einer chinesischen Suchmaschine, entwickelte Xinhua die Sprecher mit Hilfe von maschinellem Lernen. Stimme, Mimik und Gestik eines menschlichen Nachrichtensprechers sollen simuliert werden.

Maschinelles Lernen – Machine Learning

Maschinelles Lernen ist ein Anwendungsbereich der KI. Maschinelles Lernen bringt Computerprogrammen auf Basis von Algorithmen (Rechenvorgänge nach einem bestimmten sich wiederholenden Schema) bei, aus Erfahrungswerten und Erlerntem selbständig weiterzulernen und in vollkommen unbekannten Situationen Entscheidungen zu treffen. Diese Programme können sich also selbst ändern. Normalerweise werden einem Algorithmus Trainingsmodelle vorgegeben: ein Datensatz mit verschiedenen Situationen und auch gleich die als richtig zu bewertenden Entscheidungen dazu.

Maschinelles Lernen ist bereits weit in unseren Alltag vorgedrungen: Das Programm empfiehlt uns personalisiert – also auf uns persönlich zugeschnitten – Produkte oder übersetzt automatisch Texte. Banken nutzen maschinelles Lernen, um Kreditausfälle vorherzusagen, Anträge mit Ausfallrisiko zu identifizieren und die Bonität zu bewerten. Auch in der medizinischen Diagnostik wird immer mehr auf automatische Datenauswertung gesetzt.

Learning to See: Gloomy Sunday, Memo Akten (TR): Learning to See ist eine fortlaufende Reihe von Arbeiten, die modernste Algorithmen des Machine Learning verwenden, um darüber zu reflektieren, wie wir die Welt verstehen. Was Menschen sehen ist eine Rekonstruktion, die auf unseren Erwartungen und früheren Überzeugungen basiert. Learning to See ist ein künstliches neuronales Netzwerk, das lose am menschlichen visuellen Kortex (der Hirnrinde) inspiriert ist, blickt durch Kameras und versucht zudem, das Gesehene zu verstehen. Natürlich kann es nur sehen, was es bereits weiß. Genau wie wir.

Teilgebiete des maschinellen Lernens

Überwachtes Lernen – Supervised Learning

Im überwachten Lernen werden dem Algorithmus (ein Rechenvorgang nach einem bestimmten sich wiederholenden Schema) vollständig gekennzeichnete Trainingsdaten zur Verfügung gestellt. Die Bedeutung von gekennzeichneten Trainingsdaten liegt darin, dass jedem Trainingsdatensatz auch die dazugehörenden Antworten zugeordnet sind. So wird dem Algorithmus bereits eine klare Anleitung zur Interpretation der Daten gegeben. Danach testet der Algorithmus verschiedene Szenarien selbst durch und ändert seine Parameter so lange, bis das Programm mit den Trainingsdaten im Test zufriedenstellend abschneidet.

Überwachtes Lernen nutzt ein Konzept namens Backpropagation oder Fehlerrückführung. Backpropagation ist ein Lernalgorithmus, der dem Netzwerk beim Lernen hilft: Fehler beim Entscheidungsprozess werden wieder in das Netzwerk eingespeist. Im Weiteren verändern sich dann die Gewichtungen, um zu einem besseren Ergebnis zu kommen. Die Backpropagation analysiert auch, welches Gewicht welchen Anteil an einem Fehler hat. Für die Optimierung des überwachten Lernens wird auch das Gradient Descent oder Gradientenverfahren genutzt: ein Verfahren zur Lösung einer Optimierungsaufgabe, das auf dem Prinzip der Bewegung in Richtung des stärksten Abstiegs, also des negativen Gradienten beruht.

Unüberwachtes Lernen – Unsupervised Learning

Wenn nicht genügend gekennzeichnete Trainingsdaten zur Verfügung stehen, kommt unüberwachtes Lernen zum Einsatz. In diesem Fall werden dem Algorithmus keine gekennzeichneten Trainingsdaten zur Verfügung gestellt. Stattdessen muss der Algorithmus selbst einen Weg finden, um die Daten zu ordnen und zu klassifizieren. Die Maschine versucht, in den Eingabedaten Muster zu erkennen, die vom strukturlosen „Rauschen“ abweichen. Dabei kommen verschiedene Algorithmen zum Einsatz: Clustering, das ähnliche Datenpunkte gruppiert; Anomalieerkennung, ein Algorithmus, der abweichende Daten in einem Datensatz findet; und Assoziation, die Beziehungen und Abhängigkeiten zwischen Daten erkennen kann.

Semiüberwachtes Lernen – Semi-Supervised Learning

Wenn die Kennzeichnung von massiven Mengen an Trainingsdaten zu teuer wäre, kann eine Mischung aus überwachtem und unüberwachtem Lernen eingesetzt werden. Ein gängiges Beispiel von semiüberwachtem Lernen sind Generative Adversarial Networks (GAN, deutsch „erzeugende gegnerische Netzwerke“). GAN ist eine besondere Architektur von neuronalen Netzen, in der zwei Netzwerke im Gegenspiel zueinander agieren und so voneinander lernen.

Verstärkendes Lernen – Reinforcement Learning

Ähnlich wie menschliches Lernen basiert verstärkendes Lernen auf der Idee, dass Belohnungen dazu führen können, bestimmte Aktionen anderen vorzuziehen. Hierbei werden die Aktionen eines Algorithmus beobachtet und als gut oder schlecht eingestuft. Mit der Zeit lernt das Netzwerk, die schlechten Aktionen zu vermeiden und die guten verstärkt einzusetzen. Je länger das Netzwerk trainiert, desto besser werden die Strategien, um das angestrebte Ziel zu erreichen.

Lyrebird: Das kanadische Start-up Lyrebird hat eine Software entwickelt, die in wenigen Minuten lernt, beliebige Stimmen digital nachzuahmen. Dazu wurde ein neuronales Netzwerk mit Sprechproben Tausender Menschen trainiert, wodurch es gelernt hat, die charakteristischen Merkmale einer Stimme zu erkennen. Lyrebird erstellt für die Stimme jeder neuen Person einen individuellen Schlüssel, der es erlaubt, neue Sätze mit dem digitalen Stimmavatar zu bilden.

Deep Learning

Deep Learning (deutsch „tief gehendes Lernen“) ist ein Teilbereich des maschinellen Lernens, der künstliche neuronale Netzwerke nutzt und mit mehreren Ebenen und komplexen Datenmengen arbeitet. Je mehr Ebenen vorhanden sind, desto besser kann sich das neuronale Netzwerk weiterentwickeln.

Deep Learning lehrt demnach Maschinen zu lernen: Die Maschine wird in die Lage versetzt, selbstständig ihre Fähigkeiten zu verbessern, indem aus vorhandenen Daten und Informationen Muster extrahiert und klassifiziert werden. Die gewonnenen Erkenntnisse lassen sich wiederum mit Daten in einem weiteren Kontext verknüpfen. Schließlich ist die Maschine fähig, Entscheidungen auf Basis der Verknüpfungen zu treffen.

Diese Art von Algorithmus-Anordnung eignet sich gut für die Verarbeitung großer Datenmengen, benötigt aber auch eine hohe Rechenleistung und eine deutlich längere Trainingszeit als herkömmliche Machine-Learning-Ansätze.

Moral Machine, MIT Media Lab, Scalable Cooperation (US): Intelligente Maschinen werden zunehmend eingesetzt, um komplexe, vom Menschen durchgeführte Tätigkeiten zu unterstützen oder gar ganz zu übernehmen. Intelligenten Maschinen wie autonomen Fahrzeugen wird dabei ein hoher Grad an Selbstständigkeit zugestanden, der dazu führen kann, dass diese moralische Entscheidungen treffen müssen. Daher ist nicht nur ein besseres Verständnis dafür erforderlich, wie Menschen solche Entscheidungen treffen, sondern auch, wie Menschen den Entscheidungsprozess von intelligenten Maschinen beurteilen. Die Moral Machine versucht anhand von moralischen Dilemmas im Straßenverkehr zu untersuchen, wie Menschen zu Entscheidungen stehen, die von autonomen intelligenten Maschinen getroffen werden. Am Ende der Umfrage können die Ergebnisse mit denen der anderen TeilnehmerInnen verglichen werden.

Künstliches neuronales Netzwerk – Artificial Neural Network

Neuronale Netzwerke sind eine Ansammlung von einzelnen Informationsverarbeitungseinheiten (Neuronen), die schichtweise in einer Netzarchitektur angeordnet sind. Künstliche neuronale Netzwerke sind eine Methode des maschinellen Lernens: Dabei handelt es sich um Rechensysteme, die aus künstlichen Neuronen bestehen und in Ebenen angeordnet sind. Im einfachsten Fall fließen Informationen beginnend mit der Eingabeschicht über eine oder mehrere verdeckte Zwischenschichten zu einer Ausgabeschicht. Der Output des einen Neurons ist also der Input des nächsten. Dieser typische Datenfluss wird auch Forward Propagation genannt: Die angelegten Eingabewerte laufen vorwärts durch das Netz und erzeugen die Ausgabewerte.

Wichtige Elemente eines neuronalen Netzwerks sind auch noch die Gewichtungen, die Intensität eines Informationsflusses. Das Ergebnis der Gewichtung wird oft durch eine sogenannte Aktivierungsfunktion geleitet, bevor es an die Neuronen der nächsten Schicht weitergeleitet wird. Die Gewichte werden während des Trainingsprozesses so angepasst, dass das Endresultat möglichst genau den Anforderungen entspricht. Es gibt die verschiedensten künstlichen neuronalen Netzwerke, die für unterschiedliche Zwecke eingesetzt werden.

Neural Network Training, Ars Electronica Futurelab: Dieses Convolutional Neural Network (CNN) hat mit vielen Trainingsbeispielen gelernt, bestimmte Objekte zu erkennen. Das Netzwerk besteht aus mehreren aufeinanderfolgenden Schichten, die während der Trainingsphase gelernt haben, unterschiedliche Eigenschaften in einem Bild zu erkennen und diese Information in Folge an die nächste Schicht weiterzugeben. Während die ersten Schichten eher primitive Eigenschaften wie gerade Linien, Farben und Kurven erkennen, spezialisieren sich die nachfolgenden Schichten auf komplexere Formen. Das hier verwendete Netzwerk VGG16 ist eines der bekanntesten Modelle dieser Art.

Elemente eines künstlichen neuronalen Netzwerks

Neuron

Künstliche Neuronen sind die kleinsten Teile eines künstlichen neuronalen Netzwerks. Sie bestehen aus jeweils einer mathematischen Funktion, einer Formel, die ein oder mehrere Inputs zu einem Output umrechnet, sind also sogenannte Informationsverarbeitungseinheiten. In einem künstlichen neuronalen Netzwerk sind jeweils mehrere Neuronen zu Schichten zusammengefasst, die sich untereinander Informationen weitergeben.

Verdeckte Schicht – Hidden Layer

In den verdeckten Zwischenschichten (Hidden Layers) eines neuronalen Netzwerks verstecken sich Definitoren: Ihre Funktion ist es, kleinere Details und Muster im Ganzen zu erkennen. Ein Neuron in einem Hidden Layer wird also aktiviert, wenn es ein in ihm einprogrammiertes Muster entdeckt. Man nennt diese Schichten „verdeckt“ oder „versteckt“, weil ihre In- und Outputs nirgendwo angezeigt werden, sie fungieren nur als vermittelnde Instanzen zwischen Eingabeschicht und Ausgabeschicht.

Aktivierungsfunktion – Activation Function

Die Aktivierungsfunktion in einem künstlichen neuronalen Netzwerk entscheidet bei jedem Neuron im Netzwerk, ob und wieviel an Informationen eines Neurons von der vorherigen Schicht durchgestellt wird. Sie ermöglicht es einem neuronalen Netz, Grenzwerte einer Entscheidungsfunktion zu erlernen. Es gibt verschiedenste Aktivierungsfunktionen wie Sigmoid, ReLU (Rectified Linear Unit), TanH oder ELU (Exponential Linear Unit).

Gewichtung und Verzerrung

Eine Information wird auf der Reise zwischen den Schichten mit Gewichtungen und Verzerrungen belegt, um festzustellen, ob das Signal gewisse Grenzwerte überschreitet und wichtig genug ist, um in die nächste Schicht weitergeleitet zu werden. Diese Gewichtungen und Verzerrungen verändern sich beim Lernen, während das Netzwerk seine eigenen Fehler korrigiert.

NORAA – Machinic Doodles, Jessica In (UK/AU): Wie erkennen wir Objekte, wenn wir sie mit Strichen und Linien skizzieren? Nach welchen Regeln zeichnen wir in einer bestimmten Reihenfolge von einem Punkt zum anderen? Und kann man einer Maschine beibringen, das Zeichnen selbst zu erlernen, anstatt ihr explizite Anweisungen zu geben? Welche Erkenntnisse bringt das für den menschlichen Zeichenprozess? Machinic Doodles ist eine interaktive Spielinstallation, die die Zusammenarbeit zwischen einem Menschen und einem Roboter namens NORAA untersucht, einer künstlichen Intelligenz, die lernt, zu zeichnen. Dabei wird untersucht, wie wir Menschen Ideen mit Strichen in einer Zeichnung zum Ausdruck bringen und wie eine Maschine über ein künstliches neuronales Netzwerk das Zeichnen erlernen kann.

Netzwerkformen

CNN – Convolutional Neural Network

Convolutional Neural Networks (CNN) werden hauptsächlich für Bildverarbeitung eingesetzt. Namensgebend ist das mathematische Verfahren der Konvolution (Faltung). Beim CNN sind die einzelnen Neuronen derart angeordnet, dass sie auf sich überlappende Bereiche reagieren. Mathematisch kann dieser Prozess als diskrete Faltung interpretiert werden – daher der Zusatz „convolutional“.

Ein CNN besteht aus vielen Schichten von künstlichen Neuronen, bei denen jedoch nicht alle Neuronenebenen komplett miteinander verknüpft sind. Die erste Schicht von Neuronen nimmt Pixel aus Beispielbildern. Die nächsten Schichten lernen dann das Konzept, wie die Pixel eine Kante bilden. Schließlich gibt diese Schicht dieses Wissen an andere Schichten weiter und kombiniert dieses Wissen über Kanten, um das Konzept einer Fläche zu erlernen. Dieser Prozess, das Wissen zu schichten, setzt sich bis zur letzten Ebene fort, wo die Algorithmen des neuronalen Netzwerks spezifische Merkmale und letztlich spezifische Gesichter erkennen können. Dabei übernehmen Convolutional Filter einen Großteil der Arbeit bei der Vereinfachung der Bildinformationen und deren Reduktion auf bestimmte Eigenschaften.

What a Ghost Dreams Of, h.o (INT): Was ist ein „Geist“? In der Regel wird er als innere „Seele“ und mysteriöse äußere Erscheinung verstanden. What a Ghost Dreams Of setzt sich mit einem neuen „Geist“ unserer Zeit auseinander: die digitale Überwachung in unserer Gesellschaft. Hier in der Main Gallery werden die BesucherInnen, wenn sie eintreten, von einem großen „Auge“ betrachtet. Alle, die vorbeigehen, werden per Computer Vision direkt in einen „Geist“ eingespeist, der neue digitale Gesichter von Menschen erzeugt, die es in der realen Welt nicht gibt. Was projizieren wir Menschen in das digitale Gegenüber, das wir mit KI erzeugen? Sie lernt unsere Welt ohne Vorkenntnisse kennen und generiert Daten, die es nie gab. Was sind die Auswirkungen der Verwendung von KI bei der Erstellung von Kunstwerken? Wer besitzt das Urheberrecht? Und wovon träumt die KI, der „Geist“, und was bedeutet das für uns als Menschen?

GAN – Generative Adversarial Network

Die Grundidee eines Generative Adversarial Network (GAN, deutsch „erzeugendes gegnerisches Netzwerk“) besteht darin, zwei Netzwerke gegeneinander auszuspielen. Das generative Netzwerk hat den Auftrag, das Diskriminator-Netzwerk zu überlisten, indem es immer bessere Fälschungen herstellt. Am Anfang steht hier eine kleine Menge an gekennzeichneten Trainingsdaten, die benutzt werden, um ein neues Set an Daten zu generieren – im Generator. Diese generierten Daten werden dann an ein anderes Netzwerk geschickt – den sogenannten Diskriminator, der identifizieren muss, ob die Daten gefälscht oder Teil des Trainingsdatensatzes sind. Die beiden Netzwerke kommunizieren demnach miteinander: das generative Netzwerk lernt so, bessere Fälschungen anzufertigen, und das zweite Netzwerk lernt, diese Fälschungen von echten Trainingsdaten besser zu unterscheiden. GANs werden eingesetzt, um künstliche Bilder zu generieren.

GauGAN, NVIDIA – Taesung Park, Ming-Yu Liu, Ting-Chun Wang, Jun-Yan Zhu: GauGAN ist eine Anwendung, die mit wenigen Pinselstrichen in der Lage ist, komplexe Landschaften zu errechnen. Man zeichnet simple Farbblöcke und wählt aus, welche Texturen diesen Farbflächen zugewiesen werden sollen: Sand, Meer, Berge, Wald, Pflanzen oder Gestein sind nur ein paar der Möglichkeiten. Wie der Name bereits impliziert, nutzt GauGAN Generative Adversarial Networks, um die Skizzen mit fotorealistischen Landschaftsmerkmalen auszustatten. GauGAN kann diese Bilder danach sogar in den Malstilen von verschiedenen Künstler Innen ausgeben.

cGAN – Conditional Generative Adversarial Network (pix2pix)

Ein Conditional Generative Adversarial Network (cGAN) ist ein erweitertes GAN, das nicht nur auf die Ergebnisbilder zugreifen kann, sondern auch auf die Eingabebilder. Darüber hinaus bekommt das Generatornetzwerk die Aufgabe, nicht nur gute Fälschungen zu erstellen, sondern auch schlechte, damit das Diskriminator-Netzwerk besser lernen kann. cGANs sind die Grundlage für pix2pix-Anwendungen, bei denen man etwa eine Zeichnung anfertigen kann und das Netzwerk stellt die Zeichnung als Katzenbild oder im Stil von Vincent van Gogh dar.

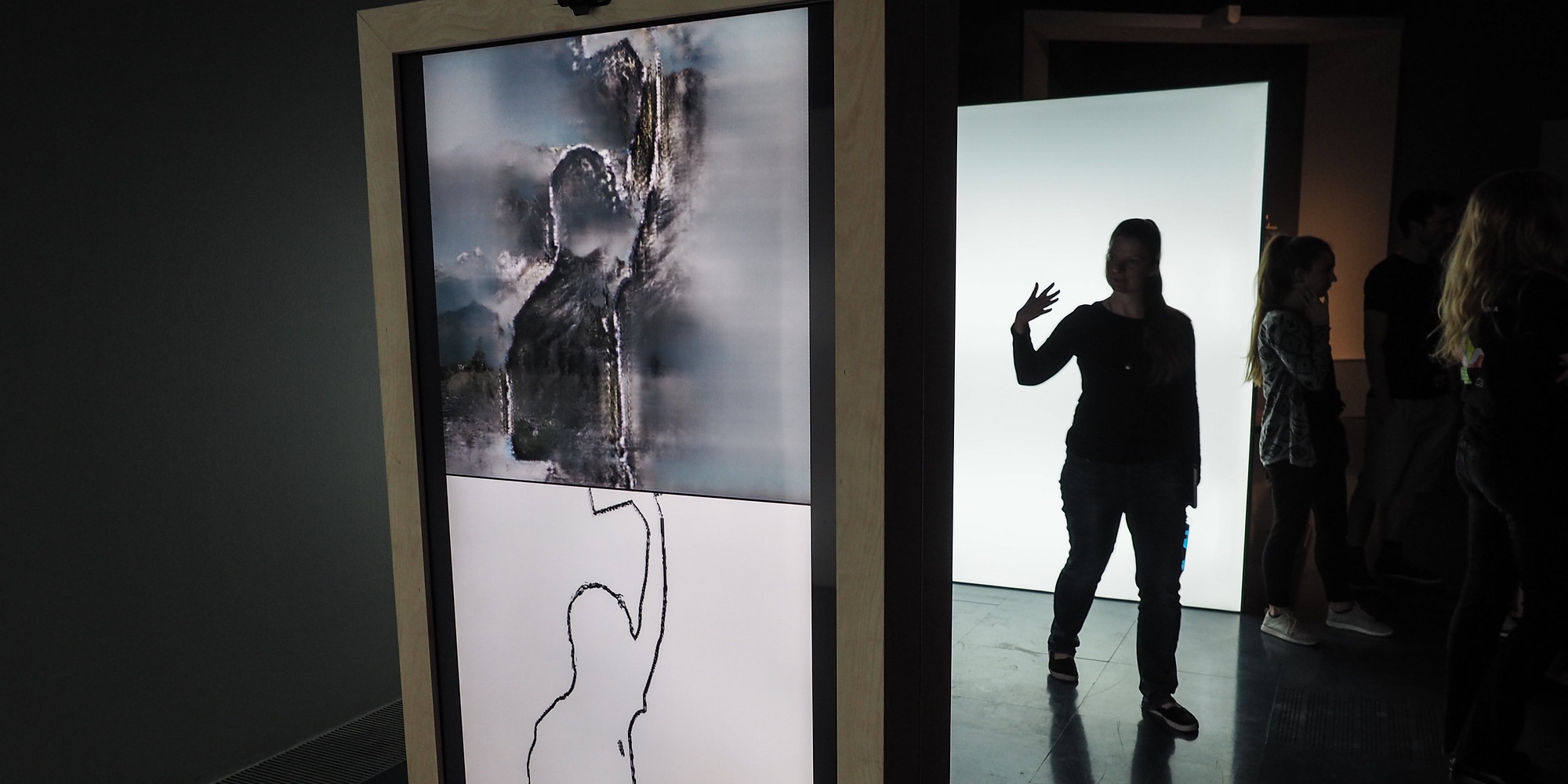

ShadowGAN, Ars Electronica Futurelab (AT): Das ShadowGAN erkennt die Silhouetten von Menschen und füllt diese dann zum Beispiel mit errechneten Bildern von Bergen aus. In einem der Beispiele wurde die KI mit unzähligen Bildern von Bergen und Berglandschaften trainiert, es kennt also nur natürliche Landschaften und Berge. So interpretiert es quasi in allem, was es sieht, Berge, selbst in der menschlichen Gestalt. Im Hintergrund wird ein Conditional Generative Adversarial Network (cGAN) benutzt.

Autoencoder

Ein Autoencoder ist eine Form des unüberwachten Lernens, bei der das Programm lernt, einen Input so zu reduzieren und danach wiederherzustellen, dass das Ergebnis möglichst nahe an der Eingabe liegt. Dieser Prozess ist besonders in Fällen relevant, bei denen die Eigenschaften von Daten reduziert werden müssen, um die Komplexität zu verringern, wobei die wichtigen Informationen dabei nicht verloren gehen sollen. Man bezeichnet diese Eigenschaften in der Sprache des maschinellen Lernens auch als Dimensionen.

Latent Space

Latent Space ist eine Variation des Autoencoders. Latent Space kann ausgehend von zwei Beispielen alle Möglichkeiten errechnen, die zwischen diesen zwei Beispielen liegen, und visualisieren.

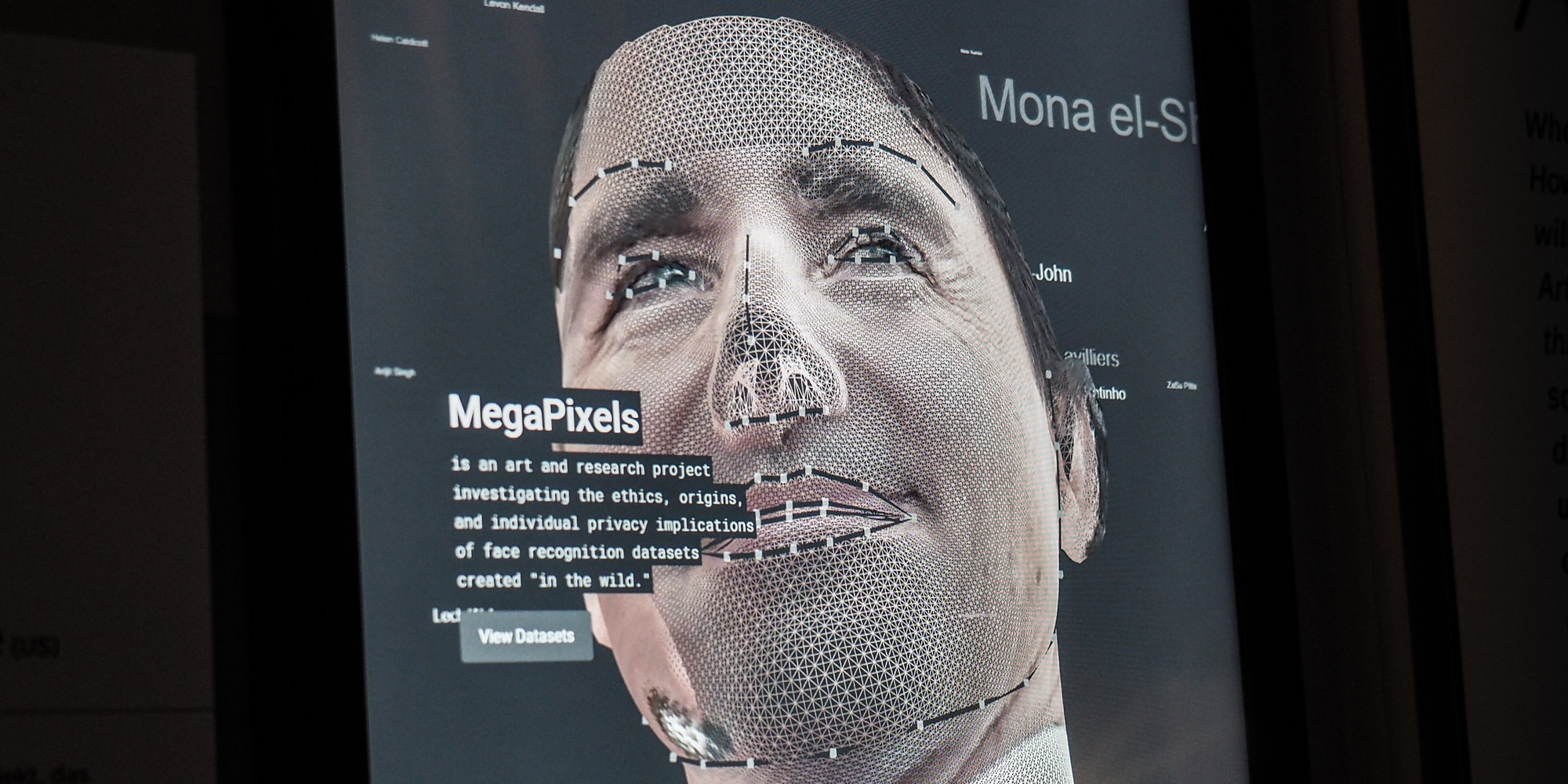

MegaPixels, Adam Harvey (US), Jules LaPlace (US): MegaPixels ist ein unabhängiges Kunst- und Forschungsprojekt, das die Herkunft und die individuellen Auswirkungen von Datensätzen zur Bilderkennung sowie damit verbunden die Ethik in Bezug auf die Privatsphäre und ihre Rolle bei der Erweiterung biometrischer Überwachungstechnologien untersucht. Das Projekt zielt darauf ab, eine kritische Perspektive auf Machine Learning-Bilddatensätze zu bieten, die von akademischen und industriell finanzierten Think-Tanks für KI übersehen werden könnten. Jeder auf dieser Website präsentierte Datensatz wird einer gründlichen Überprüfung seiner Bilder, Absichten und Finanzierungsquellen unterzogen.

Systeme mit Gedächtnis

RNN – Recurrent Neural Network

Recurrent Neural Networks (RNN, deutsch „rückgekoppelte neuronale Netzwerke“) sind mit einem internen Speicher ausgestattete Netzwerke, die Muster in Sequenzen von Daten erkennen können. Sie nutzen das Konzept der Backpropagation: Die Ergebnisse werden immer wieder in das Netzwerk eingespeist, damit das Netzwerk davon lernen und sich weiterentwickeln kann. Öfters wird auch eine Variante benutzt, in der zwei RNNs parallel Verwendung finden, wobei eines der beiden vom Output ausgehend zurückrechnet. Anwendungsbereiche von RNN liegen in der Textverarbeitung, der Genomforschung, Handschrifterkennung, Spracherkennung oder im Ordnen großer numerischer Serien, die etwa von Sensoren oder Aktienmärkten ausgegeben werden.

LSTM – Long Short-Term Memory

Ein Long Short-Term Memory (deutsch „langes Kurzzeitgedächtnis“) ist im Grunde ein etwas komplexeres RNN. Die Wiedereinspeisung der Fehler passiert hier nicht nur über die Eingabeebene, sondern auch an mehreren Filterpunkten, die entscheiden, ob die Informationen weiterwandern dürfen. Diese Filterpunkte bestehen aus einer spezialisierten Gedächtniszelle, die sich je nach Wichtigkeit gezielt Informationen entweder merken oder vergessen kann. Dieser Mechanismus sorgt dafür, dass das Netzwerk sich Informationen nur merkt, solange sie gebraucht werden.

NLP – Natural Language Processing

Das Natural Language Processing (NLP, deutsch Computerlinguistik) ist eine KI-Methode zur Erkennung von Sprache und ihren Anwendungs- und Grammatikregeln, indem Muster in großen Datensätzen identifiziert werden. NLP wird immer mehr in sozialen Netzwerken eingesetzt, um Stimmungsanalysen über bestimmte Produkte für den Marketingbereich durchzuführen.

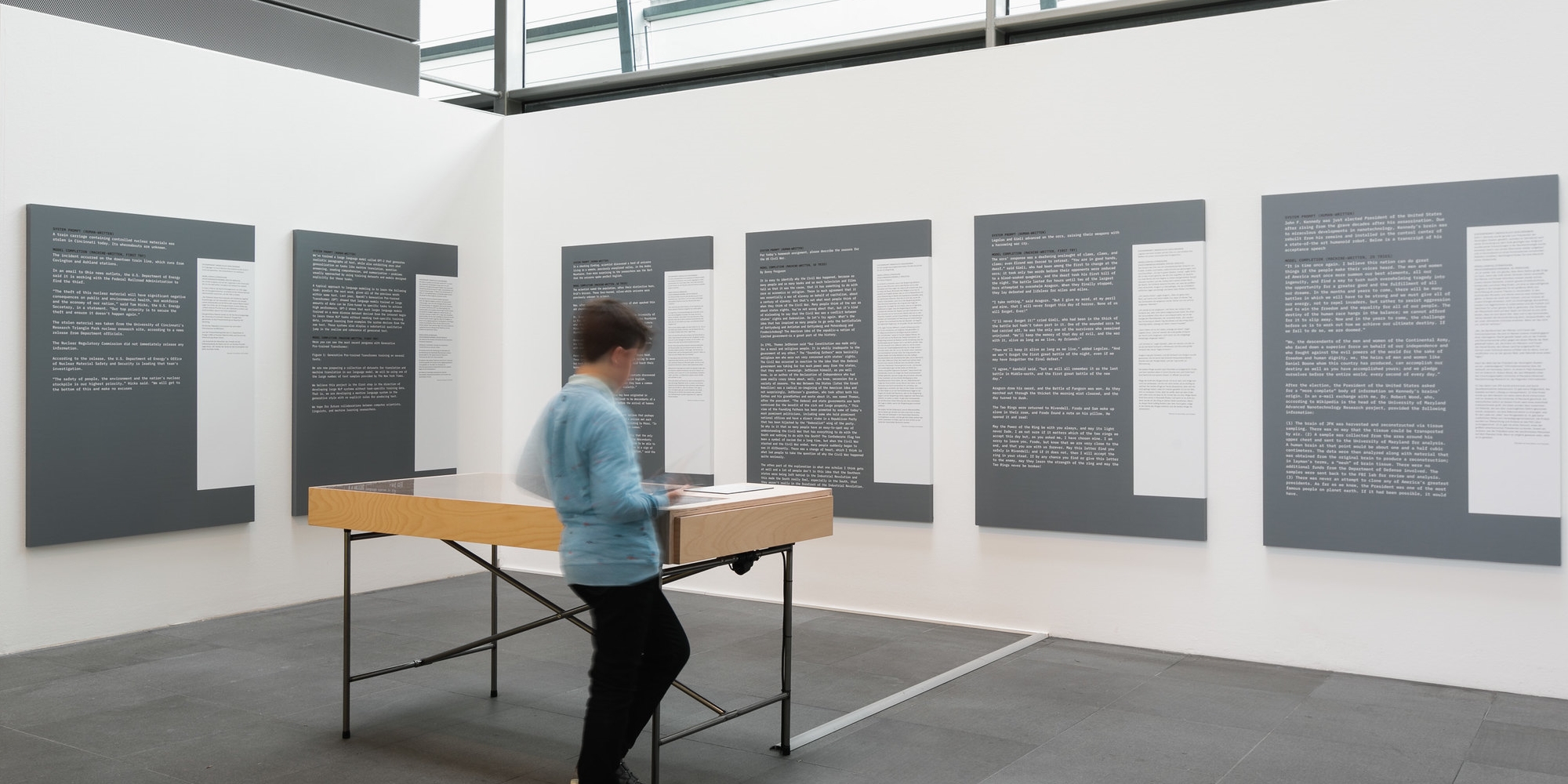

GPT-2: Λόγος – Vom Ursprung der Worte: OpenAI, eine Non-Profit-Organisation, die sich mit der Erforschung von künstlicher Intelligenz beschäftigt, hat ein groß angelegtes KI-Sprachmodell entwickelt, das fähig ist, ganze zusammenhängende Textparagrafen zu erschaffen: GPT-2. Es kann einfach strukturierte Texte verstehen, automatisch übersetzen, schlichte Fragen beantworten und Inhalte zusammenfassen, ohne speziell für eine dieser Aufgaben trainiert worden zu sein. Aufgrund der hohen Qualität der sprachlichen Fähigkeiten von GPT-2 warnt das OpenAI-Team davor, dass das Modell für unlautere Zwecke missbraucht werden könnte. Es betont, dass BenutzerInnen dem Wahrheitsgehalt von Inhalten im Internet gegenüber noch skeptischer werden müssen und PolitikerInnen sich verstärkt um Regulative gegen den Missbrauch solcher Technologien kümmern sollten.

Der Vektorraum Word2Vec

Ein Vektorraum besteht aus einzelnen Datenpunkten, über die die Vektoren räumlich abgebildet werden können. Über den Winkel zwischen den Vektoren lassen sich Ähnlichkeiten bzw. Beziehungen zwischen den Datenpunkten feststellen. Je größer der Winkel, desto weniger Ähnlichkeit besteht, und je kleiner ein Winkel, desto größer die Ähnlichkeit. Vor allem aber repräsentiert jeder Wortvektor auch – zumindest ansatzweise – die semantische Bedeutung des Wortes im Kontext. So können mit vortrainierten Word2Vec-Modellen etwa „mathematische Rechnungen mit Wörtern“ umgesetzt werden: PARIS – FRANKREICH + ÖSTERREICH = WIEN. Das heißt, hier ergibt zum Beispiel der Vektor für das Wort PARIS minus dem Vektor für das Wort FRANKREICH plus dem Vektor für das Wort ÖSTERREICH tatsächlich den Vektor für WIEN. Dies natürlich nicht exakt, aber der Vektor für WIEN ist der dem Ergebnis am nächsten liegende Vektor und kann daher als richtiges Ergebnis ermittelt werden.