Virtuelle Umgebungen scheinen das nächste Level der Visualisierung, Kommunikation und Zusammenarbeit zu sein. Auf eine immersive Wahrnehmungsillusion ausgelegt, stimulieren sie die Sinne eines immer anspruchsvolleren Publikums – doch was passiert eigentlich unter ihrer beeindruckenden Fassade? Und wie haben sich Sprache und Ausdruck im Laufe der Zeit an die wachsenden Herausforderungen der Realität angepasst? Florian Berger, Lead Developer und Artist im Ars Electronica Futurelab, über seinen Zugang zu virtueller Illusion und künstlicher Wirklichkeit und die 3D-Software VRizer – den entscheidenden Code, der hinter all dem steckt.

Anhand welcher Problemstellungen geht man im Ars Electronica Futurelab an die Entwicklung virtueller Umgebungen heran?

„Seit der Gründung des Ars Electronica Futurelab ist es ein wesentlicher Aspekt in unserer Forschungs- und Entwicklungsagenda, Hard- und Software zu entwickeln, die Künstler*innen einen niederschwelligen Zugang zu flexiblen und leistungsfähigen Virtual-Reality-Systemen ermöglicht.“ – Florian Berger

Florian Berger: Die (Re-)Konstruktion eines CAVE war im Jahr 1996 das erste Experiment des Ars Electronica Futurelab, für die Besucher*innen des Ars Electronica Center öffentlich zugängliche virtuelle Illusionen der Realität zu erzeugen.

Der CAVE war eine damals noch sehr neue Schnittstelle zur virtuellen Realität und wurde ursprünglich für Forschungszwecke entwickelt. Der kubische Raum von 3 mal 3 mal 3 Metern umgab die Teilnehmenden an Wänden, Decke und Boden mit Projektionen. Er wurde als kollaborative wissenschaftliche Visualisierungsumgebung für Anwendungsbereiche wie Medizin, Neurowissenschaft und Ingenieurwesen konzipiert. Er basierte auf der Idee, ein gemeinsames wissenschaftliches Visualisierungsmodell zu konstruieren, das viele unterschiedliche Anwendungen unterstützt: die interaktive Modellierung und Visualisierung medizinischer und biologischer Daten; dreidimensionale Formerfassung, -modellierung und -manipulation sowie dreidimensionale Faxe und Telekonferenzen mittels PCs.

Die Software CAVE-Lib, eine Library, die man dazu benutzte, um VR-Programme im CAVE ausführen zu können, steuerte ein Netzwerk von mindestens vier Rechnern, welche die Wand- und Bodenprojektionen jeweils in Abhängigkeit von der Position der Zuseher*innen synchronisierte, um in deren Wahrnehmung eine immersive Illusion zu erzeugen. Die Position der mit 3D-Brillen ausgestatteten Benutzer*innen wurde zu diesem Zweck mit Hilfe des magnetischen Positions-Trackings festgestellt.

Schon seit der Installation des CAVE im Ars Electronica Center haben uns viele Erfahrungen gezeigt, dass das Interesse der Künstler*innen, sich an dieser Entwicklung zu beteiligen, sehr groß ist. Doch Projekte, die mit der ursprünglichen Form des CAVE realisiert wurden, setzten voraus, dass die Künstler*innen, die dieses Environment für sich nutzen wollten, bereits bestimmte relevante Programmierkenntnisse besitzen – oder, dass sie für die Umsetzung ihrer Ideen mit Spezialisten zusammenarbeiten mussten.

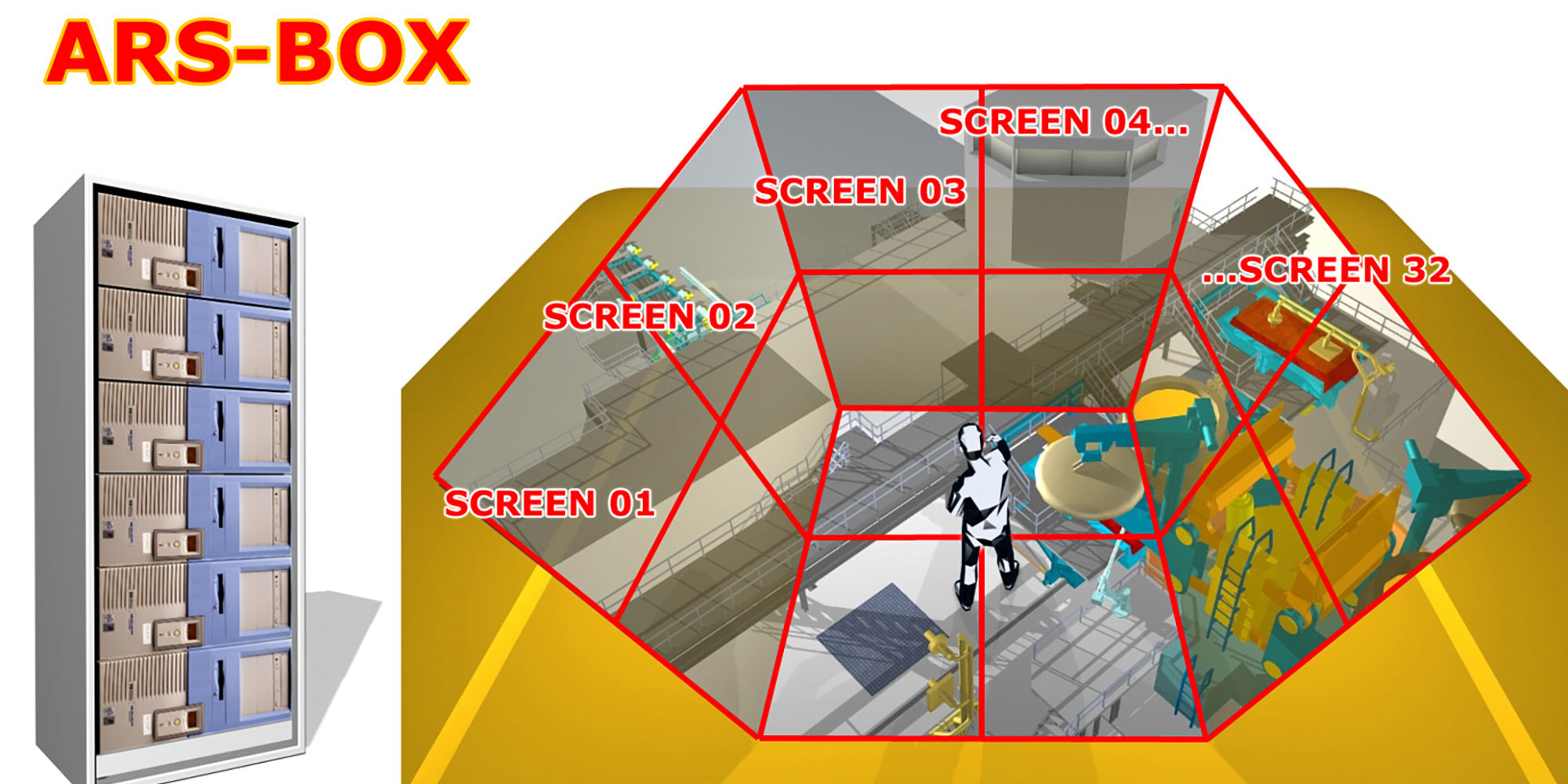

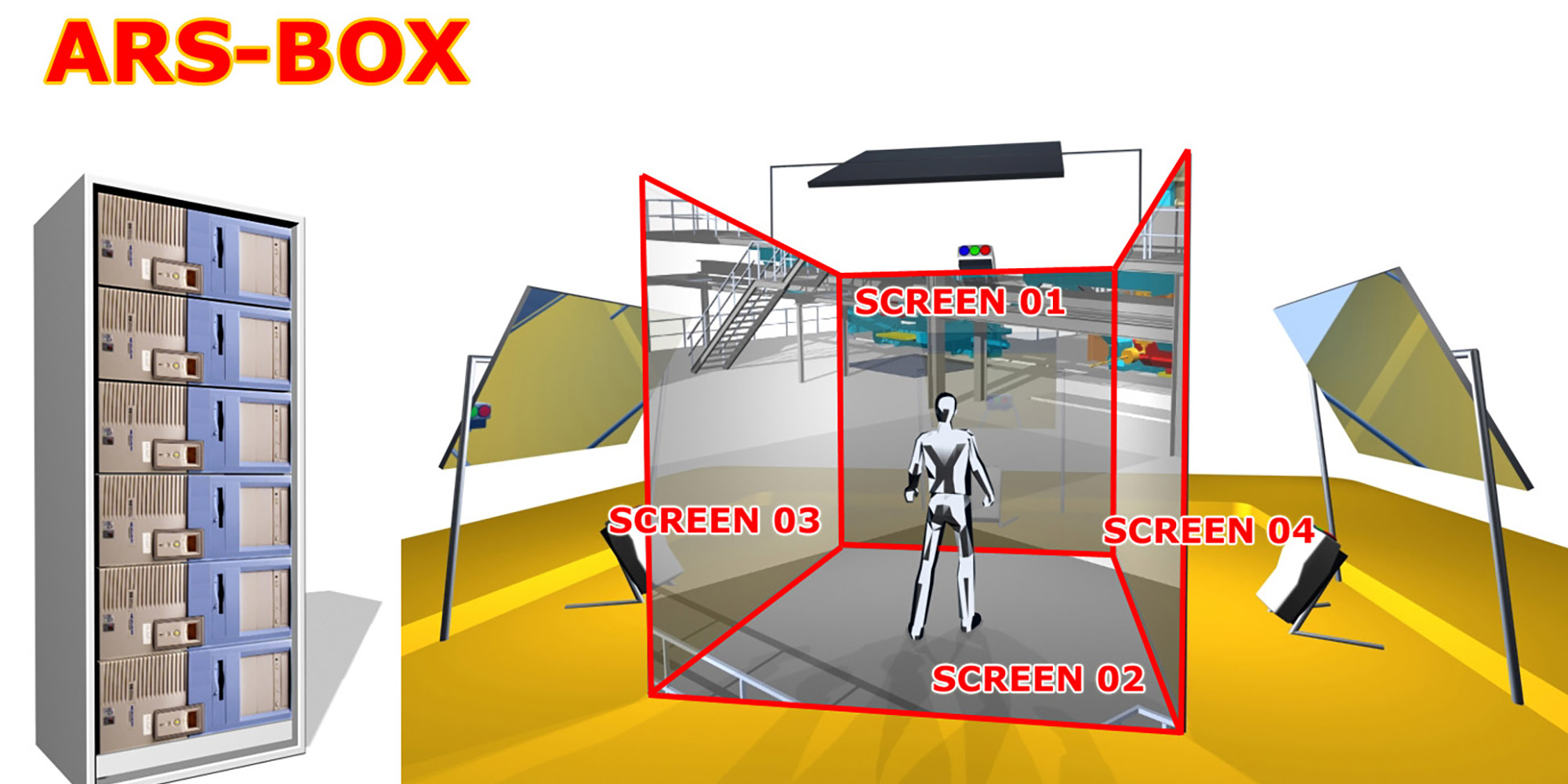

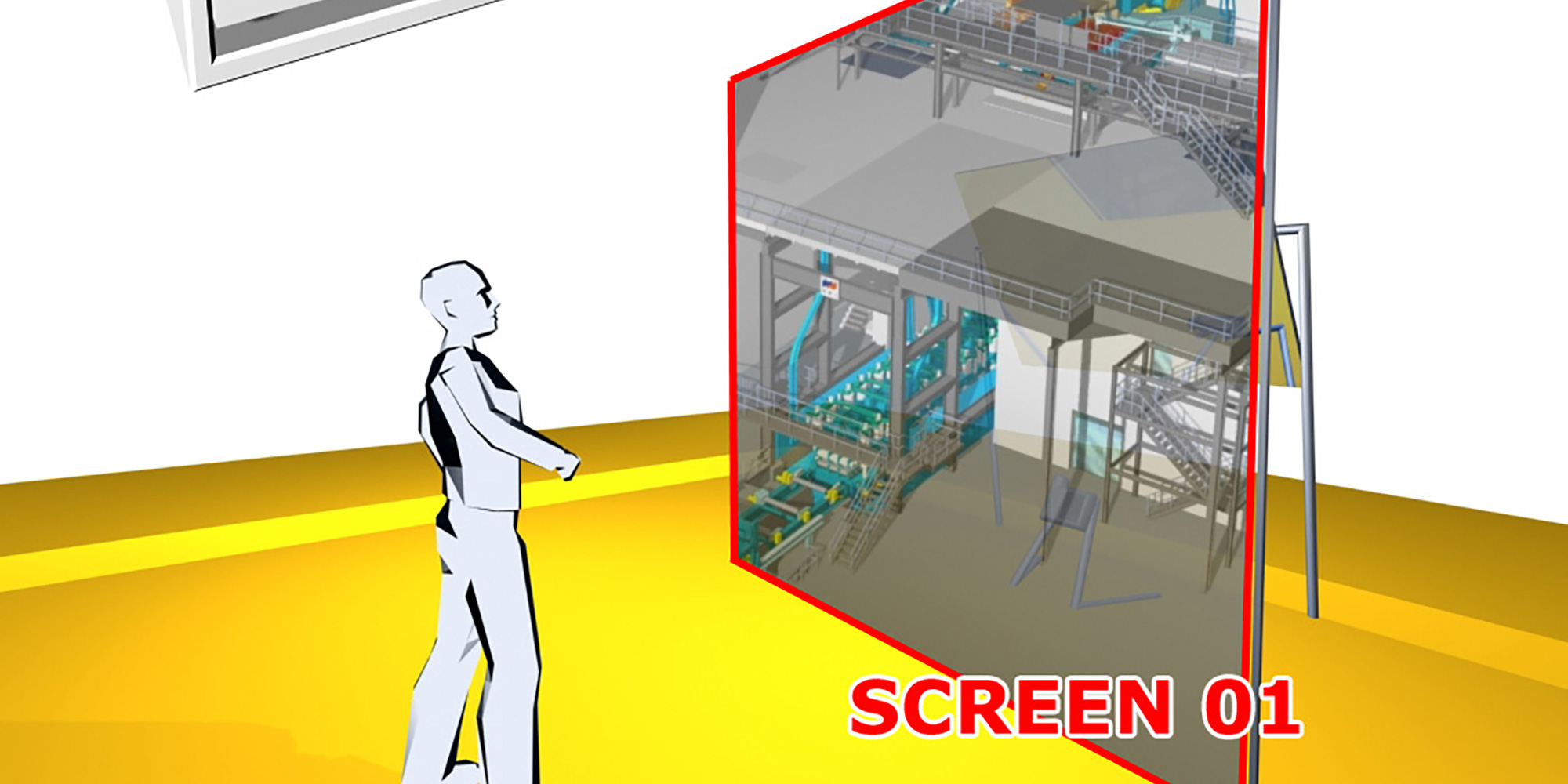

Außerdem waren die Anwendungen selbst zwangsläufig an ein kostenintensives Hardwaresystem gebunden, was die vorhandenen Kapazitäten zur Präsentation solcher Arbeiten erheblich einschränkte. Ein wichtiger Meilenstein in dieser Hinsicht war deshalb der Wechsel von – ursprünglich für immersive VR-Umgebungen benötigten – Großrechnern zu PC-basierten Systemen: Die ARSBOX, ein im Ars Electronica Futurelab entwickelter Linux-PC-Cluster mit GeforceFX-Grafikkarte, ist ein gutes Beispiel dafür. Sie konnte den Aufwand für die Umsetzung künstlerischer Projekte damals radikal senken.

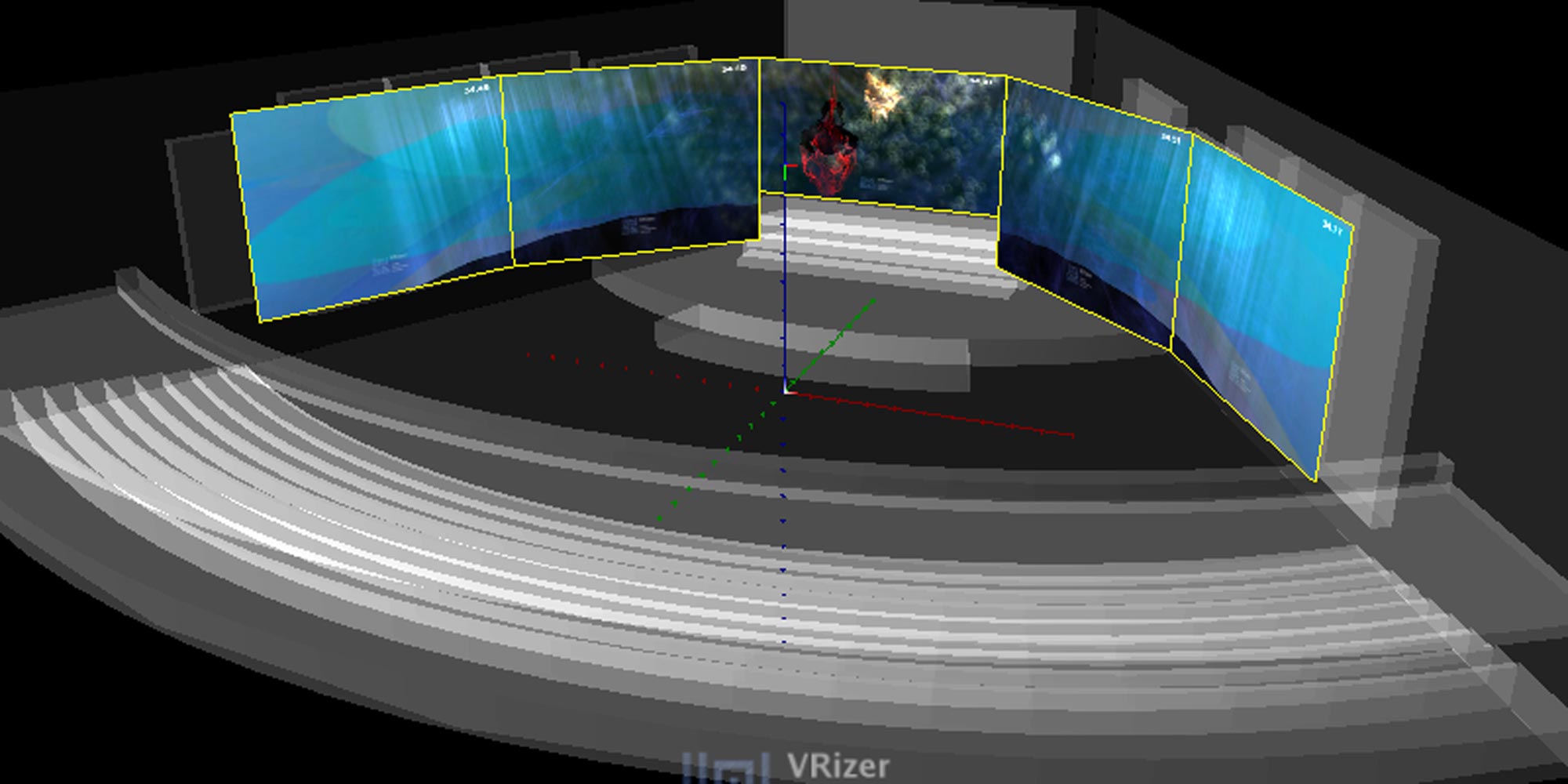

Mit der, auch hier im Lab entwickelten, 3D-Software VRizer konnte man in der ARSBOX ähnliche VR-Effekte erzielen, wie es die entsprechende Applikation im CAVE ermöglichte – mit dem entscheidenden Vorteil, dass sie auf handelsüblichen Rechnern mit vorinstalliertem Linux Betriebssystem lief und auf Software anwendbar war, die nicht ursprünglich für die Entwicklung von virtuellen Realitäten konzipiert war.

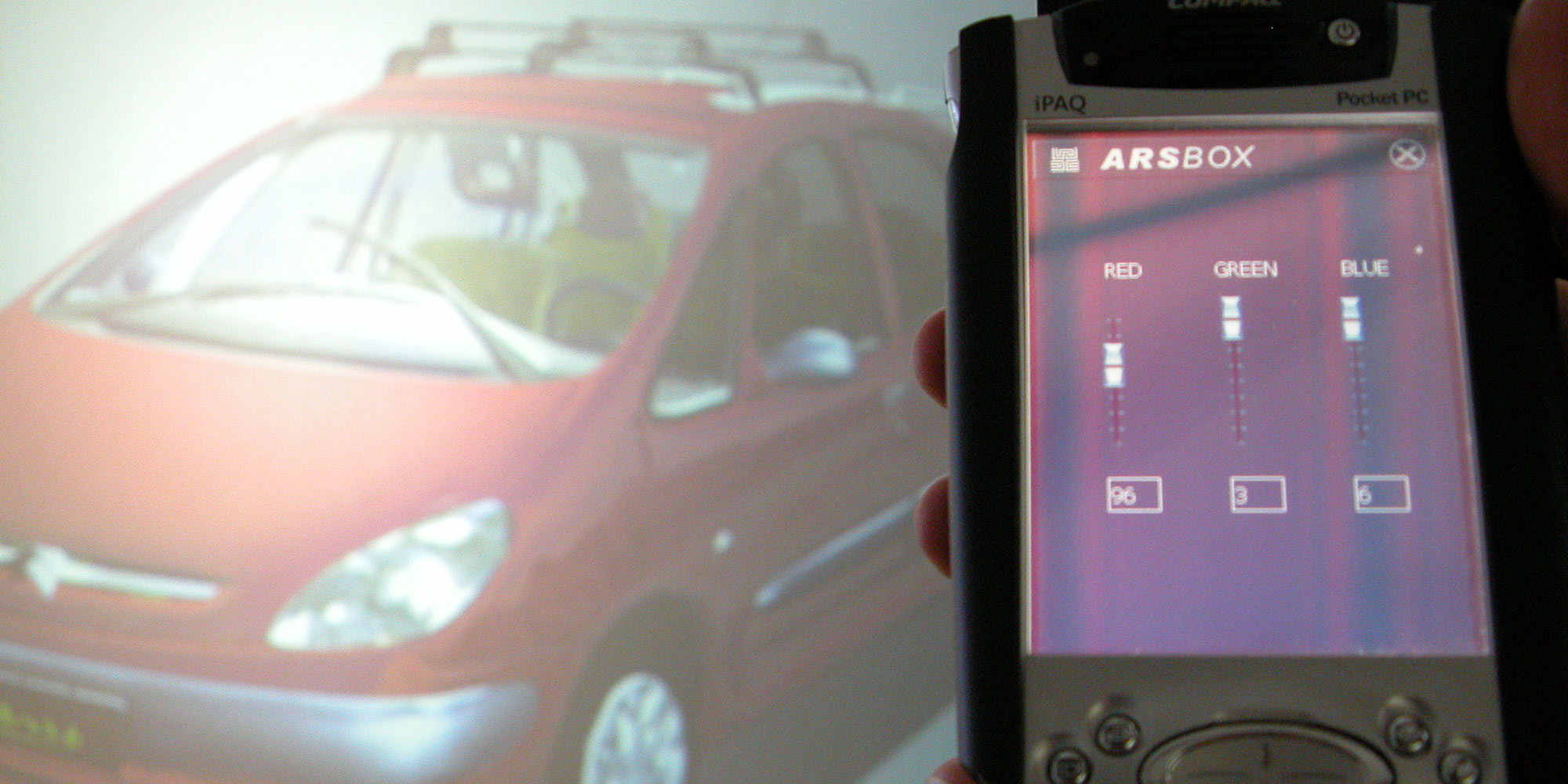

Die ARSBOX machte das virtuelle Prototyping damit auf einfache, niederschwellige Art und Weise möglich. Als Interaktions- und Steuerungsmedium des Systems diente ein PALMIST – ein Pocket- oder ein Tablet-PC –, der mit WLAN ausgestattet, auf dem vom Ars Electronica Futurelab entwickelte Software-Framework FATE läuft. Der PALMIST stellte alle grundlegenden Funktionsmerkmale zur Steuerung der Projektionsflächen zur Verfügung: Sowohl das Ändern von Parametern bestehender Objekte als auch das Erstellen neuer Objekte erfolgte damit; und die Ergebnisse konnten so in Echtzeit visualisiert werden.

Die Möglichkeit, mittels stereoskopischer virtueller Umgebungen interaktive Produktpräsentationen und -simulationen zu veranschaulichen, machte das System auch für den Marketingbereich und damit auch im wirtschaftlichen Kontext höchst relevant, denn bis zu diesem Zeitpunkt waren Visualisierungen dieser Art ausschließlich großen Industriebetrieben vorenthalten. Mit der ARSBOX und den VRizer konnten nun auch kleinere Unternehmen die hochmoderne Technologie nutzen, um Aufsehen zu erregen. Einen erfolgreichen Einsatz fanden ARSBOX und VRizer allerdings auch im kulturellen Rahmen, im Zusammenhang mit Großveranstaltungen im Brucknerhaus in Linz (AT) sowie vielen weiteren Präsentationen in aller Welt.

Was hat sich bisher geändert? Welche neuen Anforderungen sind im Laufe der Jahre hinzugekommen?

Florian Berger: Mit dem Deep Space 8K haben wir im Ars Electronica Center heute einen wirklich großen Raum zur Verfügung, der allein aufgrund seiner Dimensionen von 16 mal 9 Metern die Möglichkeit bietet, visuelle Illusionen sehr vielen Menschen gleichzeitig zugänglich zu machen. Die Anforderung an das System, seine Kapazitäten auch für große Gruppen von Besucher*innen zur Verfügung stellen zu können, hat sich alleine aufgrund der Tatsache gestellt, dass es für eine Institution wie das Ars Electronica Center ganz einfach nicht ausreicht, eine Single-User-Installation zu diesem Zweck zur Verfügung zu stellen.

Du hast die 3D-Software VRizer entwickelt. Welche Projekte wurden damit realisiert?

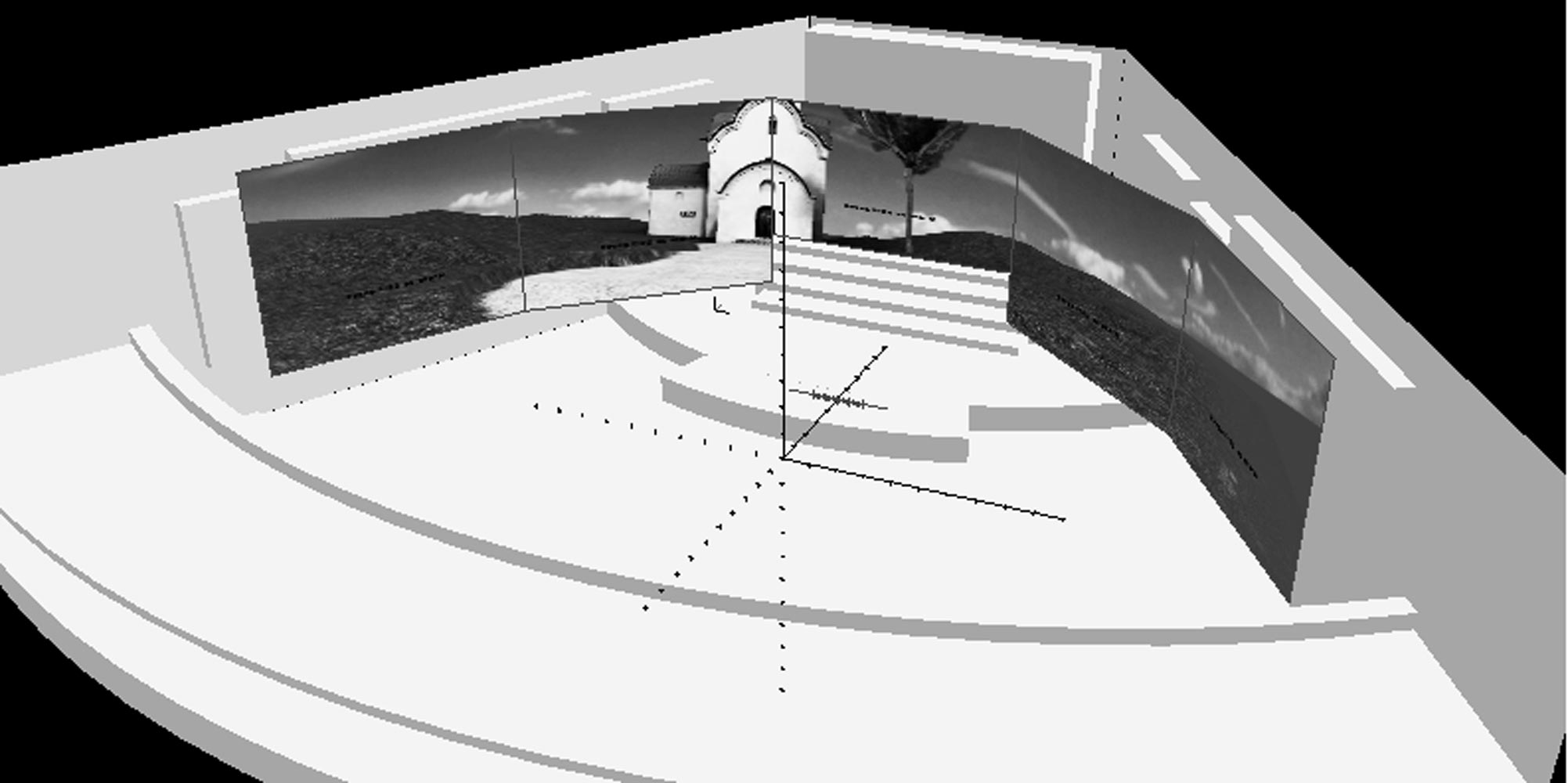

Florian Berger: Die Software hat uns nicht nur im Zusammenhang mit der ARSBOX gute Dienste geleistet. Auch im auf vielen anderen Stereo Setups und später auch im Deep Space 8K hat sie zum Beispiel mit der virtuellen Inszenierung des Millionenzimmers im Schloss Schönbrunn eine sehr zukunftsweisende Anwendung gefunden: Für dieses kollaborative Forschungs- und Entwicklungsprojekt haben wir einen Raum aus dem Schloss Schönbrunn mit einer High-End Echtzeit-Visualisierung virtuell inszeniert und konnten mit dem Pilotprojekt neue Maßstäbe für die digitale Konservierung unwiederbringlicher Kulturgüter – cultural heritages – setzen.

Auch der Zeremoniensaal und das Rosa Zimmer des Schlosses wurden im Rahmen dieses Projekts digitalisiert. Wie im Millionenzimmer ging es auch in diesen Räumen darum, die kunstvolle und mit seltenen Gemälden illustrierte Wandtäfelung virtuell und möglichst hochauflösend zu rekonstruieren, sie damit für die Nachwelt zu konservieren und über weite Distanzen weltweit zur Verfügung zu stellen. Die virtuelle Inszenierung aus dem Schloss Schönbrunn wurde sowohl im Deep Space 8K, als auch direkt vor Ort in Wien mit einer ARSBOX präsentiert.

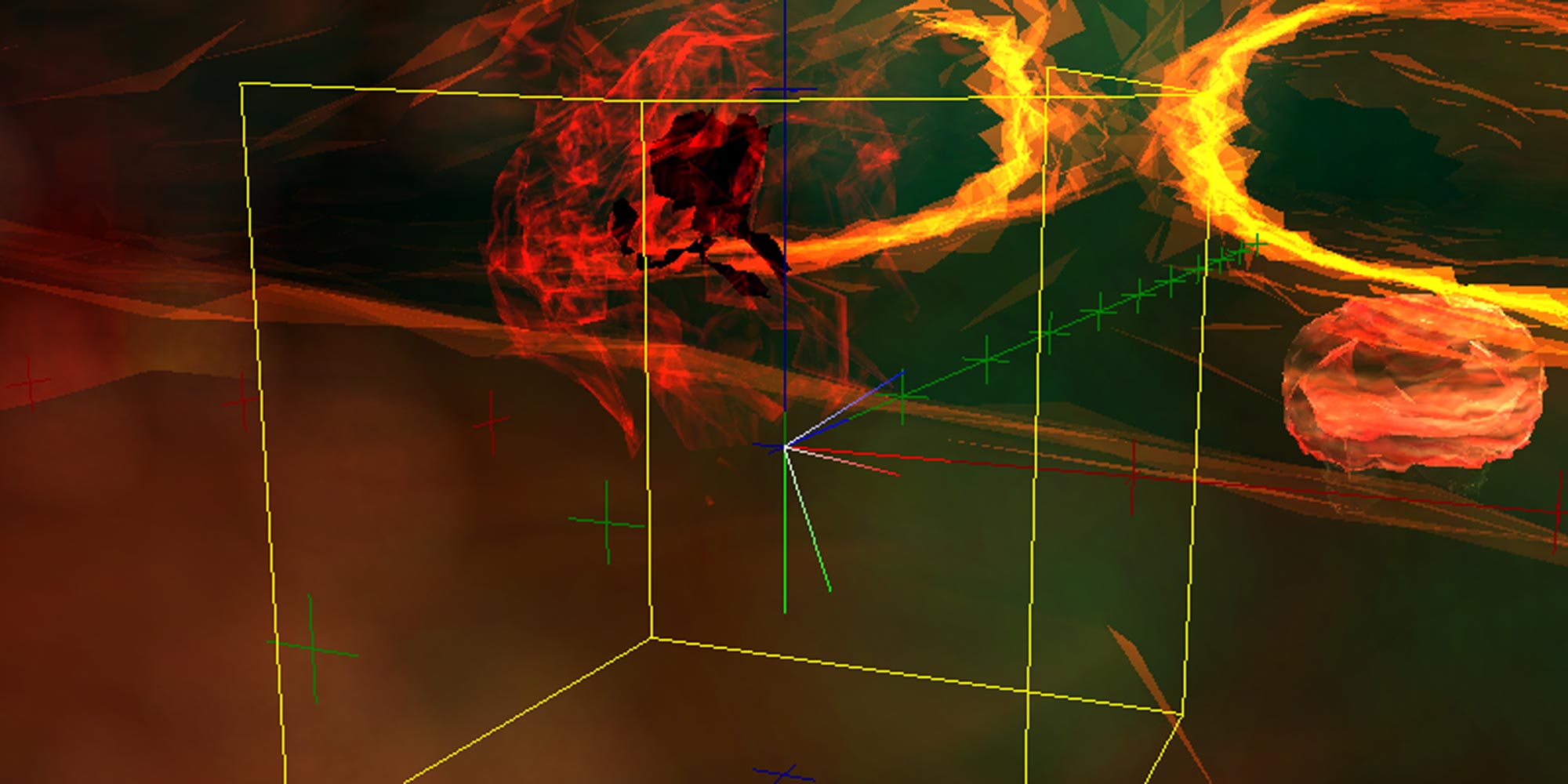

Darüber hinaus haben wir mit dem VRizer die klassische Inszenierung auf der Opernbühne bei der Uraufführung der Wagner Oper Das Rheingold 2004 durch eine virtuelle Kulisse ersetzt.

Die stereoskopischen Projektionen, die wir mit dem VRizer realisieren konnten, erzeugten an den Wänden des Bühnenbereichs ein Panorama, das die Dimensionen des Konzertsaals in den virtuellen Raum erweiterte. Die computergesteuerte Kulisse folgte den Klängen der musikalischen Interpretation und spiegelte diese in einer Art dynamischer Struktur wider. Um dieses – ziemliche beeindruckende – Ergebnis zu erreichen, musste die Oper zuvor von einem digitalen System analysiert und interpretiert werden. Die Bilder wurden daraufhin in Echtzeit und inspiriert durch die Musik moduliert.

Mit SAP – einem Unternehmen, das abstrakte Geschäftsprozesse konfiguriert und ihnen einen organisatorischen Rahmen gibt – haben wir 2007 ein digitales Leitsystem namens Quell.Code entwickelt. Alltägliche und wenige alltägliche Prozesse, die in der Struktur des Unternehmens tatsächlich stattfinden, wurden dafür digital visualisiert:

100 Screens, die mit 30 verschieden Rechnern verknüpft und zentral mit virtuellem Content bespielt wurden, stellten auf eine sehr spielerische Art und Weise Visualisierungen systemischer Prozesse innerhalb des Unternehmens dar und bildeten so ein interaktives Besucherleitsystem, das durch das SAP Hauptquartier in Walldorf führt. Die Visualisierung – in einem virtuellen Flusslauf wandernde Prozesstierchen –, sollten alltägliche Abläufe innerhalb der Unternehmensstruktur, wie zum Beispiel das Schreiben von Emails – illustrieren und administrativen Prozessen so wahrnehmbar machen und einen künstlerischen Ausdruck verleihen. Der VRizer wurde in diesem Fall eingesetzt, um eine authentisch wirkende Perspektive für jeden einzelnen dieser Screens zu berechnen.

Was genau ist nun der VRizer?

Florian Berger: Der VRizer, diese im Ars Electronica Futurelab entwickelte 3D-Visualisierungssoftware, hat damals die neueste Technologie für eine grafische Darstellung von Daten verwendet und damit neue Maßstäbe im Bereich der Echtzeit-Computergrafik gesetzt. Doch um diese Frage wirklich zu beantworten, muss ich ein wenig ausholen:

2004, als wir den VRizer entwickelt haben, war der Einsatz von Game-Engines die am weitesten verbreitete Methode zur Erstellung von PC-basierten, interaktiven Echtzeitanwendungen. Zahlreiche Spiele wurden bereits serienmäßig mit leistungsfähigen Editoren ausgestattet und boten damit einem breiten Anwenderspektrum die Möglichkeit, dessen eigene Vorstellungen einer dreidimensionalen Umgebung zu realisieren. Mit Hilfe von Game-Editoren konnte man damit mit geringem Aufwand hochkomplexe, effektvolle und dramatische Umgebungen mit einem Minimum an Aufwand erstellen.

Mit der Entwicklung des VRizer ist das Ars Electronica Futurelab aber noch einen entscheidenden Schritt weiter gegangen und hat damit die Lücke zwischen Anwendungen auf Basis von Game-Engines und dem PC-Cluster-System ARSBOX geschlossen: Mit dieser Software haben wir also eine Bibliothek zur Verfügung gestellt, die dazu in der Lage ist, jede beliebige OpenGL-Software als Basis für die Umsetzung stereoskopischer VR-Projektionen zu nutzen – ohne, dass der von uns entwickelte Quellcode in den Originalcode der Software eingreifen muss – um mehrere Ansichten aus verschiedenen Perspektiven der gleichen Szene aus einer kontinuierlichen Abfolge von Bildern zu erhalten.

In der Kunstszene war zu dieser Zeit die am weitesten verbreitete Engine „Unreal Tournament 2003“, was diese auch zur naheliegenden Komponente für die ersten „VRizer“-Anwendungen machte. Neben den künstlerischen Arbeiten modifizieren die Mitarbeiter*innen des Ars Electronica Futurelab auch Game-Editor-basierte Architektur-Visualisierungssoftware und Computergames – zwei miteinander eng verwandte Programmtypen – für die immersiven virtuellen Umgebungen des VRizer. Die ersten Beispiele wurden erstmals beim Ars Electronica Festival 2003 öffentlich präsentiert: CODE – The Language of our Time.

Da Game Engines im Allgemeinen über sehr lange Release Zyklen verfügen, waren häufig neue Hardware Features in diesen Engines (noch) nicht zugänglich. Ein logischer Schritt war es daher, eine eigene Engine zu entwickeln, die Zugang zu den aktuellsten Hardware Features, wie zum Beispiel Vertex- und Pixel Shader ermöglicht: Die FL-Engine wurde unter Verwendung von OpenGL von uns dafür entwickelt.

Des Weiteren war die Entwicklung der FL-Engine ein notweniger Schritt, um eine moderne Hardware fachgerecht nutzen zu können; herkömmliche Game Engines waren zu dieser Zeit noch nicht dafür konzipiert. Für die Umsetzung der Idee zur FL-Engine haben wir die neuesten Features der Software Open GL genutzt und neue Plug-Ins geschrieben, weil wir einfach ein adäquates System für unsere moderne Herangehensweise an das Programmieren benötigten.

Aus einem Mono-Frame-Stream können damit also Stereo-Projektionen erzeugt werden. Wie geht das?

Florian Berger: Magie ist das natürlich nicht. Der VRizer ist auf auf Basis von OpenGL entwickelt worden. Tatsächlich basiert die Geometrie, die unter der Verwendung dieser 3D-Software entsteht, auf einer dreidimensionalen Darstellung, bevor sie verpixelt und auf den Bildschirm gezeichnet wird. Die Bilder, die dafür verwendet werden, sind Computergrafiken, die sich über dreieckige Formen definieren.

Man kann also prinzipiell die Ansichtspunkte und andere Parameter Frame für Frame ändern. Im einfachsten Fall kann man sich vorstellen, die gleiche Szene einmal aus der Perspektive des linken Auges und im nächsten Frame aus der Perspektive des rechten Auges darzustellen. Dies würde natürlich Shutter-Brillen erfordern, die durch Frame-Schalter ausgelöst werden.

Eine andere mögliche Methode ist es, den Frame für das linke Auge nur in Rot und den folgenden Frame für das rechte Auge in Grün oder Blau (oder beidem) zu rendern und diese zu einem einzigen Frame zu kombinieren. Wenn wir dann eine Rot-Grün-Brille tragen, erhalten wir auf eine sehr einfache Art und Weise die stereoskopische Ansicht aus der Abfolge monoskopischer Frames.

Wohin geht aus heutiger Sicht die Zukunft virtueller Welten?

Florian Berger: Die Entwicklung wird in Richtung Vereinheitlichung der vielen bestehenden virtuellen Plattformen gehen. Viele Möglichkeiten für high-end Rendering bieten sich heute schon auf einfachste Weise im Web-Browser an, zum Beispiel als WebVR und WebXR. Es ist daher der nächste logische Schritt, auch diese Technologien im großen Stil für VR-Anwendungen zu nutzen. Dies führt letztlich zu einer Vereinheitlichung – nicht nur was VR-Software betrifft, sondern auch hardware- und betriebssystemübergreifend.

Mit der Entwicklung von Deep Virtual hat das Ars Electronica Futurelab anlässlich der Produktion von sieben Episoden für die 25th Anniversary Serie auf Ars Electronica Home Delivery erst kürzlich ein völlig neues VR-System geschaffen, das die Illusion eines virtuellen Raumes wieder um einen entscheidenden Schritt weiterbringt. Deep Virtual ist das Konzept für ein Deep Space Format, das im Laufe der nächsten sieben Episoden Schritt für Schritt entwickelt wird. Es wird die Protagonist*innen im Deep Space 8K in eine eindrucksvolle Kulisse versetzen, die der Präsentation, den Talks und Diskussionen einen angemessenen Rahmen verleiht. Deep Virtual ist als immersives und hybrides Medienformat konzipiert, das dem Zuschauer ein gemeinsames Eintauchen in virtuelle Welten erlauben soll und darüber hinaus einen Schritt in die Zukunft des Deep Space 8K bedeutet.

Florian Berger studierte Theoretische Physik an der JKU Linz und arbeitet seit 2001 im Ars Electronica Futurelab. Seine angewandte Forschung konzentrierte sich zu dieser Zeit auf Echtzeit-Computergrafik, Simulation, Signalverarbeitung und eingebettete Systeme. Als Teil des kreativen Kernteams des Ars Electronica Futurelab war er für die Entwicklung einer flexiblen, modularen High-End-Grafik-Engine verantwortlich, die für mehrere groß angelegte stereoskopische Musikvisualisierungen von Konzerten verwendet wurde. Er ist einer der bedeutendsten Forscher auf dem Gebiet der virtuellen Realität und Echtzeit-Computergrafik und war in jüngster Zeit unter anderem Chef-SW-Ingenieur des Spaxels-Teams. Das Ars Electronica Futurelab hat Florian Berger als angesehener VR-Ingenieur und kreativer Denker maßgeblich mitgestaltet. An der FH Salzburg unterrichtet er Echtzeit-Computergrafik und betreut Diplomarbeiten für Masterstudent*innen.

Erfahren Sie mehr über Florian Berger auf der Website des Ars Electronica Futurelab oder abonnieren Sie den Ars Electronica Home Delivery Channel und machen Sie sich einen Eindruck von Deep Virtual im 25th Anniversary Programm des Ars Electronica Futurelab. Erforschen Sie Virtual Worlds in Episode One oder den poetischen Moment in Systemen, in der zweiten Episode ebenda.

Noch sechs weitere Episoden werden sich in Folge mit spannenden Themen rund um die Vergangenheit, Gegenwart und Zukunft des Ars Electronica Futurelab befassen und aus der Aufarbeitung der vergangenen 25 Jahre dem Blick in Zukunft mit den Inhalten Creative (Artificial) Intelligence, Robots & Robotinity, Computation & Beyond, Swarms & Bots und Art Thinking eine zukunftsweisende Dimension verleihen.