Es ist ein ungewöhnliches Gefühl, wenn man sich Ali Nikrangs „Style Video“ im Deep Space 8K ansieht: Ganz so, also ob man mitten in einem Gemälde von Roy Lichtenstein oder Wassily Kandinsky stehen würde. Das stereoskopische Video basiert auf einer Aufnahme einer Abfahrt auf der Streif in Kitzbühel, einer der berühmtesten Pisten der Welt. Dank künstlicher Intelligenz sieht die wilde Fahrt nun so aus, als wäre sie gemalt.

Wie das genau funktioniert, hat uns der Researcher und Artist Ali Nikrang vom Ars Electronica Futurelab im Interview verraten. Am Ars Electronica Festival (6 – 10 September 2018) kann man die Arbeit und weitere Diskussionen und Beispiele zum Thema Deep Learning bei „Creative AI – Style Transfer“ im Deep Space 8K im Ars Electronica Center schließlich auch selbst erleben.

Credit: Ali Nikrang

Ali, was versteckt sich hinter dem Titel „Creative AI – Style Transfer“?

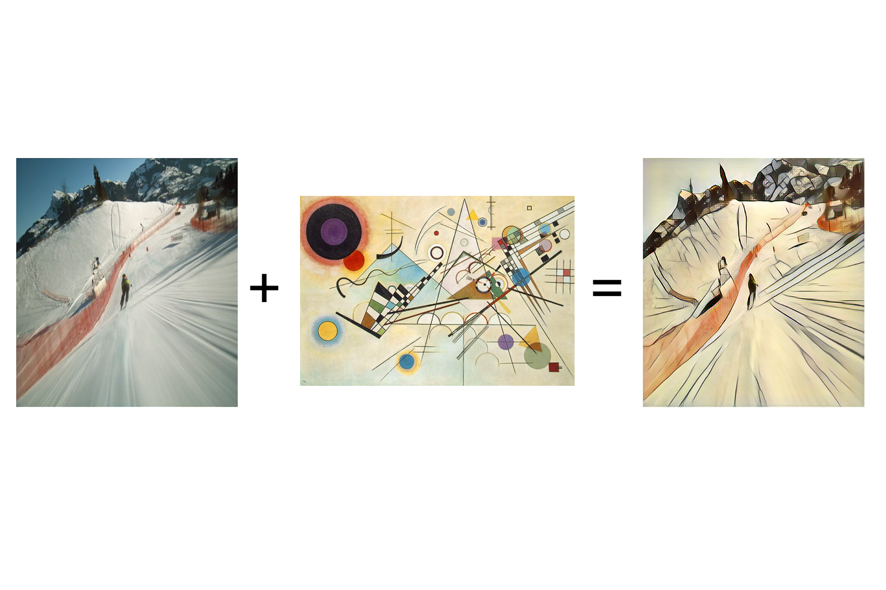

Ali Nikrang: Es geht in unserer Präsentation im Deep Space 8K hauptsächlich um ein Video, das versucht, den Stil von einem Gemälde oder Bild nachzuahmen. Bei diesem Projekt wird ein stereoskopisches Video von der Streif in Kitzbühel verwendet, welche zu den schwierigsten und gefährlichsten Abfahrtspisten der Welt zählt. Mittels einer Technik aus dem Bereich Deep Learning namens Style Transfer tauchen wir in die Formen und Farben von Künstlern wie Kandinsky oder Lichtenstein ein und lassen die Streif als ein dreidimensionales Gemälde im Deep Space 8K erscheinen. Das Besondere daran ist, dass man denkt, man ist mitten in einem Gemälde, und zwar in Stereo, also 3D – obwohl die eigentlichen Bilder ja nicht stereoskopisch waren.

Gibt es bestimmte Stile, die sich besonders für einen solchen Style Transfer eignen?

Ali Nikrang: Ja, die gibt es. Interessanterweise ist es so: Je realistischer ein Stil ist, desto schlechter funktioniert es. Das heißt, wenn man zum Beispiel ein Gemälde von Da Vinci nimmt oder von fotorealistischen Malern und Malerinnen, ist es schwieriger. Wir haben für das Projekt wirklich sehr viel ausprobiert, auch Fotos, und manchmal bringt das auch interessante Ergebnisse. Aber für uns ist es nicht genug, wenn ein Frame gut aussieht, wir wollen natürlich, dass das gesamte Video gut ist. Wir haben schließlich drei Stile gefunden, die sehr geeignet waren, teilten das Video von der Streif in drei Teile und lassen es so durchlaufen. Vollständigkeitshalber muss man sagen, dass es auch Modelle gibt, die für fotorealistischen Styles konzipiert worden sind, um zum Beispiel den Style von einem Foto mit dem Inhalt eines anderen Fotos zu kombinieren, unser Ziel war aber, ein eher abstraktes und malerisches Ergebnis zu generieren.

Credit: Ali Nikrang

Woran liegt das, dass realistischere Bilder nicht so gut funktionieren?

Ali Nikrang: Das hat mit der Natur dieser Technik zu tun. Hier kommen wir jetzt also dazu, wie das eigentlich funktioniert! Wie gesagt kommt Style Transfer aus dem Deep Learning, einem Forschungsfeld der künstlichen Intelligenz. Deep Learning wird in vielen verschiedenen Bereichen eingesetzt, ein ganz wichtiger dabei ist die visuelle Wahrnehmung der Welt. Im Prinzip geht es darum, Computer dazu zu bringen, Objekte in der realen Welt zu erkennen und als solche wahrzunehmen. Dafür müssen sie die Merkmale der visuellen Welt verstehen oder erkennen. Was macht zum Beispiel eine Katze aus?

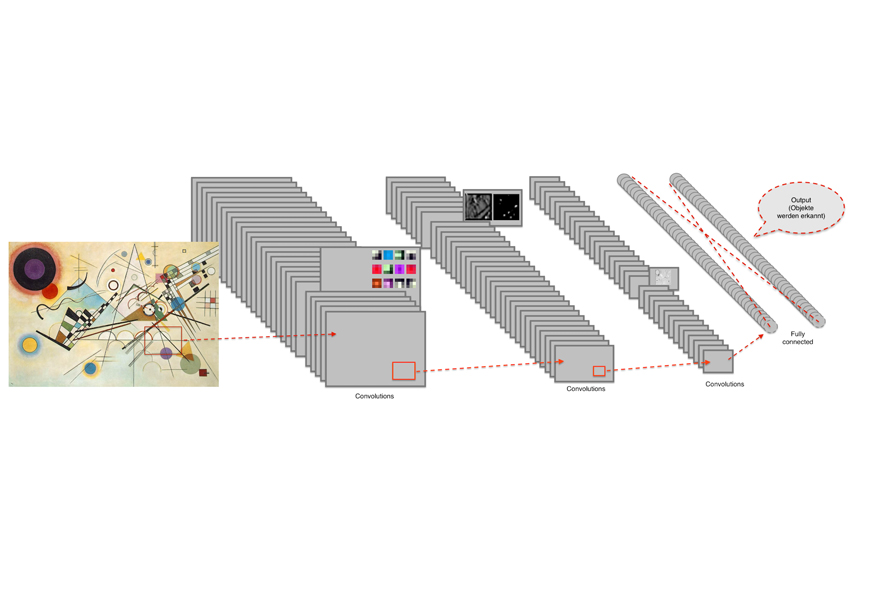

Der Computer sieht eine Katze als eine Kombination von Pixeln. Aus den Pixeln muss er verschiedene Merkmale erkennen, es gibt bestimmte Formen für die Ohren, bestimmte Farben, er muss zwei Augen sehen und so weiter. Er kann also nicht mehr nur in Pixelebene denken, sondern muss verschiedene Merkmale zusammensetzen können. Dafür werden verschiedene Schichten beim Lernen dieser Merkmale benützt, daher kommt der Name Deep Learning – weil es mehrere Schichten beim Lernen sind. Die ersten Schichten lernen sehr primitive Merkmale wie Kurven, gerade Linien, Farben, hier geht es wirklich um eine Gruppe von einigen wenigen Pixel. Je tiefer man geht, desto mehr kombinieren sich diese Schichten, bis man am Schluss eine große Kombination von verschiedenen Schichten hat.

Style Transfer ist ein Nebenprodukt dieser Technik, wo man versucht, aus zwei Bildern ein drittes Bild zu generieren, welches die typischen Merkmale von einem Bild in das zweite überträgt.

Es ist also eine Mischung aus diesen beiden Bildern oder Stilen.

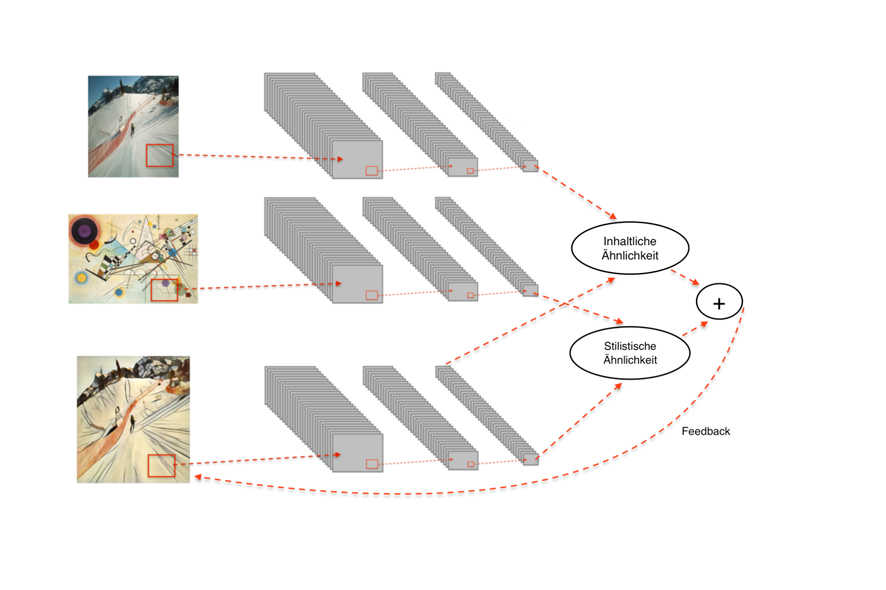

Ali Nikrang: Genau, man hat zwei Bilder als Input, ein Style Bild und ein Content Bild. Daraus möchte man ein drittes Bild generieren, dass die typischen Merkmale vom Style Bild in das Content Bild einfügt. Es sollte klar als Content Bild erkennbar bleiben, aber die typischen Merkmale vom Style Bild zeigen. Wie macht man das also? Hier kommt eine Technik aus dem Bereich Deep Learning ins Spiel, ein sogenanntes Convolutional Deep Neural Network. Die typischen Merkmale eines Style Bilds kann man in den mittleren Schichten eines solchen Netzwerkes sehen. Man könnte das so interpretieren wie Pinselstriche eines Künstlers oder einer Künstlerin. Diese mittleren Schichten kombiniert man dann mit den letzten Schichten des Content Bilds, wo sehr abstrakte Informationen über die Struktur des Bildes versteckt sind. Damit maximiert man die Ähnlichkeit des Ergebnisses zur letzten Schicht vom Content Bild und zu den mittleren Schichten des Style Bildes.

Wie lernt der Computer, diese Merkmale richtig zu identifizieren?

Ali Nikrang: Dabei wird der Rechner mit einer Sammlung von rund 1,2 Millionen Bildern trainiert. Er muss lernen, 1000 Objekte des alltäglichen Lebens in diesen Bildern zu erkennen. Man zeigt also zum Beispiel das Bild einer Katze und lässt den Computer die Katze identifizieren. Am Anfang wird irgendein Ergebnis herauskommen – weil die Antwort aber bekannt ist, kommt das Feedback „falsche Antwort“. So wird zurückgegangen und herausgefunden, welche Parameter oder welche Filter zum falschen Ergebnis geführt haben, bis der Computer nach Tausenden von Bildern schließlich eine Katze auch als solche erkennt.

Dieses Feedback passiert automatisch?

Ali Nikrang: Ja. Weil die Trainingsphase eines solchen Modells jedoch sehr rechenintensiv sein kann, kann man es auch von Firmen wie Google oder Forschungsinstituten fertigtrainiert herunterladen. Diese Firmen haben sehr große Rechenzentren, aber sogar sie müssen bei manchen Modellen wochenlang trainieren. Wenn man das Modell dann herunterlädt, muss es nicht mehr mit den Ausgangsbildern arbeiten. Das Netzwerk hat die typischen Merkmale der visuellen Welt gelernt, man kann es dann aber noch mit eigenen Bildern vervollständigen. Natürlich erkennt es nur die Objekte, die gelernt wurden – wenn es zum Beispiel eine Klasse „Katze“ gibt, aber keine Kategorie „Tiger“, wird der Computer wahrscheinlich einen Tiger als Katze einordnen. Das Tolle an dem Modell ist aber, dass man nicht das ganze Netzwerk trainieren muss – man kann es also herunterladen und eine eigene Schicht dazugeben, die nur lernt, zwischen Katzen und Tigern zu unterscheiden. Das schafft man auch mit einem normalen Computer.

Wie verwendet ihr das Neural Network für Style Transfer?

Ali Nikrang: Beim Style Transfer müssen wir natürlich auch kalkulieren und berechnen, aber die Aufgabenstellung ist nicht, Objekte zu klassifizieren. Bei einem Style Transfer gibt es drei Netzwerke, eines zum Style Bild, eines zum Content Bild, und ein drittes für das Ergebnisbild. Das Ergebnisbild ist am Anfang nur Noise, im Laufe der Berechnung wird es dann optimiert, sodass dessen Netzwerk möglichst viele Ähnlichkeiten mit den mittleren Schichten des Style Bildes und den letzten Schichten des Content Bildes aufweist.

Wie lange dauert es, bis ein ganzes Style Video entsteht?

Ali Nikrang: Das hängt davon ab, welches Modell man nimmt. Es gibt verschiedene Möglichkeiten in der Forschung, manche funktionieren schneller, manche langsamer. Es geht von mehreren Stunden bis zu mehreren Tagen, ganz nach Modell.

Ein Problem, das wir bei diesem Projekt hatten, war, dass der Style Transfer besser funktioniert, wenn wir das Video zuerst ein bisschen herunterskalieren. Wir wollen das Ergebnis im Deep Space 8K zeigen, auch das ist ein bisschen problematisch, weil man dafür eine sehr hohe Auflösung braucht. Wir haben also schließlich ein anderes Modell aus dem Bereich der künstlichen Intelligenz benützt, dessen Aufgabe es ist, Bilder in einer realistischen Weise hoch zu skalieren. Es ist also nicht so wie bei normalen visuellen Programmen, dass die Pixel interpoliert werden, sondern es wird in diesem Fall wirklich intelligent überlegt, wie man die Auflösung erhöhen kann, sodass das Bild so realistisch wie möglich aussieht.

Beim Ars Electronica Festival zeigst du die Ergebnisse. Was erwartet uns also genau?

Ali Nikrang: Beim Festival werden wir uns das Original-Video ansehen und kurz darüber sprechen, wie das überhaupt funktioniert. Es soll auch darum gehen, wo diese Technik hingeht – das hört ja nicht beim Style Transfer auf. Eine neue Aufgabenstellung wäre zum Beispiel, die typischen Merkmale vom Sommer in den Winter umzuwandeln. Dazu werde ich auch ein Beispiel zeigen, bei dem die technische Aufgabenstellung sehr ähnlich ist. Hier muss der Rechner eben erkennen: Was macht den Sommer zum Sommer? Und was macht den Winter zum Winter? Die Präsentation wird sicherlich für alle interessant sein, die sich für Neural Networks und Deep Learning interessieren. Es sind nicht nur fertige Werke dabei, wir diskutieren auch über die Möglichkeiten, denn wir sind nicht am Ende der Geschichte. Es wird hier viel geforscht, es werden sicher neue Ergebnisse erscheinen und die Modelle verbessern sich monatlich.

Ali Nikrang ist Senior Researcher & Artist im Ars Electronica Futurelab, wo er Mitglied der Forschungsgruppe Virtual Environments ist. Er studierte Computer Science an der Johannes Kepler Universität Linz und klassische Musik an der Universität Mozarteum Salzburg. Bevor er 2011 zu Ars Electronica wechselte, arbeitete er als Researcher beim Austrian Research Institut for Artificial Intelligence, wo er Erfahrungen im Bereich Serious Games und simulierte Welten sammelte.

„Creative AI – Style Transfer“ wird beim Ars Electronica Festival von 6. bis 10. September 2018 im Deep Space 8K im Ars Electronica Center gezeigt. Mehr erfahren Sie in Kürze auf unserer Webseite.

Um mehr über Ars Electronica zu erfahren, folgen Sie uns auf Facebook, Twitter, Instagram und Co., abonnieren Sie unseren Newsletter und informieren Sie sich auf https://ars.electronica.art/.