Mit Ricercar hat Ali Nikrang, Key Researcher und Artist im Ars Electronica Futurelab, im Rahmen seiner Forschungstätigkeit zum Thema “Creative Intelligence” eine Künstliche Intelligenz (KI) entwickelt, die, trainiert mit 25.000 Musikstücken, selbständig komponieren kann. Nach der systematischen Auswertung musikalischer Strukturen kommt sie zu erstaunlich natürlich und emotional klingenden Ergebnissen. Wie das möglich ist?

Ali Nikrang, über seine Forschung zum Thema künstliche Intelligenz und Musik, sowie deren (De-)Mystifizierung, Grenzen und Möglichkeiten:

Wie komponiert man eigentlich Musik mit Hilfe künstlicher Intelligenz?

Ali Nikrang: Mit MuseNet hatte ich eine Anwendung zur Verfügung, die – meiner Meinung nach zum ersten Mal – dazu in der Lage war, Musik von solch hoher Qualität zu komponieren, dass es schwer fiel zu sagen, ob das Musikstück von einem KI-System oder einem*r menschlichen Komponist*in geschrieben wurde.

Das Projekt Mahler Unfinished, das beim Ars Electronica Festival 2019 realisiert wurde, war nur eines unserer Projekte, mit dem Ziel herauszufinden, was ein gutes KI- Musikkompositionssystem mit dem Thema dieser Sinfonie machen kann, welches außergewöhnlich ist. Es beginnt mit nur einer Stimme und selbst die Tonalität ist am Anfang nicht völlig klar. Mit anderen Worten: Es kann als Herausforderung für jedes KI-System angesehen werden.

Ein natürliches und emotionales Stück basierend auf dem Thema der Sinfonie Mahler´s Unvollendete, mit MuseNet zu komponieren, war 2019 für mich der Beweis dafür, dass neue Technologien, wie “transformers” oder “attention mechanisms”, welche hauptsächlich im Bereich NLP (natural language processing) benutzt werden, erfolgreich zur Komposition von Musik eingesetzt werden können. Um das weiter zu untersuchen, entwickelte ich daraufhin mein eigenes KI-basiertes Musikkompositionssystem Ricercar, das mehrere Neuerungen und Weiterentwicklungen im Bereich KI-basierter Musikkomposition zur Verfügung stellt.

Ricercar (ricercare, italienisch “nach etwas oder jemanden suchen”) besitzt eine andere Architektur als MuseNet. Das ist aus technologischer Sicht interessant, weil wir daraus ableiten können, dass die Architektur des Systems per se gar nicht so entscheidend ist. Wenn wir ein Modell haben, das dazu in der Lage ist, die statistischen Beziehungen und Abhängigkeiten von Daten über einen langen Zeitraum in einem Musikstück zu lernen, haben wir bereits die beste Voraussetzung für KI-basiertes Komponieren von Musik.

Ich habe mehrere neue Ansätze für Ricercar entwickelt, darunter auch Ideen dafür, unter einer neuen Verwendung symbolischer musikalischer Daten, Musik auf eine Art und Weise darzustellen, die weniger Ressourcen benötigt. Mein Schwerpunkt lag auch darauf, das System für wiederkehrende Strukturen in der Musik (wie Melodien) zu sensibilisieren, die während des Stücks immer wieder mit und ohne Variationen auftreten.

Ricercar ist damit dazu in der Lage, sich während des Stücks auf zwei oder drei Themen zu konzentrieren. Das entspricht eher der Art und Weise, wie menschliche Komponist*innen tatsächlich Musik komponieren. Üblicherweise haben wir nicht mehr als zwei oder drei Themen in einem Stück. Der Rest sind Variationen und Wiederholungen mit ähnlichen Strukturen.

Den Fokus eines KI-Systems auf zwei oder drei Themen zu legen, war bisher schwierig. Das hat mit der Art und Weise zu tun, wie die KI gelernt hat, Musik zu komponieren. Alles, was sie während des Trainings lernt, ist nämlich die Fähigkeit, unter Berücksichtigung aller vorherigen Noten die nächste Note vorauszusagen. Wenn die KI in dieser Art trainiert wird, neigt sie dazu, eine Art flache Struktur für ihre Kompositionen zu nutzen, immer wieder neue Strukturen und Themen einzubringen und wenig auf die hierarchischen musikalischen Strukturen zu achten. Sie ist dann zum Beispiel nicht in der Lage, eine ganze Sequenz zu wiederholen, die am Anfang des Stücks als Hauptmotiv vorgekommen ist. Wir brauchen daher spezielle technische Mechanismen, um das Modell dazu zu bringen, sich auf einzelne Strukturen in einem Musikstück zu konzentrieren.

Was macht uns künftig noch einzigartig? Welche Rolle spielt der Mensch in der Interaktion mit der KI?

Ali Nikrang: Die Zukunft der KI-basierten Musikkomposition liegt in Zusammenarbeit mit dem Menschen, denn es kann keine Kunst ohne menschliche Beteiligung geben. Kunst entsteht durch die Intention und es gibt keine Schöpfung ohne Absicht.

Selbst wenn wir uns die allerersten Höhlenmalereien der Menschheitsgeschichte ansehen, können wir diese Absicht finden, etwas zu zeichnen und es auf diese Weise mit der Gesellschaft zu teilen. Für die Kunst ist dieser intentionale Zugang von noch viel größerer Bedeutung.

KI-Systeme wie Ricercar oder MuseNet entwickeln ihre eigene, auf statistischen Mustern basierte Sichtweise auf Daten. Während des Trainings werden sie sozusagen gezwungen, eine Art essenzielles Verständnis für Musik zu erlernen, damit sie danach im Stande sind, Daten zu generieren, die denen im Trainings-Set ähneln. Das heißt, Musik zu komponieren, die menschlich, natürlich und emotional klingt.

Ich denke, der Ansatz der KI, sich die Daten anzueignen, könnte auch für den Menschen interessant sein und ich bin mir sicher, dass Künstler*innen auch diese Technologie für die Entwicklung völlig neuer Perspektiven und Formen der Kunst nutzen werden, die aus heutiger Sicht vielleicht noch nicht vorstellbar sind.

Es wäre nicht das erste Mal in der Geschichte der Musik, dass eine Technologie dabei hilft, unsere eigenen Möglichkeiten zu erweitern. Das Klavier selbst war eine Erfindung des 18. Jahrhunderts und auch die erste Flöte, die mindestens vor 35.000 Jahren gebaut wurde, war eine Innovation. Denn vor dieser Zeit war der Gesang die einzige Möglichkeit, Musik zu produzieren. Doch nur durch die Kollaboration wird es möglich sein, die Vorteile der Technologie auch für sich zu nutzen.

Kann künstliche Intelligenz auch dabei helfen, Kunst zu machen? Was können Komponist*innen durch die KI über Musik lernen?

Ali Nikrang: Tatsächlich sind künstliche, neuronale Netze heute dazu in der Lage, mit einer großen Datenmenge trainiert zu werden und lernen dabei sehr oft auch Abhängigkeiten und Beziehungen in den Daten, die menschliche Künstler*innen vielleicht nicht bewusst wahrgenommen hätten.

Und so könnten solche Systeme tatsächlich als eine neue Inspirationsquelle für Künstler*innen dienen. Eine andere Anwendung könnte es sein, damit in naher Zukunft jeder Person die Möglichkeit zu eröffnen, Musik zu komponieren, ohne sich zuvor Jahre lang theoretisch damit beschäftigt zu haben. Der Prozess des Komponierens könnte sich damit viel intuitiver gestalten, als das derzeit der Fall ist.

Ein Modell, das dazu in der Lage ist, KI-basierte Kompositionen zu erzeugen, muss also ein fundamentales Verständnis für Musik erlernt haben, das auf Stücken basiert, mit denen es trainiert wurde. Wenn wir dieses Modell untersuchen, könnten wir tatsächlich auch etwas über die Musik selbst lernen. Das ist ein einfaches Prinzip und vielleicht ist das sogar wichtiger als der Prozess des Komponierens an sich. Wir benutzen die Komposition lediglich als eine Art Aufgabe, um dem KI-Model etwas über Musik beizubringen. Ein fertig trainiertes KI-Model hat möglicherweise etwas über die Musik gelernt, das auch für uns Menschen unbekannt und interessant sein könnte.

Wie wird KI unsere Wahrnehmung von Musik verändern?

Ali Nikrang: KI kann tatsächlich unsere Wahrnehmung von Musik verändern. Im Moment sehen wir sie als eine Reihe von Stücken. Von Beethoven, Mozart oder anderen Komponisten, aber auch aus dem Bereich der Popmusik.

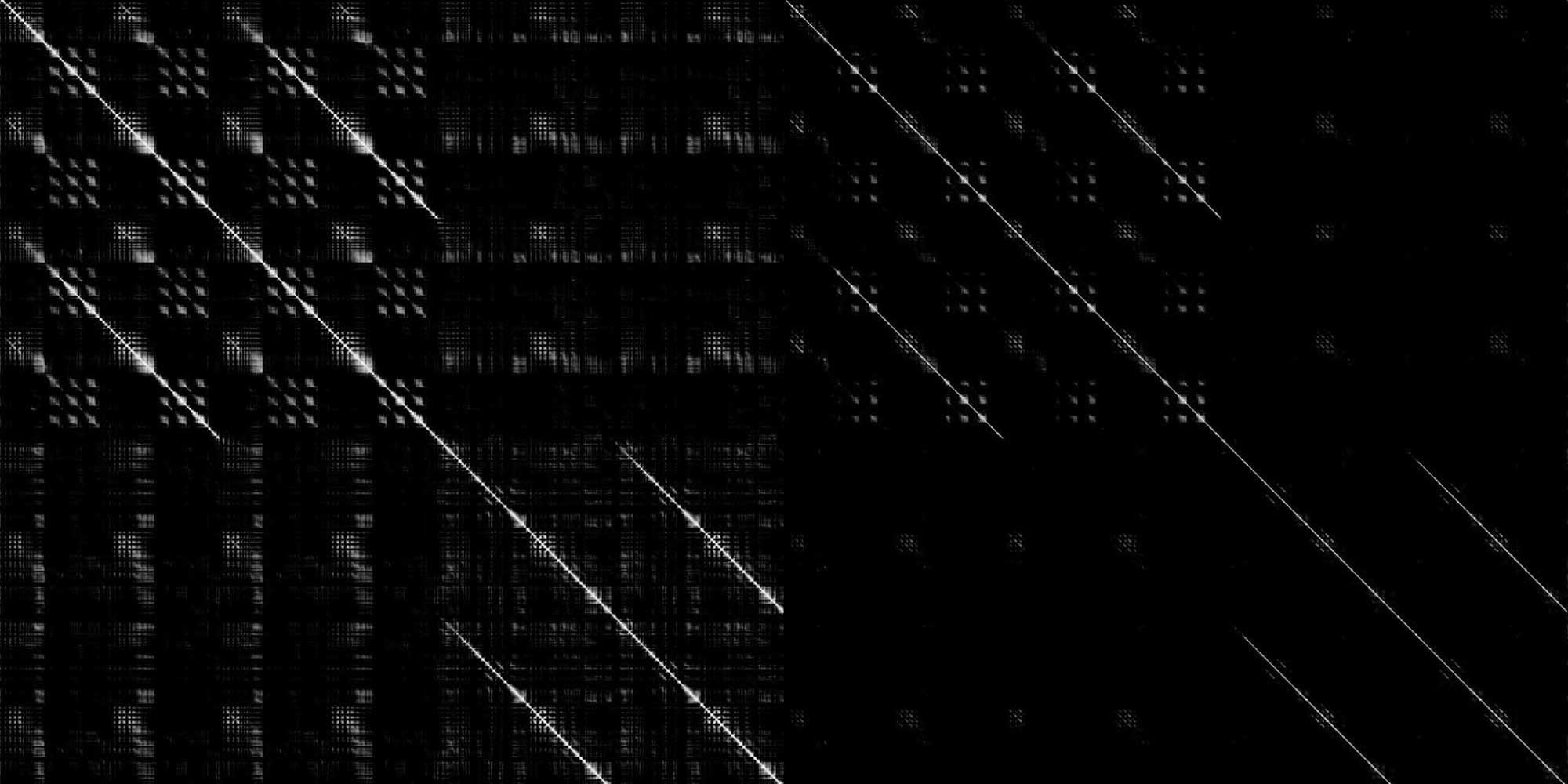

KI könnte eine neue Perspektive schaffen. Wenn ein KI-System mit musikalischen Daten trainiert wird, lernt es, diese musikalischen Daten „intern“ zu repräsentieren. Die sogenannten „weights and bias“, die während des Trainings gelernt und in Form von Vektoren gespeichert werden, ermöglichen es dem Modell, die musikalischen Daten intern zu repräsentieren. Danach ändert sich das Modell nicht mehr. Mit anderen Worten: Das Ergebnis des Trainings ist eine große Anzahl an Vektoren, die alles, was das Modell aus den Daten gelernt hat, dauerhaft speichern.

Das Modell nutzt diese innere Darstellung, um jede musikalische Idee und jede musikalische Struktur zu verarbeiten. Man kann sich das auch räumlich vorstellen: Jede musikalische Idee bekommt eine Position, einen Platz in einem imaginären multidimensionalen Raum. Ähnliche musikalische Ideen wären dort natürlich nahe beieinander, während Ideen, die sehr unterschiedlich sind, sich weit voneinander entfernt befinden würden.

Das Komponieren mit einem solchen Modell (wie Ricercar) kann daher auch als Navigation in diesem Raum betrachtet werden. Man wechselt ständig von einem musikalischen Zustand in einen anderen und probiert so verschiedene Möglichkeiten aus.

Das bedeutet aber auch, dass man sich das gesamte musikalische Repertoire auch als eine Art imaginären Raum vorstellen kann. Jede*r Komponist*in hätte hier einen Platz oder eine Position. Man kann sich die Musik eines*r Komponist*in fast als eine Insel in diesem Raum vorstellen. Das System kann neue Stücke generieren, die zum Stil des*r jeweiligen Komponist*in passen oder sogar den Stil eines bestimmten Stückes imitieren. Es ist eine neue Art, Musik zu erleben, die nicht auf einzelnen Stücken und Kompositionen basiert, sondern auf unserer eigenen Wahrnehmung und unseren eigenen Emotionen. Das ist etwas, was heute zwar noch nicht vollständig möglich ist, aber es ist ein mögliches Szenario für zukünftige Systeme.

Das bedeutet, auch Musik wird dadurch dem Trend zur Personalisierung unterworfen. Werden Algorithmen damit auch unseren Musikgeschmack beeinflussen, vielleicht sogar einengen?

Ali Nikrang: Das ist eine sehr gute Frage. Es hängt natürlich davon ab, wie diese Systeme gebaut und angewendet werden. Eine langfristige Beeinflussung unseres Musikgeschmacks durch KI wäre aber realistisch, genauso wie die Fortschritte im Bereich der elektronischen Musik in den letzten Jahrzehnten unseren Geschmack für Musik verändert und zu vollkommen neuen musikalischen Formen geführt haben.

Künstliche Intelligenz wird kreativ und selbst für Künstler*innen scheint das – entgegen vielen Befürchtungen – positive Entwicklungen zu begünstigen. Wie sollte man deiner Meinung nach reagieren?

Ali Nikrang: Aus technologischer und ökonomischer Sicht ist es natürlich sehr interessant, auf diese bequeme Weise Musik zu machen, einfach auf Knopfdruck. Doch das ist nur der technologische und ökonomische Gesichtspunkt.

Aus künstlerischer Sicht wird es immer notwendig bleiben, als Mensch mit der Technologie zusammen zu arbeiten, denn nur so können wir Ergebnisse erwarten, die nicht nur musikalisch “richtig” und “korrekt” klingen, sondern auch eine höhere menschliche und persönliche Bedeutung haben. Die KI wird im kreativen Bereich derzeit ausschließlich als Werkzeug benutzt, doch wenn man das kreative Potenzial solcher Systeme bedenkt, wäre es sinnvoll, diese Systeme als eine Art Gegenspieler oder Partner zu sehen. Um dies zu erreichen, müssen jedoch auf technologischer Seite neue Methoden der Kollaboration entwickelt werden, um eine natürliche Kommunikation zwischen Menschen und Maschinen zu ermöglichen. Besonders kreative Anwendungen brauchen kreative Wege der Interaktion und der Kollaboration. Darüber hinaus sind KI-basierte Modelle sehr komplexe Systeme, was es sehr schwierig macht, Wege zu finden, eine zutiefst menschliche Tätigkeit wie das Komponieren von Musik auf natürliche und intuitive Weise in Zusammenarbeit mit einem KI-System durchzuführen. Eine auf Zusammenarbeit basierende KI, insbesondere im kreativen Bereich, ist daher ein sehr wichtiges Forschungsthema, das es ermöglichen könnte, das kreative Potenzial heutiger und zukünftiger KI-Systeme auszuschöpfen.

Erfahren Sie mehr über Ali Nikrang und kreative Intelligenz auf der Website des Ars Electronica Futurelab oder über digitale Daten in Dur und Moll am Ars Electronica Blog

Ali Nikrang ist Key Researcher im Ars Electronica Futurelab. Er hat seinen Background sowohl in Technik als auch in Musik. Er studierte Computer Science an der Johannes Kepler Universität und Musik (Komposition und Klavier) an der Universität Mozarteum in Salzburg. Bevor er 2011 zum Ars Electronica Futurelab kam, arbeitete er als Researcher am österreichischen Forschungsinstitut für künstliche Intelligenz in Wien. Seine Arbeit befasst sich mit der Interaktion zwischen Menschen und KI-Systemen mit Schwerpunkt auf kreativen Anwendungen. Sie umfasst die Untersuchung der kreativen Ergebnisse von KI-Systemen und wie diese durch die Interaktion und Kollaboration mit Menschen gesteuert und personalisiert werden können. Als klassischer Musiker und KI-Forscher war er an zahlreichen Projekten beteiligt, die künstliche Intelligenz und Musik kombinieren. Seine Arbeit wurde in verschiedenen Konferenzen und Ausstellungen weltweit gezeigt und war auch Teil von mehreren TV- und Radiodokumentationen über künstliche Intelligenz und Kreativität.