Was ist noch wahr, wenn Algorithmen bewegte Bilder, Stimmen und Fakten erzeugen? Ein Blick auf Kunst, KI und Verantwortung und auf die Frage, wie wir Wahrheit im Zeitalter des Künstlichen neu verhandeln.

“You’d never assume a piece of text is true just because someone wrote it down. You go investigate the source. Videos used to be different because they were harder to fake. That’s over now.“

www.bbc.com/future/article/20251031-the-number-one-sign-you-might-be-watching-ai-video

Vor kurzem hat ein Video eines Königs für Aufsehen gesorgt – nicht nur in den sozialen Netzen. Ein Präsident eines demokratischen Staates, inszeniert als Monarch, der heroisch gegen seine Feinde kämpft. Hochglanz, Pathos, Propaganda – und komplett künstlich.

Im Jahr 2025 überrascht uns das kaum noch. Dieses Video ist zwar – auch weil der Inhalt absurd ist – noch eindeutig als Fake erkennbar, mit SORA 2, der neuesten Video-KI von OpenAI, kann aber heute jede*r in wenigen Sekunden hyperrealistische Szenen erzeugen. Was früher teure Filmstudios benötigte, entsteht nun auf Knopfdruck – und flutet unsere Feeds mit bewegten Bildern, die täuschend echt wirken, aber nichts mit der Wirklichkeit zu tun haben.

Neu an SORA 2 ist dabei nicht nur die technische Brillanz, sondern ihre soziale Einbettung: Erstmals ist ein KI-Generator nicht mehr ein isoliertes Tool wie DALL·E oder SORA 1, sondern Teil einer Social-Media-Plattform. OpenAI hat SORA 2 bewusst als App mit Chatfunktion, Community-Regeln und öffentlicher Interaktionslogik veröffentlicht – und damit den Schritt von der Produktion zur Distribution von Wahrheit vollzogen. KI ist nicht länger bloß ein Werkzeug, sondern Teil des digitalen Diskurses selbst, in dem Wahrheit verhandelt, geteilt und neu ausgehandelt wird – ein Wendepunkt für unsere Gesellschaft.

Je realistischer diese Fiktionen werden, desto brüchiger wird unser Vertrauen in das, was wir sehen. „Wer einmal lügt, dem glaubt man nicht“ ist das Credo. Was bedeutet das für unser Wahrheitsempfinden? Für unseren journalistischen Diskurs, unser kulturelles Gedächtnis, unsere gesellschaftliche Orientierung? Und wie problematisch ist es für uns, als Menschen, wenn wir nichts und niemandem mehr glauben können?

„Welcome to the era of fakery. The widespread use of instant video generators like Sora will bring an end to visuals as proof.“

Brian X. Chen in NY Times: https://www.nytimes.com/2025/10/09/technology/personaltech/sora-ai-video-impact.html

What’s True? — Die Desorientierung im Zeitalter synthetischer Inhalte

In der Kunst, allen voran in der Medienkunst, hat KI längst Einzug gehalten. Bei Ars Electronica wird KI nicht als Ersatz für menschliche Erzähler*innen und ihre Kreativität verstanden, sondern als Werkzeug der Reflexion – als Medium, das uns zwingt, die Mechanismen von Wahrnehmung, Macht und Wahrheit neu zu denken – und als kollaboratives Hilfsmittel, das Künstler*innen dabei unterstützt, ihre Geschichten zu erzählen und zu entwickeln.

Dieses Verständnis zeigt sich in zahlreichen Projekten: von künstlerischen Auseinandersetzungen mit algorithmischer Kontrolle und Datenethik bis hin zu immersiven Installationen.

The End of Seeing — Wenn Sehen nicht mehr Glauben heißt

„Our brains are wired to believe what we see — but we must now learn to pause and think.“

Ren Ng, University of California, Berkeley

Seit Anbeginn der Menschheit galt das Sehen als Beweis. „Pics or it didn’t happen“ war der unangefochtene Glaubenssatz einer visuellen Kultur, die dem Bild vertraute. Doch mit generativer KI bricht dieses Paradigma endgültig zusammen: „Nothing you see is real.“

KI-Bilder und -Videos zerstören die Evidenz des Sehens. Dashcam-Aufnahmen, Deepfakes mit Martin Luther King Jr. oder täuschend echte Fake-News-Clips — sie alle untergraben die Idee einer gemeinsamen visuellen Wahrheit. Eine Gesellschaft, die dringend Konsens braucht, verliert damit ihr Fundament: das Vertrauen in die Wahrnehmung. Oder: Wenn das Auge nicht mehr unterscheiden kann, was real ist, muss das kritische Hinterfragen übernehmen – eine Fähigkeit, die zur neuen und ab sofort wichtigsten kulturellen Kompetenz wird um unseren Alltag zu navigieren.

Selbst die Ikonen unserer Zeit bleiben nicht verschont: Martin Luther King’s berühmte Brandrede beim March auf Washington, oder: Das Bild des Papstes in einem weißen Balenciaga-Mantel ging 2023 um die Welt – ein KI-generiertes Meme, das Millionen faszinierte und gleichzeitig verunsicherte.

Für die Künstlerin Martyna Marciniak war dieses Bild der Ausgangspunkt ihrer Arbeit “Anatomy of Non-Fact”. Mithilfe forensischer, technischer, visueller und historischer Analysen untersucht sie darin, wie Fiktion und Fakt ununterscheidbar werden. In Anlehnung an Jean Baudrillard – „das Reale durch das Imaginäre zu beweisen, Kunst durch Anti-Kunst“ – sucht sie nach einer neuen „Ästhetik der Tatsachen“.

Im ersten Kapitel ihres fast 18-minütigen Videos steht der gefälschte Balenciaga-Papst im Zentrum. Marciniak zerlegt die Mechanismen von KI-Generierung, journalistischer Bildsprache und digitalem Klonen – und lässt den künstlichen Papst selbst über die Natur der Wahrheit reflektieren. So wird das synthetische Bild zum Spiegel unserer eigenen Wahrnehmungskrise.

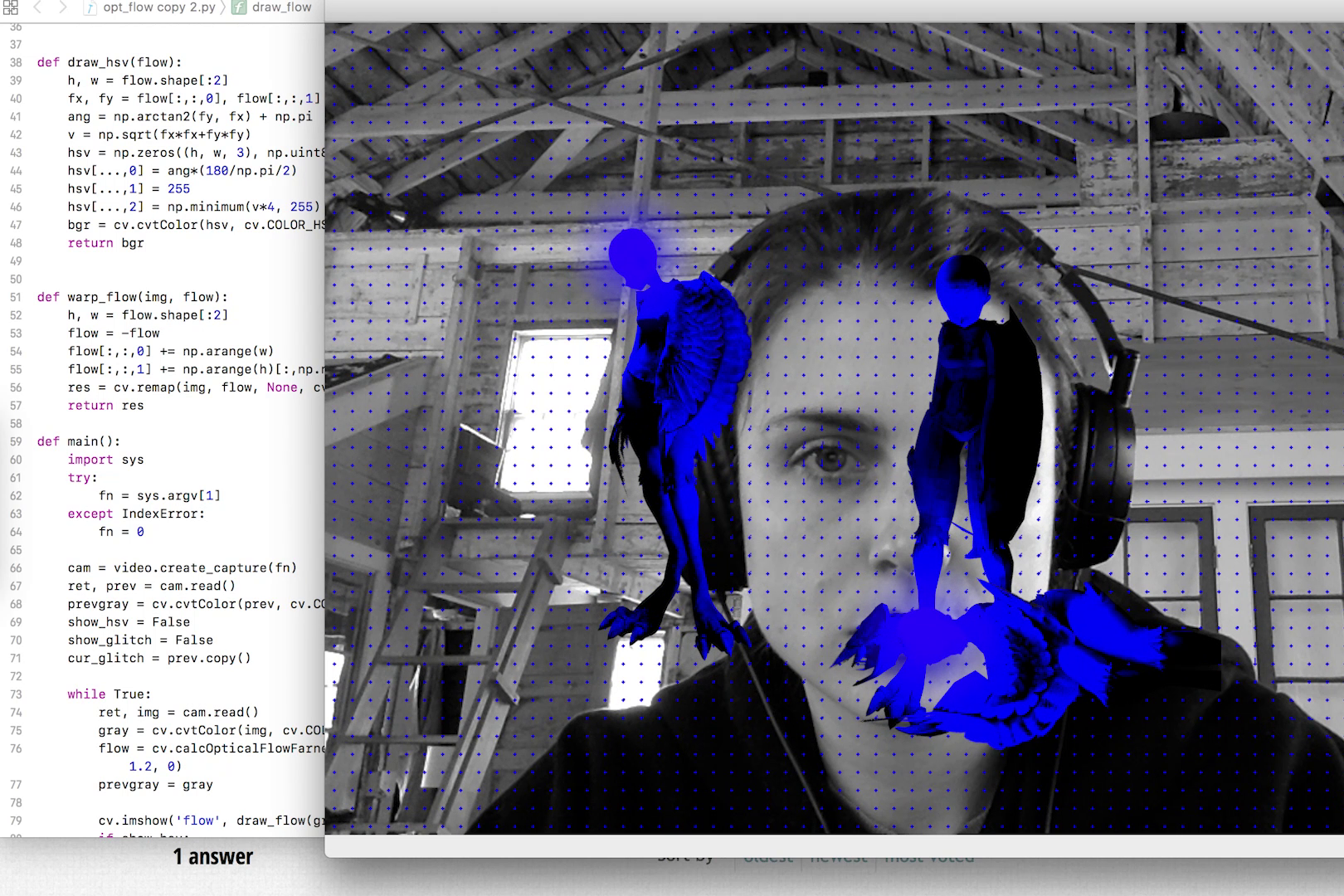

Auch Rachel Rossins Arbeit “Recursive Truth” reagiert auf die Ära der generativen Bilder – und nutzt deren Mittel gegen sie selbst. Mit Videospiel-Mods, OPENCV-Bibliotheken für Gesichtserkennung und Deepfake-Techniken untersucht Rossin, wie Erinnerung, Verlust und Wahrheit in digitalen Systemen entstehen und zerfallen. In ihren 2:55 Minuten langen Loops offenbaren grafische Fehler und Code-Bugs die Fragilität von Erinnerung – sie zerstören das Spiel oder mutieren zu reinen visuellen Glitches.

The Collapse of Consensus — Demokratie ohne gemeinsame Realität

„Without facts, you can’t have truth; without truth, you can’t have trust.

Maria Ressa, Athens Democracy Forum

Without these three, we have no shared reality. You cannot have democracy.“

Demokratie lebt nicht von Einigkeit, sondern davon, dass wir dieselbe Realität teilen – auch wenn wir unterschiedlicher Meinung darüber sein mögen. Demokratie stirbt nicht, wenn wir uns nicht einig sind, sondern wenn wir nicht mehr von derselben Realität sprechen.

Genau hier beginnt die Problematik in Zusammenhang mit generativer KI – sie und unsere menschliche Auffassung von den generierten Inhalten stellen einen potenziellen Angriff auf das demokratische Selbstverständnis dar. Dabei muss man zwischen zwei Aspekten unterscheiden: Erstens war das Fälschen von Inhalten – seien es Texte, Bilder oder Videos – zwar schon lange möglich, aber aufwändig und schwierig, weshalb es entsprechend selten vorkam. Mit generativer KI kann das nun jeder in Sekundenschnelle tun und dabei professionelle Ergebnisse erzielen – das ist neu. Zweitens sorgen soziale Medien, in die diese KI-Generatoren eingebettet sind, für die unmittelbare und massenhafte Verbreitung solcher Inhalte. Wenn angebliche Fakten beliebig produzierbar werden und es keinen Konsens über die Realität mehr gibt, droht die Öffentlichkeit zu zerfallen. Emotionen werden algorithmisch verstärkt, Informationsräume fragmentieren, Debatten verlieren ihren gemeinsamen Boden.

Der Social Media Watchblog beschreibt mit Blick auf die US-Wahl 2024, dass fragmentierte Öffentlichkeit die gemeinsame Debatte ersetzt habe. Influencer würden zu neuen Gatekeepern, während – wie Maria Ressa sagt – „eine Atombombe in unserem Informationsökosystem explodiert ist.“

Nandita Kumars Arbeit „From Paradigm to Paradigm, into the Biomic Time“ fügt sich in diesen Zusammenhang ein: Sie zeigt, wie manipulierte und wiederholte Fehlinformationen unsere Wahrnehmung von Umwelt und Realität verzerren. Kumar verwandelt diese „falschen Fakten“ in algorithmisch erzeugte Klang- und Textfragmente – eine ästhetische Metapher für den Verlust gemeinsamer Wahrheit. Sie macht hörbar, wie Desinformation Vertrauen erodiert, gesellschaftliche Spaltung vertieft und die Grenzen zwischen Wissen und Glauben zunehmend verschwimmen lässt.

Auch der Künstler Andy Gracie greift dieses Thema in seinem Werk Massive Binaries auf, das beim Ars Electronica Festival 2023 gezeigt wurde und im Rahmen der Randa Art|Science Residency (Institut Ramon Llull & Ars Electronica) entstand.

Zwei Neutronensterne, die einander umkreisen, dienen ihm als Metapher für eine polarisiert gespaltete Gesellschaft: „Science believers vs. deniers“, „left vs. right“. Wie die Sterne nähern sich die Lager an, stoßen sich ab und kollidieren schließlich – ein Sinnbild für den Verlust gemeinsamer Realität. Gracie zeigt KI in einer doppelten Rolle: als Werkzeug der Erkenntnis in der wissenschaftlichen Datenanalyse und als Verzerrer der Wahrheit in Form von Fake News und ideologischen Echokammern. Dieselbe Technologie kann Wissen fördern oder Desinformation verstärken.

In Massive Binaries diskutieren zwei KI-generierte Figuren endlos mit- (oder vielmehr gegen-) einander – ein ästhetisches Symbol für die algorithmische Polarisierung öffentlicher Debatten. Das Werk wird so zur poetisch-wissenschaftlichen Allegorie auf den Zusammenbruch des Konsenses: Wahrheit wird zum Orbit aus konkurrierenden Realitäten – angetrieben, verstärkt und verzerrt durch KI.

The Human in the Loop – Berichterstattung zwischen Algorithmus und Verantwortung

Eine der größten Ängste, die wir Menschen in Bezug auf Künstliche Intelligenz haben, ist, dass wir die Kontrolle verlieren. Dass Technologie nicht länger Werkzeug, sondern Akteur wird – ein System, das sich verselbstständigt, die Bias in den Datensätzen reproduziert und damit Fehler potenziert.

Besonders deutlich zeigt sich diese Spannung im Journalismus – dort, wo Fakten eigentlich überprüft, statt generiert werden sollten. Was passiert, wenn Nachrichten nicht mehr recherchiert, sondern synthetisch erzeugt werden?

APA-Chefredakteurin Katharina Schell bringt es auf den Punkt: „KI kann Journalismus unterstützen, aber nicht ersetzen. Human in the Loop bleibt Pflicht.“ Damit beschreibt sie das zentrale Prinzip: Der Mensch (bzw. der*die Journalist*in) darf nicht aus der Schleife verschwinden. Er bleibt Korrektiv, Verantwortungsträger, Deuter der Wahrheit. Im Umgang mit generativen Inhalten schlägt sie wie viele andere ihrer Branche einen Strategiewechsel vor: „Fight fire with fire!“ Man nutzt dieselbe Technologie, um ihre eigenen Produkte zu entlarven. Journalistische Tools sollen KI-generierte Texte automatisch erkennen, Bilder oder Videos anhand formaler und semantischer Muster entlarven.

Der Reporter’s Guide to Detecting AI-Generated Content etwa listet sieben Kategorien solcher Hinweise auf – von anatomischen Unstimmigkeiten in Bildern bis hin zu fehlerhafter Kontextlogik, zu verwenden wie ein Handbuch – ein Werkzeug, das mit derselben Präzision arbeitet wie die Technologie, die es überprüft. Ob das ein praktikabler – und nicht zuletzt auch zeitsparender – Weg ist, wird sich zeigen.

Der Glaube an Relevanz und Bedeutung des professionellen Journalismus, an seine Werte und Prinzipien, ist aber nicht „verloren“, wie etwa eine Studie des Centre for Economic Policy Research (CEPR) zeigt, denn mit der Zunahme von Fake News steigt auch der Wert von Vertrauen und Qualitätsjournalismus. Was kostbarerer, weil rarer, wird, gewinnt an Bedeutung.

Das Projekt „Die KI-Wahrheitsmaschine“ greift diese Spannung exemplarisch auf. In einem fiktiven Gerichtsprozess stellt es menschliches und algorithmisches Urteilen gegenüber und fragt: Kann eine Maschine Wahrheit erkennen?

Dafür wird eine Person vor der Befragung durch die „KI-Wahrheitsmaschine“ aufgefordert, zu einem vorgegebenen Thema zu lügen. Der KI-gestützte Prozess der Wahrheitsfindung unterscheidet sich von der richterlichen Befragungsmethodik in der äußerst präzisen Analyse der Augenbewegungen und Pupillenveränderungen während eines Verhörs. Nach Absolvierung der Befragung wird das Ergebnis präsentiert und es soll die Frage geklärt werden, ob eine KI tatsächlich einen Richter*in ersetzen kann.

Das Werk zeigt, dass Wahrheit nicht automatisiert werden kann. Entscheidend bleibt, wer die Systeme steuert, interpretiert und verantwortet und es erinnert daran, dass zwischen Algorithmus und Urteil, zwischen Daten und Deutung, immer ein Mensch stehen muss.

Die Haltung, die daraus folgt, ist ebenso einfach wie essenziell: KI soll Werkzeug sein, auch im Journalismus – nicht aber die Brille, durch die wir die Welt sehen. Sie kann Daten strukturieren, aber keine Verantwortung übernehmen und sie kann keine Wahrheit erzeugen, denn die Wahrheit entsteht erst dort, wo Menschen Fakten anzweifeln, prüfen, abwägen.

The Accountability Gap — Wer trägt Verantwortung in der KI-Öffentlichkeit?

„AI systems are being built and deployed without responsible decision-makers behind them: algorithms decide, but no one is held accountable.“

Timnit Gebru in https://www.wired.com/story/rewired-2021-timnit-gebru/

Eine Frage, die sich durch alle Debatten rund um KI zieht, ist jene nach der Verantwortung.

Im professionellen Journalismus ist klar geregelt, wer für Inhalte haftet: Journalist*innen, Redaktionen, Herausgeber*innen. Doch in der Welt generativer Systeme und sozialer Plattformen verschwimmen diese Grenzen zunehmend: Bei KI-generierten Texten, Bildern oder Videos ist oft weder nachvollziehbar, wer sie erstellt, noch wer sie verbreitet. Während im Journalismus die Verantwortung personifiziert ist, endet sie in der digitalen Öffentlichkeit meist bei einem Nutzungs-Disclaimer. Rechtliche Regelungen wie die amerikanische Section 230, die Plattformen weitgehend von der Haftung für veröffentlichte Inhalte befreit, verschärfen dieses Ungleichgewicht.

So entsteht ein Verantwortungsvakuum zwischen Mensch, Maschine und Medium:

Wer trägt Schuld, wenn Desinformation sich viral verbreitet? Die Entwickler*innen? Die Plattformen? Die Nutzer*innen, die teilen, was sie glauben wollen?

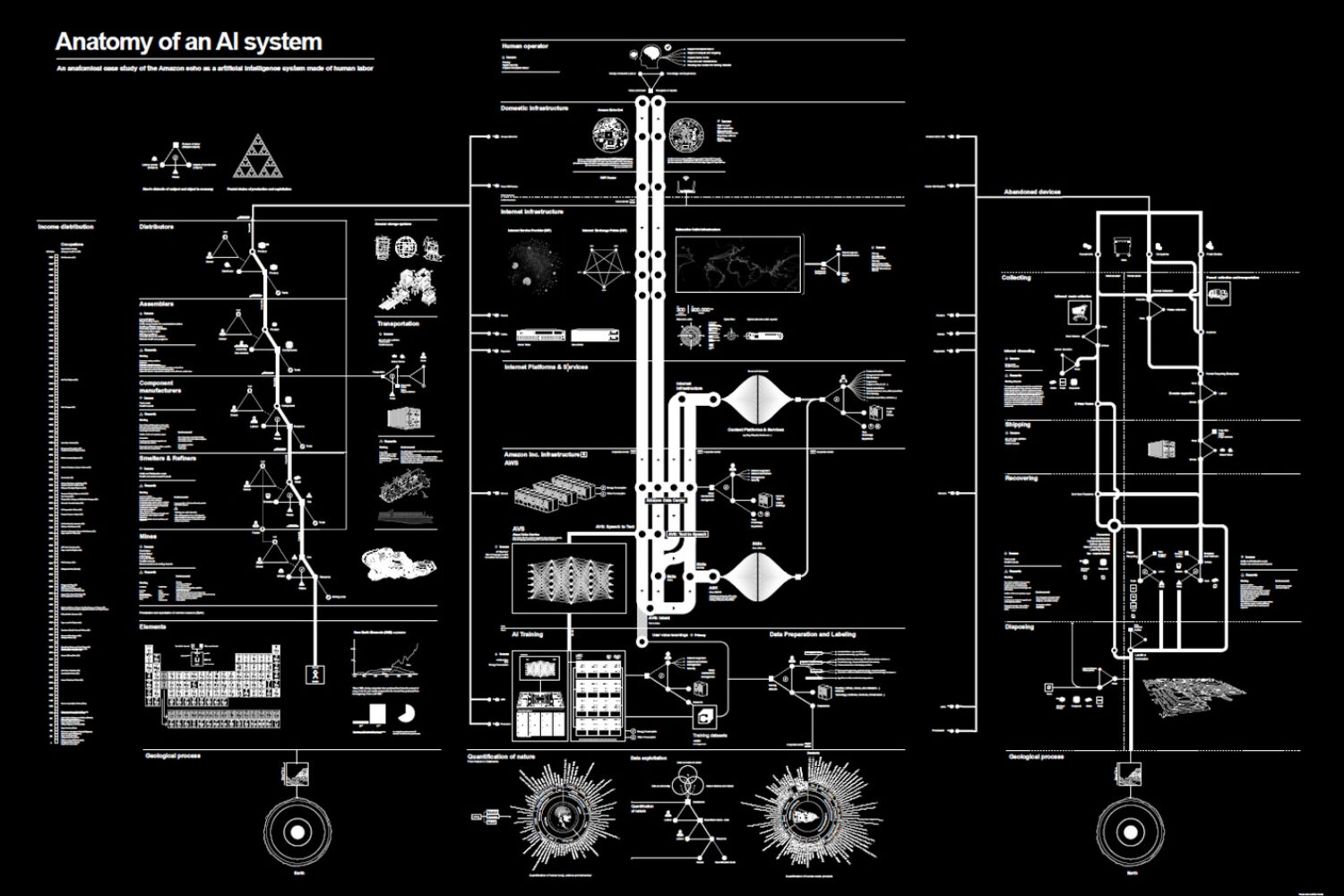

Wie die KI-Forscherin Kate Crawford betont, ist Künstliche Intelligenz weder künstlich noch autonom:

„AI is neither artificial nor intelligent. It is made from natural resources and it is people who are performing the tasks to make the systems appear autonomous.“

Kate Crawford, The Guardian, 2021

Kate Crawford erinnert daran, dass hinter jeder KI menschliche Arbeit, politische Entscheidungen und ökologische Kosten stehen – und damit auch Verantwortung. Ihr Projekt „Anatomy of an AI System“ (2018, mit Vladan Joler) macht diese unsichtbaren Strukturen sichtbar: Anhand des Amazon Echo kartiert sie die globalen Ressourcen-, Daten- und Machtverhältnisse hinter scheinbar autonomen Technologien. Das Werk zeigt eindrücklich, dass KI nicht unabhängig handelt, sondern auf einem dichten Geflecht menschlicher Verantwortlichkeiten beruht.

In Droning von Marta Revuelta (in Kollaboration mit Laurent Weingart) wird KI-Vision zu einem Spiegel unserer Verantwortlichkeitslücken: Ein heliumgefülltes Luftschiff, inspiriert von militärischen Überwachungsblimps, klassifiziert Besucher*innen in Echtzeit als „feindliche Kämpfer*innen“ oder „neutrale Zivilist*innen“. Das System beruht auf Trainingsdaten aus realen Kampfaufnahmen und simulierten Angriffsentscheidungen – und macht sichtbar, wie menschliches Leben im Algorithmus auf Datenpunkte reduziert wird. In diesem Moment wird das Thema Accountability zentral: Wer trägt Verantwortung, wenn eine Maschine entscheidet? Wer steht hinter der Klassifizierung und wer hinter den Konsequenzen? Droning rückt damit nicht nur die technische Überwachung ins Zentrum, sondern auch die polit-ethische Frage, welche Machtstrukturen autonome Technologien realisieren und entlasten können.

The New Literacy — Medienpädagogik als Demokratiekompetenz

Wenn Maschinen Geschichten erfinden, müssen Menschen lernen, sie zu lesen.

Diese Fähigkeit – Medienkompetenz, kritisches Denken, Vertrauen – wird zur Demokratiekompetenz unserer Zeit. Oder, wie Jaro Krieger-Lamina (ÖAW) betont: „Die zwei entscheidenden Faktoren (im Umgang mit KI, Anm.) sind Medienkompetenz und Vertrauen.“

Diese Theorie ist nicht neu, sondern geht bereits auf die Inoculation Theory von Lewandowsky & Van der Linden zurück: Medienkompetenz als „Impfung gegen Desinformation“. Am Lehrplan müssen Dinge stehen wie die Förderung des kritischen Denkens, Quellenbewertung oder emotionale Selbstregulation im Informationsfluss. Die wichtigste „Firewall“ gegen Desinformation sitzt nicht im Code, sondern im Kopf.

Superpoderosas von Maldita.es ist ein journalistisch-pädagogisches Projekt, das Menschen befähigt, Desinformation aktiv zu erkennen und zu bekämpfen. Es kombiniert KI-gestützte Tools mit kollaborativem Faktencheck und macht Bürger*innen zu Mitgestalter*innen einer informierten Öffentlichkeit. Dabei geht es nicht nur um das Aufdecken falscher Inhalte, sondern um das Erlernen einer kritischen Haltung gegenüber digitalen Informationen. Das Projekt verbindet Technologie, Bildung und Gemeinschaft, um Vertrauen, Verantwortung und Wahrheitsbewusstsein in der digitalen Gesellschaft zu stärken.

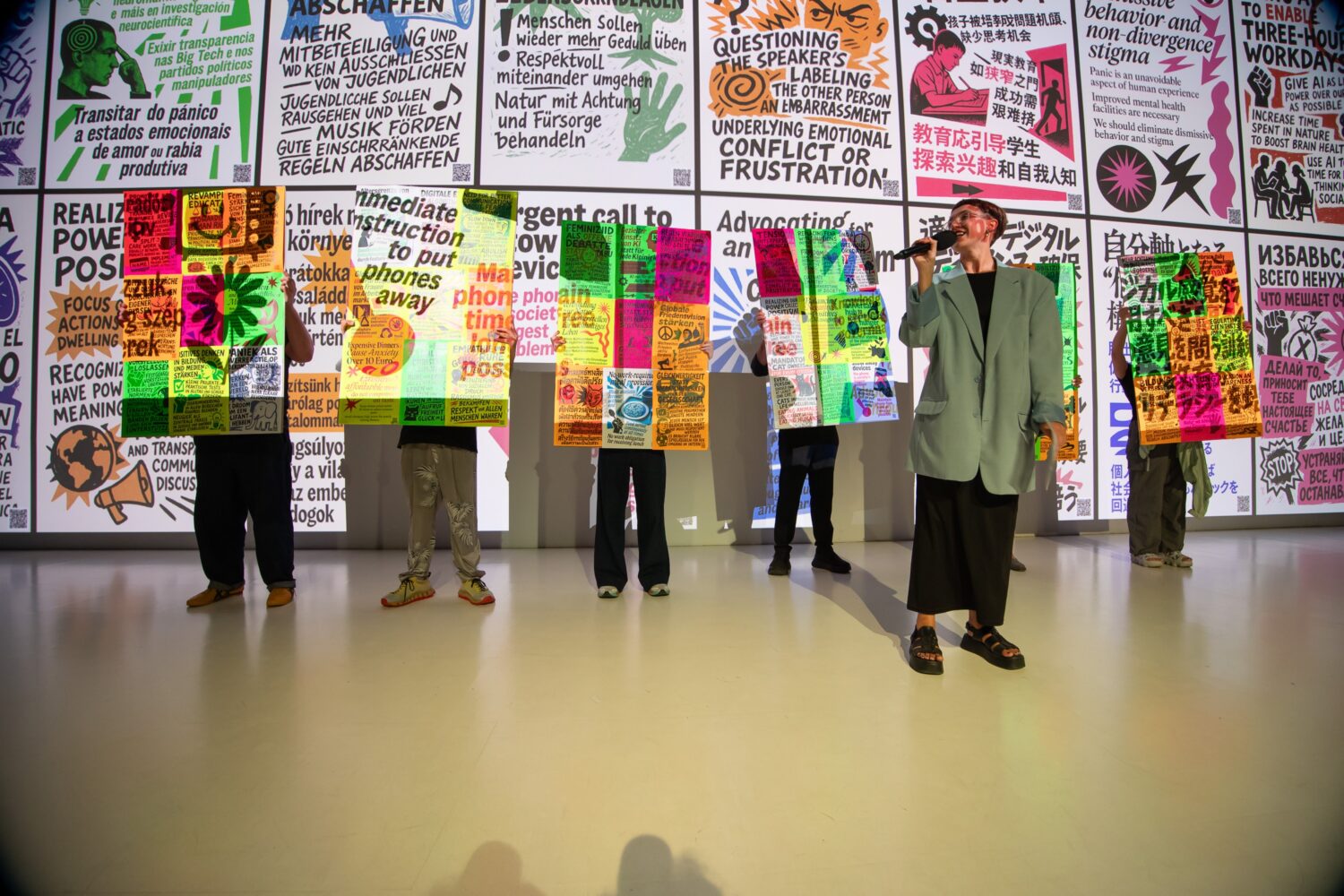

Ein weiteres Beispiel für demokratische Medienkompetenz ist das Citizen Manifesto des Ars Electronica Futurelab. Hier werden Besucher*innen eingeladen, ihre persönlichen Zukunftsvisionen und gesellschaftlichen Wünsche zu formulieren – unterstützt von generativer KI. Die Maschine verwandelt ihre Antworten in visuelle Manifeste, die vor Ort gedruckt oder online geteilt werden können. So entsteht ein kollektiver, von KI mitgestalteter Dialog darüber, wie wir leben wollen. Das Projekt zeigt, dass digitale Kompetenz heute mehr bedeutet als Technikverständnis – sie ist die Fähigkeit, KI kreativ, kritisch und gemeinschaftlich für gesellschaftliche Teilhabe zu nutzen. „The process demonstrates how generative AI can support open communication and societal discourse while making the creation journey transparent—from conversation to poster.“

Reclaiming Truth — KI als Werkzeug der Wahrheitsfindung

„Generative AI is both blessing and curse.“

Paper „Blessing or Curse?“ (Loth et al., 2024)

Was wir lehren, entscheidet, was wir glauben – und damit, wie wir Wahrheit künftig verteidigen. Mit den richtigen Werkzeugen gegen Desinformation in der Hand, sieht es so aus, als bestünde Hoffnung für die kollektive Wahrheit. Als könnten wir das Ruder herumreißen und die Sicht auf die Wirklichkeit wieder für uns beanspruchen. Und das Paradoxe daran: Genau KI könnte, wie im Kapitel „The Human Loop“ beschrieben, ein Mittel dabei sein, Wahrheit zu schützen, statt sie zu zerstören.

Ob Blockchain-Zertifikate, digitale Signaturen oder Wasserzeichen für journalistische Inhalte – technologische Ansätze zur Sicherung von Authentizität entstehen bereits. Doch sie greifen zu kurz, wenn wir nur die supply side – also die Produktion von Fakes – bekämpfen. Ebenso entscheidend ist die demand side: unser menschliches Bedürfnis nach Bestätigung, Zugehörigkeit und emotionaler Resonanz. Das Magazin The Bulletin bringt es auf den Punkt: „Combatting misinformation means designing friction not only into share buttons but also into human psyches.“

Vielleicht war und ist Wahrheit immer schon mehr ein Zustand als eine Haltung – etwas, das aus dem Zusammenspiel von Beobachtung, Reflexion und Überprüfung entsteht. Künstlerische Projekte – von Datenvisualisierungen bis zu performativen Installationen – machen sichtbar, wie sehr unsere Vorstellung von Wahrheit kulturell und technologisch geprägt ist. In diesem Sinne wird Kunst zum Labor gesellschaftlicher Wahrheitsfindung: ein Raum, in dem wir lernen, mit Unsicherheit produktiv umzugehen.

Bei aller Vorsicht und berechtigtem Pessimismus liegt die Zukunft letztlich – wie immer – in unserer Hand. KI ist ein Werkzeug, kein Schicksal. Und vielleicht liegt ihre größte Stärke genau dort, wo sie auch am gefährlichsten sein kann: in der Wahrheitsfindung selbst: Richtig eingesetzt könnte sie helfen, Fakes zu erkennen, Muster zu entlarven und unseren Blick für das Reale zu schärfen. Am Ende aber geht es um mehr als die Frage nach Technologie oder Philosophie: Die Frage nach der Wahrheit ist unser gesellschaftliches Fundament, sie ist essenziell für das Fortbestehen und Funktionieren unserer Demokratie.